Rappresentazione categorica dei metadati per la classificazione personalizzata del testo

Jihyeok Kim*1 Reinald Kim Amplayo*2

Kyungjae Lee1

Sua Sung1 Minji Seo1

Seung-won Hwang1

(* contributo paritario)

1Università di Yonsei

zizi1532@yonsei.ac.kr

2Università di Edimburgo

reinald.kim@ed.ac.uk

l

D

o

w

n

o

un

D

e

D

F

r

o

M

H

T

T

p

:

/

/

D

io

r

e

C

T

.

M

io

T

.

e

D

tu

/

T

un

C

l

/

l

un

r

T

io

C

e

–

p

D

F

/

D

o

io

/

.

1

0

1

1

6

2

/

T

l

un

C

_

un

_

0

0

2

6

3

1

9

2

3

0

4

7

/

/

T

l

un

C

_

un

_

0

0

2

6

3

p

D

.

F

B

sì

G

tu

e

s

T

T

o

n

0

7

S

e

p

e

M

B

e

r

2

0

2

3

{lkj0509,ghiro,gathalminji,seungwonh}@yonsei.ac.kr

Astratto

Le prestazioni della classificazione del testo hanno

migliorato enormemente utilizzando in modo intelligente

modelli ingegnerizzati basati sui neuroni, soprattutto quelli

inserendo metadati categorici come aggiuntivi

informazione, per esempio., utilizzando le informazioni sull'utente/prodotto-

zione per la classificazione del sentiment. Queste informazioni-

è stata utilizzata per modificare parti del file

modello (per esempio., incorporamenti di parole, attenzione mecc-

anismo) in modo tale che i risultati possano essere personalizzati

secondo i metadati. Lo osserviamo

attuali metodi di rappresentazione per categoriale

metadati, che sono concepiti per la truffa umana-

assunzione, non sono così efficaci come affermato in

metodi di classificazione popolari, sovraperformato

anche mediante semplice concatenazione di categoriali

caratteristiche in finale

strato della frase

codificatore. Ipotizziamo che questo sia un fatto categorico-

le strutture sono più difficili da rappresentare per l'uso della macchina,

come il contesto disponibile descrive solo indirettamente

la categoria, e anche tale contesto lo è spesso

scarso (per la categoria coda). A tal fine, noi professionisti-

posa utilizzando vettori di base per incorporare efficacemente-

inserire metadati categorici in varie parti

di un modello a base neurale. Anche questo

diminuisce drasticamente il numero di parametri-

alleato, soprattutto quando il numero di categoria-

le funzionalità cal sono grandi. Esperimenti estesi su

ci sono vari set di dati con proprietà diverse

eseguito e dimostrarlo attraverso il nostro metodo,

possiamo rappresentare maggiormente i metadati categorici

in modo efficace per personalizzare parti del modello,

compresi quelli inesplorati, e aumentare il

notevolmente le prestazioni del modello.

1

introduzione

La classificazione del testo è la spina dorsale della maggior parte della PNL

compiti: rivedere la classificazione nell'analisi del sentiment

201

(Pang et al., 2002), classificazione della carta in sci-

scoperta efficace dei dati (Sebastiani, 2002), E

classificazione delle domande nella risposta alle domande (Li

e Roth, 2002), per dirne alcuni. Mentre la precedente metanfetamine-

gli od richiedono un'ingegneria intensiva delle funzionalità, recente

i metodi godono dell'estrazione automatica delle funzionalità

dal testo utilizzando modelli basati sui neurali (Socher et al.,

2011) codificando i testi in bassa dimensione

vettori di caratteristiche dense.

Questo articolo discute le classi di testo personalizzate-

sificazione, generalizzato da testo personalizzato

classificazione (Baruzzo et al., 2009), dove noi

personalizzare i classificatori in base a possibilmente multipli

diverse informazioni sui metadati categorici noti

informazioni per il sentimento

(per esempio., utente/prodotto

classificazione) invece delle sole informazioni dell'utente.

Come mostrato in figura 1, oltre al testo,

viene fornito un elenco di un classificatore di testo personalizzabile

categorie specifiche del testo per prevederne la classe.

Lavori esistenti a cui sono state applicate informazioni sui metadati

migliorare le prestazioni di un modello, ad esempio

utente e prodotto (Tang et al., 2015) informazione

nella classificazione del sentimento, e autore (Rosen-

Zvi et al., 2004) e pubblicazione (Joorabchi e

Mahdi, 2011) informazioni nella classificazione della carta.

Verso il nostro obiettivo, siamo ispirati dall'annuncio-

avanzamento nei modelli basati sui neurali, incorporato-

fornire informazioni categoriche “così come sono” e iniettarle

it su varie parti del modello come nel

incorporamenti di parole (Tang et al., 2015), Attenzione

meccanismo (Chen et al., 2016; Amplayo et al.,

2018un) e reti di memoria (Do, 2017).

questi metodi teoricamente fanno uso

Infatti,

di caratteristiche combinate sia testuali che

categorico

features, che li rendono di più

funzionalità potenti rispetto a quelle disconnesse. Tuttavia,

i metadati vengono generati per la comprensione umana,

e quindi affermiamo che queste categorie necessitano

da rappresentare con attenzione per l'uso della macchina

Operazioni dell'Associazione per la Linguistica Computazionale, vol. 7, pag. 201–215, 2019. Redattore di azioni: Bo Pang.

Lotto di invio: 11/2018; Lotto di revisione: 1/2019; Presentazione finale: 2/2019; Pubblicato 4/2019.

C(cid:2) 2019 Associazione per la Linguistica Computazionale. Distribuito sotto CC-BY 4.0 licenza.

l

D

o

w

n

o

un

D

e

D

F

r

o

M

H

T

T

p

:

/

/

D

io

r

e

C

T

.

M

io

T

.

e

D

tu

/

T

un

C

l

/

l

un

r

T

io

C

e

–

p

D

F

/

D

o

io

/

.

1

0

1

1

6

2

/

T

l

un

C

_

un

_

0

0

2

6

3

1

9

2

3

0

4

7

/

/

T

l

un

C

_

un

_

0

0

2

6

3

p

D

.

F

B

sì

G

tu

e

s

T

T

o

n

0

7

S

e

p

e

M

B

e

r

2

0

2

3

Figura 1: Un framework di modelli di alto livello per l'attività di classificazione del testo personalizzata che inserisce un testo con n

gettoni (per esempio., revisione) em categorie (per esempio., utenti, prodotti) e restituisce una classe (per esempio., positivo negativo). Esempio

le attività sono mostrate a sinistra della figura.

migliorare le prestazioni del classificatore di testo

effettivamente.

Primo, invalidiamo empiricamente i risultati di

studi precedenti mostrando nei nostri esperimenti

su più set di dati utilizzati dai metodi più diffusi

le categorie di metadati "così come sono" hanno prestazioni peggiori di

una semplice concatenazione di testuale e categorico

vettori di caratteristiche. Sosteniamo che ciò sia dovuto a

ottimizzate le difficoltà del modello nell'apprendimento

rappresentazione vettoriale densa del categorico

caratteristiche che devono essere utilizzate dal modello di classificazione.

Le ragioni sono duplici: (un) caratteristiche categoriche

non hanno un contesto diretto e quindi si basano esclusivamente

sulle etichette di classificazione durante l'addestramento della funzionalità

vettori, E (B) ci sono informazioni categoriche

che sono scarsi e quindi non possono apprendere in modo efficace

vettori di caratteristiche ottimali.

Secondo, suggeriamo una rappresentazione alternativa-

tazione, utilizzando vettori di base a bassa dimensionalità per

mitigare i problemi di ottimizzazione delle categorie

vettori di caratteristiche. I vettori base hanno proprietà interessanti

che può risolvere i problemi presentati qui perché

Essi (un) trasformare più categorie in utili

combinazioni, che servono da contesto reciproco per tutti

categorie, E (B) inizializzare in modo intelligente i vettori,

soprattutto di scarse informazioni categoriche, A

una posizione non ottimale per addestrarli in modo efficiente

ulteriore. Inoltre, il nostro metodo riduce il

numero di parametri addestrabili e quindi è flessibile-

ible per qualsiasi tipo e qualsiasi numero di disponibili

categorie.

Sperimentiamo più attività di classificazione

con diverse proprietà e tipologie di categoria-

disponibili. I nostri esperimenti lo dimostrano mentre

metodi di personalizzazione utilizzando informazioni categoriche-

mation “così com’è” non funziona così come il

metodo di concatenazione ingenuo, applicando il nostro professionista-

il metodo di personalizzazione base posto li rende

molto più efficace del metodo ingenuo. Nostro

Il metodo consente anche l'uso di meta categoriali-

dati per personalizzare altre parti del modello, come

come pesa l'encoder, che sono precedentemente un-

esplorati a causa della loro elevata complessità spaziale e

prestazione debole. Mostriamo che questo è inesplorato

l'uso della personalizzazione supera i popolari e i contro-

metodi convenzionali come il meccanismo dell’attenzione

quando il nostro metodo di personalizzazione di base proposto

si usa.

202

2 Preliminari

2.1 Problema: Classificazione del testo personalizzata

L'attività di classificazione del testo originale è definita

come segue: Dato un testo W = {w1, w2, …, wn},

abbiamo il compito di addestrare una funzione di mappatura f (W )

predire una classe y ∈ corretta {y1, y2, …, sì}

tra le classi p. Il testo personalizzato

il compito di classificazione fa uso del categorico

A

informazioni sui metadati allegate al testo

personalizzare la funzione di mappatura. in questo documento,

definiamo i metadati categorici come non continui

informazioni che descrivono il testo.1 Un esempio

l'attività è rivedere la classificazione del sentiment con l'utente

e informazioni sul prodotto come metadati categorici.

Formalmente, dato un testo t = {W, C}, Dove

W = {w1, w2, …, wn}, C = {c1, c2, …, cm}, wx

è l'xesimo degli n token nel testo, e cz è il

etichetta di categoria del testo nella zesima categoria di

le m categorie disponibili, l'obiettivo della personalizzazione

la classificazione del testo consiste nell'ottimizzare una funzione fC(W )

prevedere un'etichetta y, dove fC(W ) è il classificatore

dipendente con C. Nel nostro compito di esempio, W è il

rivedere il testo, e abbiamo m = 2 categorie dove

c1 e c2 sono le informazioni sull'utente e sul prodotto.

Questo è un problema interessante a causa del

vaste opportunità che offre. Primo, siamo moti-

vated per utilizzare metadati categorici perché esistono-

ing lavoro ha dimostrato che ulteriori non testuali

informazione, come i tag POS (Vai et al., 2009)

e argomenti latenti (Zhao et al., 2017), può essere utilizzata

come forte supervisione supplementare per migliorare

l’esecuzione della classificazione del testo. Secondo,

mentre le informazioni aggiuntive utilizzate in precedenza lo sono

sono entrambi i domini-

trovato utile,

dipendente o molto rumoroso (Amplayo et al., 2018B).

D'altra parte, i metadati categorici sono

di solito informazioni fattuali e valide che lo sono

né inerente (per esempio., informazioni sull'utente/prodotto)

o etichettato come umano (per esempio., area di ricerca). Finalmente,

l'attività di classificazione del testo personalizzata si generalizza

il problema della personalizzazione (Baruzzo et al.,

2009), dove invece di personalizzare in base a

informazioni sul singolo utente, personalizziamo in base a

1Limitiamo il nostro ambito ai testi con metadati categorici

informazione (Recensioni dei prodotti, articoli di notizie, tweet, eccetera.),

che copre la maggior parte dei testi sul Web. Testi senza

i metadati possono utilizzare informazioni categoriche previste, ad esempio

argomenti da un modello di argomenti, che sono comunemente usati (Zhao

et al., 2017; Chou et al., 2017). Tuttavia, perché la previsione-

l'operazione potrebbe essere errata, i miglioramenti delle prestazioni non possono essere garantiti-

teed. Lasciamo l'indagine di quest'area nei lavori futuri.

possibilmente più categorie, che può o può

non includere informazioni sull'utente. Questo di conseguenza

crea un'opportunità di sviluppo personalizzabile

assistenti virtuali (Papacharissi, 2002).

2.2 Classificatore di base: BiLS™

Utilizziamo una memoria bidirezionale a lungo termine

(BiLS™) rete (Hochreiter e Schmidhuber,

1997) come nostro classificatore di testo di base, come è stato dimostrato

funzionano bene sulla classificazione delle sequenze di testo (Zhou

et al., 2016). Sebbene i metodi che sono

qui descritti si applicano ad altri classificatori efficaci

anche, come le reti neurali convoluzionali

(CNN) (Kim, 2014) e modelli gerarchici

(Yang et al., 2016), limitiamo i nostri esperimenti

a BiLSTM per coprire risultati più importanti.

Il nostro classificatore BiLSTM inizia codificando il file

incorporamenti di parole utilizzando un avanti e un indietro-

reparto LSTM. Le coppie di vettori risultanti sono

concatenato per ottenere la parola codificata finale vec-

tori, come mostrato qui:

noi ∈ W

−→

h i = LST Mf (wi,

←−

h i = LST Mb(wi,

−→

CIAO;

←−

CIAO]

ciao = [

−→

h i−1)

←−

h i+1)

(1)

(2)

(3)

(4)

Prossimo, mettiamo in comune i vettori di parole codificate ciao

un vettore di testo d che utilizza un meccanismo di attenzione

(Bahdanau et al., 2015; Luong et al., 2015), Quale

calcola i punteggi di importanza utilizzando un contesto latente

vettore x per tutte le parole, normalizza i punteggi utilizzando

softmax, e li usa per fare la somma ponderata

vettori di parole codificate, come mostrato:

no = x(cid:6)CIAO

ai =

d =

(cid:2)

esp(NO)

j esp(es)

(cid:3)

ciao ∗ tu

(5)

(6)

(7)

io

Finalmente, utilizziamo un classificatore di regressione logistica per

classificare le etichette utilizzando la matrice del peso appreso W (C)

e vettore di polarizzazione b(C):

sì(cid:8) = W (C)D + B(C)

(8)

Possiamo quindi addestrare il nostro classificatore utilizzando qualsiasi gradiente

algoritmo di discesa minimizzando il log negativo

probabilità del log softmax delle etichette previste

sì(cid:8) rispetto alle etichette effettive y.

203

l

D

o

w

n

o

un

D

e

D

F

r

o

M

H

T

T

p

:

/

/

D

io

r

e

C

T

.

M

io

T

.

e

D

tu

/

T

un

C

l

/

l

un

r

T

io

C

e

–

p

D

F

/

D

o

io

/

.

1

0

1

1

6

2

/

T

l

un

C

_

un

_

0

0

2

6

3

1

9

2

3

0

4

7

/

/

T

l

un

C

_

un

_

0

0

2

6

3

p

D

.

F

B

sì

G

tu

e

s

T

T

o

n

0

7

S

e

p

e

M

B

e

r

2

0

2

3

2.3 Linea di base 1: BiLSTM concatenato

Per incorporare le categorie nel classificatore,

un metodo semplice e ingenuo è concatenare i file

caratteristiche categoriali con il vettore testo d. Fare

Questo, creiamo spazi di inserimento per il dif-

categorie diverse e ottenere i vettori delle categorie

c1, c2, …, cm in base alle etichette di categoria del testo

D. Utilizziamo quindi il vettore concatenato come caratteristiche

per il classificatore di regressione logistica:

sì(cid:8) = W (C)[D; c1; c2; …; cm] + B(C)

(9)

2.4 Linea di base 2: BiLS™ personalizzato

Sebbene il BiLSTM concatenato sia facilmente realizzabile

utilizzo delle categorie come funzionalità aggiuntive per

il classificatore, non è in grado di sfruttare il

possibili dipendenze di basso livello tra testo

e caratteristiche categoriche.

Ce ne sono diversi

livelli di dipendenze

tra testi e categorie. Per esempio, Quando

prevedere il sentimento di una recensione “Il cibo è

molto dolce,'' dato l'utente che ha scritto la recensione,

il classificatore dovrebbe fornire un'etichetta positiva se l'utente

gli piacciono i cibi dolci e altrimenti un'etichetta negativa.

In questo caso, la dipendenza tra la recensione

e l'utente è al livello più alto, dove noi

esaminare le relazioni tra il testo completo e il

categorie. Un altro esempio è quando si prevede

l'accettazione di un documento di ricerca dato che il

L’area di ricerca è la PNL, il classificatore dovrebbe concentrarsi

di più sulle parole della PNL (per esempio., lingua, testo) Piuttosto

rispetto a parole meno correlate (per esempio., biologia, chimica).

In questo caso, la dipendenza tra la ricerca

carta e l'area di ricerca è al livello inferiore,

dove esaminiamo le relazioni tra i segmenti

del testo e delle categorie.

Presentiamo cinque livelli di BiLSTM personalizzato,

che differiscono a seconda del luogo in cui iniettiamo il

caratteristiche categoriche, elencati qui dal più alto

livello al livello più basso di dipendenze tra

testo e categorie. L'idea principale è imporre

pesi specifici della categoria, piuttosto che un singolo

peso a ciascun livello del modello:

1. Personalizza sul vettore bias: A questo livello

di personalizzazione, guardiamo il generale

pregiudizi che le categorie hanno nei confronti del problema-

lem. Come esempio concreto, quando classificare-

il tipo di messaggio scritto da un politico,

lui/lei può essere propenso a scrivere in modo personale

messaggi rispetto ai messaggi politici. Invece di

utilizzando un singolo vettore di polarizzazione b(C) nella logistica

classificatore di regressione (Equazione 8), noi usiamo

ulteriori vettori di bias multipli per ciascuno

category, come mostrato di seguito. Infatti, questo è

nello spirito essenzialmente equivalente a confondere-

denominato BiLSTM (Equazione 9), dove il

la derivazione è:

sì(cid:8) = Collo + bc1 + … + bcm + B(C)

= Collo + Wc1c1 + … + Wcmcm + B(C)

= W (C)[D; c1; c2; …; cm] + B(C)

2. Personalizza sulla trasformazione lineare:

A questo livello di personalizzazione, guardiamo a

la semantica a livello di testo distorce le categorie

Avere. Come esempio concreto, nel sentimento

compito di classificazione, la recensione “Il cibo è

molto dolce’’ può avere un sentimento negativo

se lo fa l'utente che ha scritto la recensione

non come i dolci. Invece di usare un singolo

matrice dei pesi W (C) nei regrediti logistici-

classificatore di sione (Equazione 8), usiamo diversi

matrici di peso per ciascuna categoria:

sì(cid:8) = W (C)

c1

D + W (C)

c2

D + … + W (C)

cm d + B(C)

3. Personalizza il pool di attenzione: A

questo livello di personalizzazione, guardiamo il

i pregiudizi sull'importanza delle parole che le categorie hanno.

Un esempio concreto è, quando si classifica a

documento di ricerca, Le parole della PNL dovrebbero essere focalizzate

di più quando l’area di ricerca è la PNL. Invece

di utilizzare un singolo vettore di contesto x durante il calcolo-

ritardare i punteggi di attenzione e (Equazione 5),

utilizziamo vettori di contesto diversi per ciascuno

category:

CIAO + … + X(cid:6)

cmhi

CIAO + X(cid:6)

no = x(cid:6)

c2

c1

a = morbido tmax(e)

(cid:3)

d =

io

ciao ∗ tu

4. Personalizzare i pesi dell'encoder: A questo

livello di personalizzazione, guardiamo la parola

la contestualizzazione influenza le categorie di cui hanno bisogno.

Un esempio concreto è, dato il testo “profondo”.

apprendimento per la classificazione del messaggio politico-

zione’’, quando si codifica la parola classifica-

zione, il BiLSTM dovrebbe mantenere la semantica

di parole messaggio politico più e dimenticare

la semantica di altre parole più quando

l'area di ricerca riguarda la politica. Invece di

204

l

D

o

w

n

o

un

D

e

D

F

r

o

M

H

T

T

p

:

/

/

D

io

r

e

C

T

.

M

io

T

.

e

D

tu

/

T

un

C

l

/

l

un

r

T

io

C

e

–

p

D

F

/

D

o

io

/

.

1

0

1

1

6

2

/

T

l

un

C

_

un

_

0

0

2

6

3

1

9

2

3

0

4

7

/

/

T

l

un

C

_

un

_

0

0

2

6

3

p

D

.

F

B

sì

G

tu

e

s

T

T

o

n

0

7

S

e

p

e

M

B

e

r

2

0

2

3

utilizzando un unico set di input, dimenticare, produzione, E

pesi delle celle di memoria per ciascun LSTM (Equa-

zioni 2 E 3), usiamo più set di

pesi, uno per ogni categoria:

⎤

⎡

⎤

⎡

⎢

⎢

⎢

⎣

gt

it

piedi

ot

⎥

⎥

⎥

⎦ =

⎢

⎢

⎢

⎣

di pesce

P

P

P

⎥

⎥

⎥

⎦

(cid:10)

(cid:3)

(cid:11)

W (e)

ck

[peso; ht−1] + B

0

ai primi soccorritori e al personale militare che lavora per garantire la nostra sicurezza e che non è in grado di farlo

stare con le loro famiglie durante le festività natalizie. siamo tutti grazie per il vostro servizio e

dedizione.

cs.CR (Crittografia e

Sicurezza)

Rifiutare

Pregiudizio politico

Classificazione

Neutro

Personale

Partigiano

Supporto

Tavolo 5: Testi di esempio dal set di dati AAPR (superiore) e set di dati sui media politici (inferiore) con una variabile

etichetta di categoria (campo di ricerca e pregiudizi politici) che cambia l'etichetta di classificazione.

l

D

o

w

n

o

un

D

e

D

F

r

o

M

H

T

T

p

:

/

/

D

io

r

e

C

T

.

M

io

T

.

e

D

tu

/

T

un

C

l

/

l

un

r

T

io

C

e

–

p

D

F

/

D

o

io

/

.

1

0

1

1

6

2

/

T

l

un

C

_

un

_

0

0

2

6

3

1

9

2

3

0

4

7

/

/

T

l

un

C

_

un

_

0

0

2

6

3

p

D

.

F

B

sì

G

tu

e

s

T

T

o

n

0

7

S

e

p

e

M

B

e

r

2

0

2

3

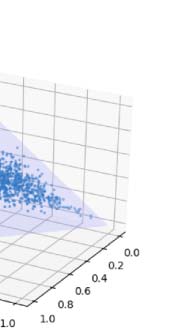

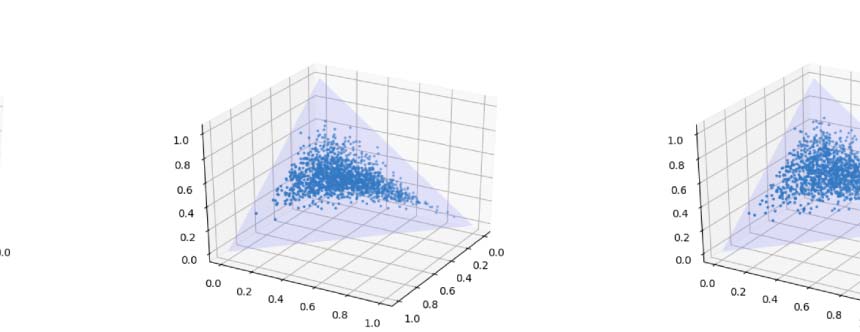

Figura 4: TSNE Visualizzazione dei vettori di categoria del BiLSTM personalizzato (prima riga) e personalizzato su base

BiLS™ (fila centrale), e i coefficienti γ di quest'ultimo modello (ultima riga), quando l'epoca è uguale a 1, 2, 4, E

quando l'allenamento è terminato (da sinistra a destra).

Esaminiamo infine le prestazioni del ns

modelli quando i dati contengono entità con avvio a freddo (cioè.,

gli utenti/prodotti possono avere zero o pochissime recensioni)

utilizzando Sparse80, sottoinsieme di Yelp 2013 dati

set fornito in Amplayo et al. (2018un). Noi veniamo-

confronta i nostri modelli con tre modelli concorrenti:

NSC (Chen et al., 2016), che utilizza una gerarchia-

Encoder cal LSTM abbinato alla personalizzazione

sul meccanismo dell'attenzione, BiLSTM+CSAA

(Amplayo et al., 2018un), che utilizza un BiLSTM

encoder con personalizzazione su mecha CSAA-

nismo, e HCSC (Amplayo et al., 2018un), che è

211

l

D

o

w

n

o

un

D

e

D

F

r

o

M

H

T

T

p

:

/

/

D

io

r

e

C

T

.

M

io

T

.

e

D

tu

/

T

un

C

l

/

l

un

r

T

io

C

e

–

p

D

F

/

D

o

io

/

.

1

0

1

1

6

2

/

T

l

un

C

_

un

_

0

0

2

6

3

1

9

2

3

0

4

7

/

/

T

l

un

C

_

un

_

0

0

2

6

3

p

D

.

F

B

sì

G

tu

e

s

T

T

o

n

0

7

S

e

p

e

M

B

e

r

2

0

2

3

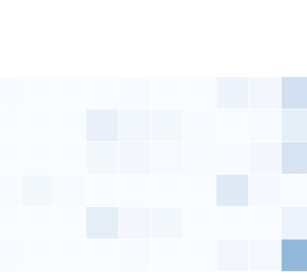

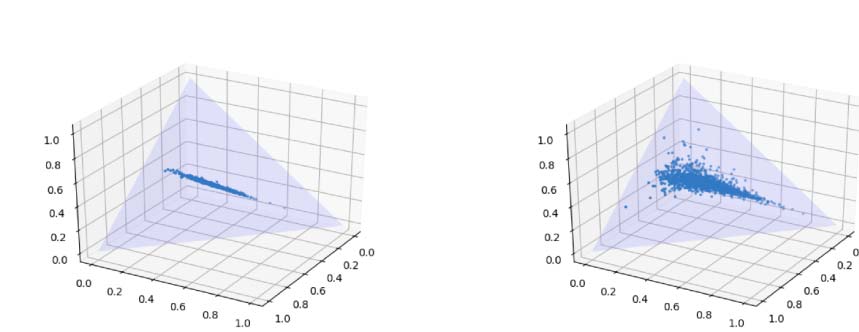

Figura 5: Precisione per frequenza di revisione dell'utente/prodotto su Yelp 2013 insieme di dati. Il valore della frequenza di revisione f

rappresenta le frequenze nella gamma [F, F + 10), tranne quando f = 100, dove rappresenta le frequenze in

la gamma [F, inf).

Modelli

NSC

BiLSTM+CSAA

HCSC

BiLSTM+encoder-basis-cust

BiLSTM+base-lineare-cust

BiLSTM+bias-basis-cust

BiLSTM+word-basis-cust

BiLSTM+attenzione-base-custodia

Precisione

51.1

52.7

53.8

50.4

50.8

51.9

51.9

53.1

Tavolo 6: Confronto delle prestazioni dei modelli concorrenti

nello Yelp 2013 Set di dati Sparse80.

una combinazione di CNN e codificatore BiLSTM

con personalizzazione su CSAA.

I risultati sono riportati nella Tabella 6, che forniscono

facciamo due osservazioni. Primo, il modello BiLS™

personalizzato sulla matrice di trasformazione lineare,

che offre le migliori prestazioni sull'originale Yelp 2013

insieme di dati (Vedi la tabella 3), ottiene una diminuzione molto marcata

nelle prestazioni. Supponiamo che ciò sia dovuto al motivo

la personalizzazione non è in grado di gestire il freddo zero-shot-

entità iniziali, che sono amplificati in Yelp 2013

Set di dati Sparse80. Lasciamo le estensioni di base per

zero-shot o avviamento a freddo, studiato attivamente in macchina

apprendimento (Wang et al., 2019) e raccomandazione

domini (Sole et al., 2012), rispettivamente. Ispirato

a cura della CSAA (Amplayo et al., 2018un), utilizzando simili

rivedere i testi per dedurre l'utente con avvio a freddo (O

Prodotto), ci aspettiamo di dedurre il metacontesto, allo stesso modo

basato su un metacontesto simile, che potrebbe mitigare

il problema dell'avviamento a freddo zero-shot. Secondo, nonostante

non avendo capacità di apprendimento zero-shot, Base-

BiLSTM personalizzato sul meccanismo di attenzione

si esibisce in modo competitivo con HCSC e si esibisce

meglio di BiLSTM+CSAA, che è personalizzato-

BiLSTM ottimizzato sul meccanismo di attenzione con il freddo-

iniziare la consapevolezza.

6 Conclusione

Abbiamo presentato un nuovo studio sul testo personalizzato

classificazione, un compito che ci viene assegnato, a parte

dal testo, i suoi metadati categorici informano-

zione, prevedere l’etichetta del testo, personalizzato da

le categorie disponibili. Il problema in questione è questo

queste informazioni sui metadati categorici sono difficilmente

comprensibile e quindi difficile da usare da parte del sistema neurale

macchine. Questo,

Perciò, rende basato sul neurale

modelli difficili da addestrare e ottimizzare per trovare un corretto

rappresentazione categorica dei metadati. Questo problema è

molto critico, in modo tale che un semplice concate-

nazione di queste informazioni categoriche fornisce

prestazioni migliori rispetto ai popolari neurali esistenti-

metodi basati. Proponiamo di risolvere questo problema

utilizzando i vettori di base per personalizzare parti di una classe-

modello di sificazione come il meccanismo dell’attenzione

e le matrici dei pesi negli strati nascosti. Nostro

i risultati mostrano che personalizzare i pesi utilizzando

i vettori della base aumentano le prestazioni di una base

Modello BiLS™, e anche effettivamente sovraperforma

i metodi di concatenazione semplici ma robusti. Noi

condividere il codice e i set di dati utilizzati nella nostra esperienza-

menzioni qui: https://github.com/zizi1532/

BasePersonalizza.

Ringraziamenti

Questo lavoro è stato supportato da Microsoft Research

Borsa di ricerca Asia e IITP/MSIT (NO. 2017-0-

01779).

212

Riferimenti

Reinald Kim Amplayo, Jihyeok Kim, Sua Sung,

e Seung-won Hwang. 2018un. Partenza a freddo

utente consapevole e attenzione al prodotto per il sentiment

classificazione. Negli Atti della 56a An-

Riunione annuale dell'Associazione per Compu-

linguistica nazionale (Volume 1: Documenti lunghi),

pagine 2535–2544. Associazione per il calcolo-

linguistica nazionale.

Reinald Kim Amplayo, Kyungjae Lee, Jinyoung

Sì, e Seung-won Hwang. 2018B. Trans-

lazioni come contesti aggiuntivi per le classi di frasi-

sificazione. Negli Atti del ventisettesimo

Conferenza congiunta internazionale sull'artificiale

Intelligenza, IJCAI 2018, pagine 3955–3961.

Dzmitry Bahdanau, Kyunghyun Cho, e Yoshua

Bengio. 2015. Traduzione automatica neurale di

imparare insieme ad allineare e tradurre. Nel professionista-

Atti della 3a Conferenza Internazionale

sulle rappresentazioni dell'apprendimento, ICLR'15.

Andrea Baruzzo, Antonina Dattolo, Nirmala

Gocciolare, e Carlo Tasso. 2009. Un generale

quadro per la classificazione personalizzata del testo

e annotazione. Negli Atti del Convegno

sull'adattamento e la personalizzazione per il Web 2.0,

AP WEB 2.0@UMAP.

Huimin Chen, Maosong Sun, Cunchao tu, Yankai

Lin, e Zhiyuan Liu. 2016. Sentimento neurale

classificazione con utente e prodotto attenti-

zione. Negli Atti del 2016 Conferenza

sui metodi empirici nel linguaggio naturale

in lavorazione, pagine 1650–1659. Associazione per

Linguistica computazionale.

Po-Hao Chou, Richard Tzong-Han Tsai, e Jane

Yung-jen Hsu. 2017. Sentiment consapevole del contesto

propagazione utilizzando la modellazione degli argomenti LDA su

conceptnet cinese. Informatica morbida, 21(11):

2911–2921.

Zi-Yi Dou. 2017. Catturare utente e prodotto

informazioni per l'analisi del sentiment a livello di documento-

ysis con rete di memoria profonda. In Procedi-

IL 2017 Conferenza sull'Empirico

ings di

Metodi nell'elaborazione del linguaggio naturale,

pagine 521–526. Associazione per il calcolo

Linguistica.

Alec Vai, Richa Bhayani, e Lei Huang. 2009.

Classificazione del sentiment di Twitter utilizzando distante

supervisione. Rapporto sul progetto CS224N, Stanford,

1(12).

Sepp Hochreiter e Jürgen Schmidhuber. 1997.

Memoria a lungo termine. Calcolo neurale,

9(8):1735–1780.

Arash Joorabchi e Abdulhussain E. Mahdi.

2011. Un approccio non supervisionato all’automatico

classificazione della letteratura scientifica utilizzando

metadati bibliografici. Giornale dell'informazione

Scienza, 37(5):499–514.

Yoon Kim. 2014. Reti neurali convoluzionali

per la classificazione delle frasi. Negli Atti di

IL 2014 Conferenza sui metodi empirici

nell'elaborazione del linguaggio naturale (EMNLP),

pagine 1746–1751. Associazione per il calcolo-

linguistica nazionale.

Xuan Nhat Lam, Thuc Vu, A Duc Le,

e Anh Duc Duong. 2008. Affrontare il freddo-

problema di inizio nei sistemi di raccomandazione.

Negli Atti di

la 2a Internazionale

Conferenza sull'uomo ubiquo dell'informazione-

gestione e comunicazione, ICUIMC 2008,

pagine 208–211.

Fei-Fei Li, Roberto Fergus, and Pietro Perona.

2006. Apprendimento one-shot delle categorie di oggetti.

Transazioni IEEE sull'analisi dei modelli e

Intelligenza artificiale, 28(4):594–611.

Xin Li e Dan Roth. 2002. Domanda di apprendimento

In COLING 2002: Il 19

classificatori.

Conferenza internazionale sul calcolo

Linguistica.

Rui Lin, Shujie Liu, Muyun Yang, Mu Li,

MingZhou, e Sheng Li. 2015. Gerarchico

rete neurale ricorrente per il modello di documento-

ing. Negli Atti del 2015 Conferenza

sui metodi empirici nel linguaggio naturale

in lavorazione, pagine 899–907. Associazione per

Linguistica computazionale.

Yunfei lungo, Mingyu Ma, Qin Lu, Rong

Xiang, e Chu-Ren Huang. 2018. Doppia memoria-

modello di rete ory per la revisione parziale del prodotto

classificazione. Negli Atti della IX Opera-

acquista sugli approcci computazionali all'argomento-

attività, Sentiment e analisi dei social media,

pagine 140–148. Associazione per il calcolo

Linguistica.

213

l

D

o

w

n

o

un

D

e

D

F

r

o

M

H

T

T

p

:

/

/

D

io

r

e

C

T

.

M

io

T

.

e

D

tu

/

T

un

C

l

/

l

un

r

T

io

C

e

–

p

D

F

/

D

o

io

/

.

1

0

1

1

6

2

/

T

l

un

C

_

un

_

0

0

2

6

3

1

9

2

3

0

4

7

/

/

T

l

un

C

_

un

_

0

0

2

6

3

p

D

.

F

B

sì

G

tu

e

s

T

T

o

n

0

7

S

e

p

e

M

B

e

r

2

0

2

3

approcci

Thang Luong, Ciao Pham, e Christopher D.

A

Equipaggio. 2015. Efficace

traduzione automatica neurale basata sull’attenzione. In

Atti del 2015 Conferenza sull'Em-

Metodi pirici in Natural Language Pro-

cessazione, pagine 1412–1421. Associazione per

Linguistica computazionale.

Dehong Ma, Sujian Li, Xiaodong Zhang,

Houfeng Wang, e Xu Sun. 2017. Cas-

cadendo attenzioni multidirezionali a livello di documento

classificazione del sentimento. Negli Atti del

Ottava conferenza congiunta internazionale sul Nat-

elaborazione del linguaggio urale (Volume 1: Lungo

Carte), pagine 634–643. Federazione asiatica di

Elaborazione del linguaggio naturale.

Tomás Mikolov, Kai Chen, Greg Corrado, E

Jeffrey Dean. 2013. Stima efficiente di

rappresentazioni di parole nello spazio vettoriale. CoRR,

abs/1301.3781.

Bo

E

Pang, Lillian Lee,

Shivakumar

Vaithyanathan. 2002. Pollice su? sentimento

classificazione utilizzando la tecnologia di apprendimento automatico-

Carino. Negli Atti del 2002 Conferenza

sui metodi empirici nel linguaggio naturale

in lavorazione (EMNLP 2002).

Zizi Papacharissi. 2002. La presentazione di sé

nella vita virtuale: Caratteristiche della casa personale

pagine. Giornalismo & Comunicazione di massa

Trimestrale, 79(3):643–660.

Jeffrey

Socher,

Pennington, Richard

E

Cristoforo Manning. 2014. Guanto: Globale

vettori per la rappresentazione delle parole. Negli Atti

del 2014 Conferenza sui metodi empirici

nell'elaborazione del linguaggio naturale (EMNLP),

pagine 1532–1543. Associazione per il calcolo-

linguistica nazionale.

Matteo Peters, Marco Neumann, Mohit Iyyer,

Matt Gardner, Cristoforo Clark, Kenton Lee,

e Luke Zettlemoyer. 2018. Contesto profondo-

rappresentazioni di parole personalizzate. Negli Atti

del 2018 Conferenza del Nord America

Capitolo dell'Associazione per il calcolo

Linguistica: Tecnologie del linguaggio umano,

Volume 1 (Documenti lunghi), pagine 2227–2237.

Associazione per la Linguistica Computazionale.

Atti del 4° Convegno Internazionale-

ence sulle rappresentazioni dell’apprendimento, ICLR'16.

Michal Rosen-Zvi, Tommaso L. Griffith, Segno

Steyvers, e Padhraic Smyth. 2004. IL

modello autore-argomento per autori e documenti.

Nell'UAI '04, Atti del 20° Convegno-

ence in Incertezza in Intelligenza Artificiale,

pagine 487–494.

Fabrizio Sebastiani. 2002. Apprendimento automatico dentro

categorizzazione automatizzata del testo. Calcolo ACM

Sondaggi, 34(1):1–47.

Riccardo Socher, Jeffrey Pennington, Eric H.

Huang, Andrea Y. Di, e Christopher D.

Equipaggio. 2011. Ricorsivo semi-supervisionato

codificatori automatici per prevedere la distribuzione del sentiment-

butions. Negli Atti del 2011 Conferenza

sui metodi empirici nel linguaggio naturale

in lavorazione, pagine 151–161. Associazione per

Linguistica computazionale.

Dong-ting Sun, Tao He, e Fu-hai Zhang. 2012.

Indagine sul problema dell'avvio a freddo in collaborazione

sistema di raccomandazione di filtraggio. Calcolatore e

Modernizzazione, 5:59–63.

Duyu Tang, BingQin, e Ting Liu. 2015.

Apprendimento delle rappresentazioni semantiche degli utenti e

prodotti per classi di sentiment a livello di documento-

ficazione. Negli Atti della 53a edizione

Riunione dell'Associazione per il Computazionale

Linguistica e 7° Giunto Internazionale

Conferenza sull'elaborazione del linguaggio naturale

(Volume 1: Documenti lunghi), pagine 1014–1023.

Associazione per la Linguistica Computazionale.

Wei Wang, Vincent W. Zheng, Han Yu, E

Chunyan Miao. 2019. Un'indagine sullo scatto zero

apprendimento: Impostazioni, metodi, e applicazioni.

Transazioni ACM su sistemi intelligenti e

Tecnologia, 10(2):13:1–13:37.

Pengcheng Yang, Xu SOLE, Wei Li, e Shuming

Mamma. 2018. Valutazione automatica dei documenti accademici

basato su convoluzioni gerarchiche modularizzate-

rete neurale nazionale. Negli Atti del

56esima Assemblea Annuale dell'Associazione per

Linguistica computazionale (Volume 2: Corto

Carte), pagine 496–502. Associazione per

Linguistica computazionale.

Sachin Ravi e Hugo Larochelle. 2016. Il migliore-

zzazione come modello per l’apprendimento a poche riprese. In

Zichao Yang, Diyi Yang, Chris Dyer, Xiaodong

Lui, Alex Smola, e Edward Blu. 2016.

214

l

D

o

w

n

o

un

D

e

D

F

r

o

M

H

T

T

p

:

/

/

D

io

r

e

C

T

.

M

io

T

.

e

D

tu

/

T

un

C

l

/

l

un

r

T

io

C

e

–

p

D

F

/

D

o

io

/

.

1

0

1

1

6

2

/

T

l

un

C

_

un

_

0

0

2

6

3

1

9

2

3

0

4

7

/

/

T

l

un

C

_

un

_

0

0

2

6

3

p

D

.

F

B

sì

G

tu

e

s

T

T

o

n

0

7

S

e

p

e

M

B

e

r

2

0

2

3

Reti di attenzione gerarchica per il documento

classificazione. Negli Atti del 2016 Contro-

ferenza del capitolo nordamericano della

Associazione per la Linguistica Computazionale: Eh-

uomo Tecnologie del linguaggio, pagine 1480–1489.

Associazione per la Linguistica Computazionale.

Matteo D. Marinaio. 2012. ADADEL: Un adattamento-

metodo del tasso di apprendimento tivo. CoRR, abs/1212.5701.

Peng Zhou, Zhenyu Qi, Suncong Zheng, Jiming

Xu, Hongyun Bao, e BoXu. 2016. Testo

classificazione migliorata integrando bidi-

LSTM rezionale con max. bidimensionale

messa in comune. Negli Atti di COLING 2016,

la 26a Conferenza Internazionale sul Com-

Linguistica putazionale: Documenti tecnici,

pagine 3485–3495.

Rui Zhao, Kezhi Mao, Rui Zhao, e Kezhi

Mao. 2017. Composizione profonda e consapevole dell'argomento

modelli per la classificazione delle frasi. IEEE/ACM

Transazioni su audio, Discorso e linguaggio

in lavorazione, 25(2):248–260.

Pengcheng Zhu e Yujiu Yang. 2017. Parallelo

attenzione multifunzionale al sentiment neurale

classificazione. Negli Atti di

l'ottavo

Simposio internazionale sull'informazione e

Tecnologia della comunicazione, pagine 181–188.

l

D

o

w

n

o

un

D

e

D

F

r

o

M

H

T

T

p

:

/

/

D

io

r

e

C

T

.

M

io

T

.

e

D

tu

/

T

un

C

l

/

l

un

r

T

io

C

e

–

p

D

F

/

D

o

io

/

.

1

0

1

1

6

2

/

T

l

un

C

_

un

_

0

0

2

6

3

1

9

2

3

0

4

7

/

/

T

l

un

C

_

un

_

0

0

2

6

3

p

D

.

F

B

sì

G

tu

e

s

T

T

o

n

0

7

S

e

p

e

M

B

e

r

2

0

2

3

215