Generalización compositiva en multilingüe

Análisis semántico sobre Wikidata

Ruixiang Cui, Rahul Aralikate, Brezo Cuaresma, y Daniel Hershcovich

Departamento de Ciencias de la Computación

Universidad de Copenhague, Dinamarca

{RC, raul, clorhidrato, DH}@di.ku.dk

Abstracto

análisis semántico (SP) permite a los humanos hacer palanca-

envejecer vastos recursos de conocimiento a través de la naturaleza

interacción. Sin embargo, los analizadores son en su mayoría de-

firmado y evaluado en recursos en inglés,

como CFQ (Keysers et al., 2020), el perro-

alquiler de referencia estándar basado en inglés

datos generados a partir de reglas gramaticales y ori-

dirigido hacia Freebase, un conocimiento obsoleto-

base de borde. Proponemos un método para crear un

plurilingüe, conjunto de datos paralelo de pregunta-consulta

pares, basado en Wikidata. Les presentamos

tal conjunto de datos, que llamamos multilingüe

Preguntas sobre composición de Wikidata (MCWQ),

y usarlo para analizar el gen composicional-

Eralización de analizadores semánticos en hebreo.,

canarés, Chino, e inglés. mientras dentro-

La generalización del lenguaje es comparable entre

idiomas, experimentos en cruz de tiro cero-

La transferencia lingüística demuestra que el intercambio lingüístico

la generalización compositiva falla, incluso con

codificación multilingüe previamente entrenada de última generación-

ers. Además, nuestra metodología, conjunto de datos,

y los resultados facilitarán futuras investigaciones sobre

SP en entornos más realistas y diversos que

ha sido posible con los recursos existentes.

1

Introducción

Analizadores semánticos basados en bases de conocimiento

(KB) habilitar la respuesta a la pregunta de la base de conocimientos-

En g (KBQA) para preguntas complejas. muchos cemento-

Los analizadores de tic se basan en KB como Freebase

(Bollacker et al., 2008), DBpedia (Lehmann et al.,

2015), y Wikidata (Pellissier Tanon et al.,

2016), y los modelos pueden aprender a responder preguntas

sobre entidades y propiedades invisibles (Abundante y

tarde, 2017; Cheng y Lapata, 2018, Shen et al.,

2019; Sas et al., 2020). Una habilidad importante y deseada-

La calidad es la generalización compositiva: la capacidad.

Generalizar a combinaciones invisibles de elementos conocidos.

componentes (Oren et al., 2020; Kim y Lenzen,

2020).

937

Uno de los conjuntos de datos más utilizados para mea-

Asegurar la generalización compositiva en KBQA es

CFQ (Preguntas de base libre composicional; Keyser

et al., 2020), que fue generado usando gramática

normas, y está basado en Freebase, un anticuado y

KB sin mantenimiento solo en inglés. Si bien la necesidad de

expandir la tecnología lingüística a muchos idiomas

es ampliamente reconocido (Joshi et al., 2020), el

falta de un punto de referencia para la generalización compositiva-

ción en el análisis semántico multilingüe (SP) obstaculiza

KBQA en otros idiomas además del inglés. Más-

más, El progreso tanto en SP como en KB requiere

que los puntos de referencia se puedan reutilizar y adaptar para

métodos futuros.

Wikidata es una base de conocimientos multilingüe, con entidad y

etiquetas de propiedades en multitud de idiomas. Él

ha crecido continuamente a lo largo de los años y es un

complemento importante a Wikipedia. Mucho esfuerzo

Se ha realizado para migrar datos de Freebase a Wiki.-

datos (Pellissier Tanon et al., 2016; Diefenbach

et al., 2017; Hogan et al., 2021), pero solo en inglés-

inglés. Investigando la generalización compositiva

en SP multilingüe se requieren datos multilingües-

colocar, una brecha que abordamos en este trabajo.

Aprovechamos Wikidata y CFQ para crear

Preguntas de Wikidata sobre composición multilingüe

(MCWQ), un nuevo conjunto de datos multilingüe de compo-

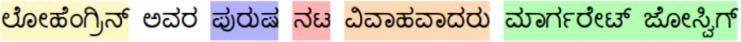

preguntas posicionales basadas en Wikidata (ver figura-

ura 1 para un ejemplo). Más allá del inglés original,

una lengua indoeuropea que utiliza la escritura latina,

Creamos conjuntos de datos paralelos de preguntas en He.-

elaborar cerveza, canarés, y chino, que usan diferentes

escrituras y pertenecen a diferentes familias lingüísticas:

afroasiático, dravidiano, y chino-tibetano, respetar-

activamente. Nuestro conjunto de datos incluye preguntas en los cuatro

Idiomas y sus consultas SPARQL asociadas..

Nuestras contribuciones son:

• un método para migrar automáticamente un KBQA

conjunto de datos a otra KB y extenderlo a diversos

idiomas y dominios,

Transacciones de la Asociación de Lingüística Computacional, volumen. 10, páginas. 937–955, 2022. https://doi.org/10.1162/tacl a 00499

Editor de acciones: Emily Pitler. Lote de envío: 4/2022; Lote de revisión: 6/2022; Publicado 9/2022.

C(cid:2) 2022 Asociación de Lingüística Computacional. Distribuido bajo CC-BY 4.0 licencia.

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

mi

d

tu

/

t

a

C

yo

/

yo

a

r

t

i

C

mi

–

pag

d

F

/

d

oh

i

/

.

1

0

1

1

6

2

/

t

yo

a

C

_

a

_

0

0

4

9

9

2

0

4

2

5

8

8

/

/

t

yo

a

C

_

a

_

0

0

4

9

9

pag

d

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

7

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

Los analizadores entrenados en CFQ transforman estas preguntas-

ciones en consultas SPARQL, que puede subseguir-

frecuentemente se ejecutará contra Freebase para responder

las preguntas originales (en este caso, ''Sí'').

el conjunto de prueba

CFQ utiliza la composición basada en distribución.-

Evaluación de nacionalidad (DBCA) método para generar

múltiples divisiones de prueba de tren con máxima divergencia

ejemplos en términos de compuestos, mientras principal-

manteniendo una baja divergencia en términos de primitivos

elementos (átomos). En estos compuestos máximos

divergencia (MCD) se divide,

es una estafa-

filtrado a ejemplos que contienen nuevos compuestos,

eso es, Nuevas formas de componer los átomos vistas.

durante el entrenamiento. Para medir gen composicional-

eralizaciones, las entidades nombradas en las preguntas son

anonimizados para que los modelos no puedan simplemente aprender el

relación entre entidades y propiedades. CFQ

contiene 239,357 pares de preguntas y respuestas en inglés,

que abarcan 49,320 patrones de preguntas y

34,921 Patrones de consulta SPARQL. Mesa 1 muestra

campos seleccionados de un ejemplo en CFQ. en su ex-

perimentos, Keysers y otros. (2020) hombre entrenado-

analizadores de tic que utilizan varias arquitecturas en varios

divisiones de prueba de tren. Demostraron una fuerte nega-

correlación positiva entre la precisión de los modelos (cor-

Rectitud de la consulta SPARQL generada completa.) y

divergencia compuesta a través de una variedad de sistemas

arquitecturas: todos los modelos se generalizaron mal en

los ajustes de alta divergencia, destacando la necesidad

para mejorar la generalización compositiva en SP.

Cuando se lanzó CFQ, base libre

ya había sido cerrado. En esa cuenta, a

nuestro conocimiento,

no hay datos de SP existentes-

establecer como objetivo la generalización compositiva que es

basado en un KB actualmente utilizable, cual estafa-

mantiene información actualizada. Por lo tanto, mi-

rallar el conjunto de datos a tal KB, a saber, Wikidatos,

en 3.

Además, sólo unos pocos estudios han evaluado

Rendimiento de los analizadores semánticos en un entorno multilingüe.

configuración, debido a la escasez de KBQA multilingüe

conjuntos de datos (Perevalov et al., 2022b). No compara-

Existe un punto de referencia para otros idiomas además de

Inglés, y por lo tanto no está claro si

Los resultados son generalizables a otros idiomas.. Com-

generalización posicional en tipológicamente distante

Los idiomas pueden plantear desafíos completamente diferentes.-

lentes, ya que estos idiomas pueden tener diferentes

formas de componer significado (Evans y Levinson,

2009). Creamos un conjunto de datos multilingüe de este tipo en

§4, aprovechando el multilingüismo de Wikidata.

Cifra 1: Un ejemplo del conjunto de datos MCWQ. El

La pregunta en cada idioma corresponde a la misma.

Consulta SPARQL de Wikidata, cual, tras la ejecución,

devuelve la respuesta (lo cual es positivo en este caso).

• un punto de referencia para medir la composición

generalización en SP para KBQA sobre Wiki-

datos en cuatro idiomas tipológicamente diversos,

• experimentos monolingües con diferentes SP

arquitecturas en cada uno de los cuatro idiomas,

demostrando genes similares dentro del lenguaje-

eralización, y

• experimentos multilingüísticos de disparo cero utilizando

codificadores multilingües previamente entrenados,

espectáculo-

extrayendo esa generalización compositiva de

El inglés a los otros idiomas falla..

Nuestro código para generar el conjunto de datos y para

los experimentos, así como el conjunto de datos en sí y

modelos entrenados, están disponibles públicamente en https://

github.com/coastalcph/seq2sparql.

2 Limitaciones del CFQ

CFQ (Keysers et al., 2020) es un conjunto de datos para mea-

asegurar la generalización compositiva en SP. es alquitrán-

recibe la tarea de analizar preguntas en inglés en

Consultas SPARQL ejecutables en Freebase KB

(Bollacker et al., 2008). CFQ contiene preguntas

como en la tabla 1, así como el siguiente inglés

pregunta (con entidades entre corchetes):

''Era [Artistas Unidos]

fundado por

[Señor. Arreglalo]la estrella, fundado por [D. W..

Griffith], fundado por [María Pickford],

y fundado por [El huésped estelar]'s

estrella?''

938

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

mi

d

tu

/

t

a

C

yo

/

yo

a

r

t

i

C

mi

–

pag

d

F

/

d

oh

i

/

.

1

0

1

1

6

2

/

t

yo

a

C

_

a

_

0

0

4

9

9

2

0

4

2

5

8

8

/

/

t

yo

a

C

_

a

_

0

0

4

9

9

pag

d

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

7

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

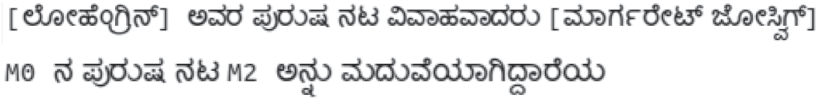

campo CFQ

preguntaConCorchetes

preguntaPatternModEntities

preguntaConMids

chispa

sparqlPatternModEntidades

Contenido

Hizo ['Asesinato' Legendre]El actor masculino se casa. [Lillian Lugosi]

¿Se casó el actor masculino de M0 con M2?

¿m.0El actor masculino de h4y854 se casa con m..0hpnx3b

SELECCIONAR recuento(*) DÓNDE { ?x0 ns:actor de cine.film/ns:película.actuación

.personaje

ns:metro.0h4y854 . ?x0 ns:personas.persona.género ns:metro.05zppz . ?x0

ns:personas.persona.cónyuge s/ns:universo ficticio.matrimonio de

personajes de ficción. cónyuges ns:metro.0hpnx3b . FILTRAR ( ?x0 !=

ns:metro.0hpnx3b )}

SELECCIONAR recuento(*) DÓNDE { ?x0 ns:actor de cine.film/ns:película.actuación

.personaje

M0 . ?x0 ns:personas.persona.género ns:metro.05zppz . ?x0

ns:personas.persona.cónyuge s

/ns:universo ficticio.matrimonio de personajes ficticios.cónyuges M2

. FILTRAR

( ?x0 !=M2 )}

Mesa 1: Campos seleccionados en una entrada de CFQ. questionWithBrackets es la pregunta completa en inglés.

con entidades entre corchetes. questionPatternModEntities es la pregunta con entidades

reemplazado por marcadores de posición. En cuestiónConMids, los códigos de entidad (ID de máquinas de base libre; MID)

se dan en lugar de sus etiquetas. sparql es la consulta SPARQL totalmente ejecutable para la pregunta, y

en sparqlPatternModEntities los códigos de entidad se reemplazan por marcadores de posición.

3 Migración a Wikidata

Wikidata es ampliamente aceptado como reemplazo

para base libre. Se mantiene y repre activamente-

envía conocimientos en multitud de idiomas y

dominios, y también es compatible con SPARQL. Migrar

Consultas de base libre a Wikidata, sin embargo, no es trivial-

ial, ya que no existe un mapeo completo establecido entre

Las propiedades y entidades de las KB.. Un cambio obvio-

nativo de la migración sería una réplica de la

Proceso de generación de CFQ original pero con Wiki.-

datos como KB. Antes de profundizar en los detalles de

el proceso migratorio, Motivemos la decisión.-

sión de no seguir esa opción: La gramática utilizada

para generar CFQ no se puso a disposición de otros-

ers por Keysers et al.. (2020) y es prohibitivamente

demasiado complejo para aplicar ingeniería inversa. Nuestra migración

proceso, por otro lado, es general y puede simular-

Se puede aplicar de manera similar para migrar otros conjuntos de datos desde

Base libre a Wikidata. Finalmente, muchos competitivos

Se han desarrollado modelos con arquitectura especializada.

desarrollado para CFQ (Guo et al., 2020; Sentido

et al., 2021; Gay y col., 2021. Nuestros datos migrados-

El conjunto es formalmente similar y facilita su evaluación.-

uación y desarrollo de nuevos métodos..

3.1 Mapeo de propiedades

usos 51 propiedades únicas en sus consultas SPARQL,

principalmente pertenecientes al dominio cinematográfico.

Estas propiedades de Freebase no se pueden aplicar di-

directamente a Wikidata, que utiliza diferentes propiedades

códigos conocidos como códigos P (p.ej., P21). nosotros allí-

Por lo tanto, es necesario asignar las propiedades de Freebase a

Propiedades de Wikidata.

Como primer paso en el proceso migratorio, nosotros

compruebe qué propiedades de Freebase se utilizan en CFQ

tener las propiedades Wikidata correspondientes. Usando un

repositorio disponible públicamente que proporciona una información parcial

mapeo entre las KB,1 identificamos eso 22

fuera de 51 Las propiedades de base libre en CFQ pueden

ser asignado directamente a las propiedades de Wikidata.2

otro 29 requieren procesamiento adicional:

Catorce propiedades son lo contrario de otras.

propiedades, que no tienen contador Wikidata-

partes. Por ejemplo, ns:cine.director.pelicula

es el reverso de ns:película.película.dirigida por,

y sólo este último tiene mapeo Wikidata, P57.

Resolvemos el problema intercambiando las entidades.

alrededor de la propiedad.

El otro 15 las propiedades se ocupan de juzgar

si una entidad tiene una determinada cualidad. En CFQ,

?x1 y ns:El director de cine pregunta si ?x1

es un director. Wikidata no contiene tales

propiedades unarias. Por lo tanto, Necesitamos tratar estos

Como se puede observar en la tabla 1, la cláusula WHERE en un

La consulta SPARQL consta de una lista de triples., dónde

el segundo elemento en cada triplete es la propiedad

(p.ej., ns:personas.persona.genero). CFQ

1https://www.wikidata.org/wiki/Wikidata

:WikiProject Base libre/Mapeo.

2Si bien algunas propiedades de Freebase tienen múltiples cor-

propiedades de Wikidata que responden, consideramos una propiedad

mapeable siempre que tenga al menos un mapeo.

939

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

mi

d

tu

/

t

a

C

yo

/

yo

a

r

t

i

C

mi

–

pag

d

F

/

d

oh

i

/

.

1

0

1

1

6

2

/

t

yo

a

C

_

a

_

0

0

4

9

9

2

0

4

2

5

8

8

/

/

t

yo

a

C

_

a

_

0

0

4

9

9

pag

d

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

7

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

Propiedades CFQ como entidades en Wikidata. por ejemplo-

amplio, el director es wd:Q2526255, entonces nosotros para-

formular la consulta como ?x1 ancho:P106 WD:

Q2526255, preguntando si ?ocupación de x1

(P106) es director. Además, sustituimos el

director de arte propiedad de CFQ con la com-

propiedad poser porque el primero no tiene equivalente-

alente en Wikidata. Finalmente, filtramos consultas

con marcas inversas sobre las propiedades, Por ejemplo,

?x0 ns:personas.persona.género M0, pendiente

a la incompatibilidad con la generación de preguntas

proceso (§3.2).

Después de filtrar, nos quedamos con 236,304 entradas

con solo propiedades totalmente mapeables: 98,7% de todos

entradas en CFQ. Además hacemos necesario

Modificación de sintaxis SPARQL para Wikidata.3

3.2 Sustitución de entidad

Una gran cantidad de entidades en Freebase están ausentes

en Wikidata. Por ejemplo, ninguna de las entidades

en mesa 1 existir en Wikidata. Además, a diferencia de

el caso de las propiedades, a nuestro conocimiento, allá

No existe un mapeo completo o incluso parcial de

ID de entidad de base libre (es decir., ID de máquinas de base libre,

MID, como por ejemplo:metro.05zppz) a Wikidata es-

ID de entidad (es decir., códigos Q, como por ejemplo:Q6581097).

Replicamos el proceso de puesta a tierra realizado

por Keysers et al.. (2020), lugar de la entidad sustituta-

titulares con códigos de entidades compatibles por ejecución-

ing las consultas contra Wikidata:

1. Reemplazo de marcadores de entidad con SPARQL

variables (p.ej., ?v0), obtenemos consultas que

devolver conjuntos de entidades candidatas compatibles

tareas en lugar de simplemente una respuesta para

una asignación dada de entidades.

2. Agregamos restricciones para que las entidades sean

distinto, para evitar redundancias sin sentido

(p.ej., debido a la conjunción de cláusulas idénticas).

3. Entidades especiales, representando nacionalidades

y géneros, son considerados parte de la

patrones de preguntas en CFQ (y no son re-

colocado con marcadores de posición). Antes de correr

las consultas, por lo tanto reemplazamos todas esas entidades

con los correspondientes códigos Q de Wikidata (en-

en lugar de variables).

4. Ejecutamos las consultas contra el Wikidata

consultar service4 para obtener la asignación satisfactoria-

mentos de combinaciones de entidades, con la cual

reemplazamos los marcadores de posición en sparql-

Campos PatternModEntities.

5. Finalmente, insertamos

los códigos Q en el

Preguntas en inglés en la preguntaCon-

Campo de medios y la entidad correspondiente.-

bels en la pregunta con corchetes para

obtener las preguntas en inglés para nuestro conjunto de datos.

A lo largo de este proceso, 52.5% de las consultas tienen

al menos una tarea satisfactoria. La resultante

Los pares de preguntas y consultas constituyen nuestros datos en inglés.-

colocar. Mantienen los patrones SPARQL en CFQ,

pero todas las consultas son ejecutables en Wikidata.

Obtenemos 124,187 pares pregunta-consulta, de

cual 67,523 son preguntas de sí/no y 56,664

son quienes- preguntas. Las respuestas esperadas de

Las preguntas de sí/no en este conjunto son todas "sí" debido a

nuestro proceso de asignación de entidades. Para hacer MCWQ

comparable al CFQ, que tiene efectos positivos y

respuestas negativas, probamos consultas alternativas

reemplazando entidades con otras de otras consultas

cuyos predicados precedentes son los mismos. Nuestro

resultados de muestreo negativos en 30,418 preguntas con

''sin respuestas.

3.3 Ejemplo de migración

Considere el patrón SPARQL de la tabla 1:

SELECCIONAR recuento(*) DÓNDE { ?x0 ns:Actor de películas.

película/ns:película.actuación.personaje M0 .

?x0 ns:personas.persona.género ns:metro.05zppz .

?x0 ns:personas.persona.cónyuge s/ns:

universo ficticio.

matrimonio de personajes de ficción.cónyuges

M2 . FILTRAR ( ?x0 !=M2 )}

Reemplazamos las propiedades y enti especiales.-

corbatas (aqui el genero masculino: ns:metro.05zppz →

wd:Q6581097):

SELECCIONAR recuento(*) DÓNDE {?x0 wdt:P453 M0 .?x0

wdt:P21:Q6581097 .

FILTRAR ( ?x0 !=M2 )}

?x0 wdt:P26M2 .

Luego reemplazamos los marcadores de posición. (p.ej., M0) con variedad-

capacidades y agregar restricciones para obtener solo una

asignación (lo cual es suficiente para nuestros propósitos)

con entidades distintas. La consulta resultante es:

3CFQ utiliza el recuento SELECT(*) DONDE consultar

si no preguntas, pero esta sintaxis no es compatible con Wiki-

datos. Lo reemplazamos con PREGUNTAR DÓNDE, destinado a booleano

consultas.

SELECCIONAR ?v0 ?v1 DONDE ?x0 wdt:P453 ?v0. ?x0

wdt:P21:Q6581097.

?x0 wdt:P26

?v1.

4https://consulta.wikidata.org/.

940

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

mi

d

tu

/

t

a

C

yo

/

yo

a

r

t

i

C

mi

–

pag

d

F

/

d

oh

i

/

.

1

0

1

1

6

2

/

t

yo

a

C

_

a

_

0

0

4

9

9

2

0

4

2

5

8

8

/

/

t

yo

a

C

_

a

_

0

0

4

9

9

pag

d

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

7

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

FILTRAR ( ?x0 != ?v1 ). FILTRAR ( ?v0 !=

?v1 ) LÍMITE 1

Ejecutamos la consulta y obtenemos wd.:Q50807639

(Lohengrin) y wd:Q1560129 (Margarita

joswig) como respuestas satisfactorias para v0 y v1,

respectivamente. Tenga en cuenta que estos son diferentes de los

entidades en la pregunta original ('Asesinato' Legendre

y Lillian Lugosi)-en general, no hay guar-

apuesta a que las mismas entidades de CFQ serán

conservado en nuestro conjunto de datos. Luego volvemos a poner

estas respuestas en la consulta, y hacer necesidades-

sary modificación de sintaxis SPARQL para Wikidata.

La consulta final para esta entrada es:

PREGUNTE DONDE {?x0 wdt:P453 WD:Q50807639. ?x0 wdt:

P21:Q6581097

Q1560129 . FILTRAR ( ?x0 != wd:Q1560129 )}

?x0 wdt:P26:

.

En cuanto a la pregunta en inglés, mapeamos el Gratis-

entidades base en el campo questionWithMids

con las etiquetas de las entidades Wikidata obtenidas.

Por lo tanto, la cuestión inglesa resultante de esto

el proceso es:

Hizo [Lohengrin] El actor masculino se casa.

[Margarete Joswig]?

Cifra 2: Distribución de complejidad de la división MCD1.

de CFQ (arriba) y MCWQ (abajo).

3.4 Estadísticas de conjuntos de datos

Comparamos las estadísticas de MCWQ con CFQ

en mesa 3. MCWQ tiene 29,312 pregunta única

patrones (entidades mod, verbos, etc.), eso es, 23.6%

de preguntas cubren todos los patrones de preguntas, com-

comparado con 20.6% en CFQ. Además, MCWQ

tiene 86,353 patrones de consulta únicos (mod enti-

corbatas), Resultando en 69.5% de casos que cubren

todos los patrones SPARQL, 18% superior al CFQ. Nuestro

Por lo tanto, el conjunto de datos plantea un desafío mayor para las empresas.-

SP posicional, y exhibe menos redundancia en

términos de patrones de consulta duplicados. no vale la pena-

ing ese porcentaje de consulta menos único en MCWQ

que el CFQ resulta de la pérdida durante el intercambio

las entidades en §3.1.

Ser desafiante desde el punto de vista compositivo, Keyser

et al. (2020) generó las divisiones de MCD para tener

alta divergencia compuesta manteniendo

baja divergencia atómica. Como los átomos en MCWQ son

mapeado desde CFQ al salir de la composi-

estructura funcional intacta, derivamos divisiones de prueba de tren

de nuestro conjunto de datos al inducir las divisiones de prueba de tren de

CFQ sobre el subconjunto correspondiente de instancias en

nuestro conjunto de datos.

La complejidad de las preguntas en CFQ es media.-

asegurado por la profundidad de recursividad y refleja el número

de aplicaciones de reglas utilizadas para generar una pregunta-

ción, que abarca la gramática, conocimiento,

inferencia, y reglas de resolución. Mientras cada pregunta-

La complejidad de la operación en MCWQ es la misma que la

preguntas del CFQ correspondientes, algunos no pueden ser

migrado (ver §3.1 y §3.2). Para verificar la com-

La divergencia de la libra no se ve afectada., comparamos

la distribución de complejidad de la pregunta de los dos

conjuntos de datos en una de las tres divisiones compositivas

(MCD1) En figura 2. El entrenamiento, desarrollo,

y conjuntos de prueba de la división en CFQ y MCWQ

seguir una tendencia similar en general. la fluctuación

en la complejidad de las preguntas del MCWQ

Las divisiones reflejan la distribución completa del conjunto de datos; consulte

Cifra 3.

Derivado de sus entidades y propiedades., CFQ

Las preguntas se limitan al ámbito de las películas.. El

entidades en MCWQ, sin embargo, en principio puede venir

desde cualquier dominio, gracias a nuestra entidad flexible

método de reemplazo. Aunque las propiedades de MCWQ

siguen siendo un subconjunto de los utilizados en CFQ, ellos son

principalmente en el dominio de las películas. También observamos un

algunas preguntas de la literatura, política, e historia

en MCWQ.

941

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

mi

d

tu

/

t

a

C

yo

/

yo

a

r

t

i

C

mi

–

pag

d

F

/

d

oh

i

/

.

1

0

1

1

6

2

/

t

yo

a

C

_

a

_

0

0

4

9

9

2

0

4

2

5

8

8

/

/

t

yo

a

C

_

a

_

0

0

4

9

9

pag

d

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

7

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

mi

d

tu

/

t

a

C

yo

/

yo

a

r

t

i

C

mi

–

pag

d

F

/

d

oh

i

/

.

1

0

1

1

6

2

/

t

yo

a

C

_

a

_

0

0

4

9

9

2

0

4

2

5

8

8

/

/

t

yo

a

C

_

a

_

0

0

4

9

9

pag

d

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

7

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

Mesa 2: El ejemplo de MCWQ de la figura 1. La pregunta en inglés se genera a partir del CFQ

entrada en la tabla 1 por el proceso de migración descrito en §3.3, y las preguntas en los otros idiomas

se traducen automáticamente (§4.1). La pregunta entre corchetes, preguntaPatternMod-

Entidades, chispa, y los campos sparqlPatternModEntities son análogos a los del CFQ.

recursionDepth (que cuantifica la complejidad de la pregunta) y respuesta esperada (cual

es la respuesta devuelta al ejecutar la consulta) se copian de la entrada CFQ.

CFQ

MCWQ

Preguntas unicas

Patrones de preguntas

Consultas únicas

Patrones de consulta

239,357

124,187

49,320 (20.6%)

228,149 (95.3%)

123,262 (51.5%)

29,312 (23.6%)

101,856 (82%)

86,353 (69.5%)

Si no preguntas

¿Qué?- preguntas

130,571 (54.6%)

108,786 (45.5%)

67,523 (54.4%)

56,664 (45.6%)

Mesa 3: Comparación de estadísticas de conjuntos de datos para MCWQ

y CFQ. Los porcentajes son relativos a todos los únicos.

preguntas. Los patrones de preguntas se refieren a mod enti-

corbatas, verbos, etc.. mientras que los patrones de consulta se refieren a mod

solo entidades.

4.1 Generando traducciones

Tanto los patrones de preguntas como las preguntas entre corchetes

se traducen por separado con Google Cloud Trans-

lation5 del inglés.6 Quedan consultas SPARQL

sin alterar, ya que tanto los ID de propiedad como de entidad son

independiente del idioma en Wikidata, cual estafa-

Contiene etiquetas en diferentes idiomas para cada uno.. Mesa 2

muestra un ejemplo de una pregunta en nuestro conjunto de datos

(que se genera a partir de la misma pregunta que

5https://nube.google.com/translate.

6Intentamos traducir las preguntas entre corchetes y sub-

posteriormente reemplace las entidades entre corchetes con marcadores de posición como

patrones de preguntas. En experimentos preliminares, Encontramos eso

la traducción separada de los patrones de preguntas es de mayor trans-

calidad de lacion. Por lo tanto, elegimos traducir la pregunta

patrones y preguntas entre corchetes individualmente.

Cifra 3: Distribución de complejidad de MCWQ, cosa-

asegurado por la profundidad de recursividad, comparado con el CFQ.

4 Generando preguntas multilingües

Para crear un conjunto de datos tipológicamente diverso, comenzar-

ing desde nuestro conjunto de datos en inglés (un indoeuropeo

idioma usando la escritura latina), usamos maquina

traducción a otros tres idiomas de diferentes-

familias ent (afroasiático, dravidiano, y chino-

tibetano), que utilizan diferentes scripts: hebreo,

canarés, y chino (§4.1). Para una comparación

a la traducción automática y una evaluación más realista-

uación con respecto a la composición SP, nosotros el hombre-

traducir generalmente un subconjunto de los conjuntos de prueba del

tres divisiones de MCD (§4.2) y evaluar la máquina

calidad de traducción (§4.3).

942

la instancia CFQ de la tabla 1), así como el

traducciones resultantes.

Como necesidad técnica adicional, añadimos

un signo de interrogación al final de cada pregunta-

traducción anterior (ya que el conjunto de datos original no

incluir signos de interrogación) y eliminar las preguntas finales-

marcas de referencia de la pregunta traducida antes

incluyéndolo en nuestro conjunto de datos. Consideramos que este paso es

esencial para la calidad de la traducción.

4.2 Conjunto de prueba de oro

CFQ y otros conjuntos de datos para evaluar la composición-

generalización posicional (Lago y Baroni, 2018;

Kim y Lenzen, 2020) se generan a partir de gramos-

Marte. Sin embargo, No se ha investigado cómo

Los modelos bien entrenados en ellos se generalizan a hu-

preguntas del hombre. Como un paso hacia ese objetivo,

Evaluamos si los modelos entrenados con auto-

Las preguntas generadas y traducidas automáticamente pueden

generalizar a preguntas traducidas por humanos de alta calidad-

ciones. Para ese propósito, obtenemos la intersección

de los conjuntos de prueba de las divisiones MCD (1,860 en-

intentos), y muestre dos preguntas traducidas con

preguntas de sí/no y dos con wh- preguntas para

cada nivel de complejidad (si está disponible). esta muestra,

denominado prueba-intersección-MT, tiene 155 entradas en

total. Los autores (un hablante nativo para cada

idioma) traducir manualmente las preguntas en inglés-

ciones al hebreo, canarés, y chino. Nosotros

término el conjunto de datos resultante prueba-intersección-oro.

4.3 Calidad de traducción

prueba-intersección-MT contra

Calculamos el BLEU (Papineni et al., 2002)

prueba-

puntuaciones de

intersección-oro usando SacreBLEU (Correo, 2018),

Resultando en 87.4, 76.6, y 82.8 para hebreo,

canarés, y chino, respectivamente. Esto indica

alta calidad de los resultados de la traducción automática.

Además, un autor para cada idioma

evalúa manualmente la calidad de la traducción para un sam-

pregunta formulada de cada nivel de complejidad de

el conjunto de datos completo (40 en total). Calificamos a la trans-

laciones en una escala del 1 al 5 para la fluidez y

preservación del significado, con 1 ser pobre, y 5 ser-

siendo óptimo. A pesar de problemas ocasionales de traducción,

principalmente atribuido a elección léxica o morfología-

acuerdo de cal, confirmamos que las traducciones son

de alta calidad. En todos los idiomas, encima 80% de

puntuación de ejemplos 3 o superior en fluidez y significado

preservación. La preservación del significado promedio.

partituras para hebreo, canarés, y los chinos son 4.4,

3.9, y 4.0, respectivamente. Para la fluidez, ellos son

3.6, 3.9, y 4.4, respectivamente.

como control, uno de los autores (un nativo

Inglés hablante) evaluó la fluidez en inglés para

la misma muestra de 40 preguntas. Solo 62% de

los patrones fueron calificados 3 o superior. mientras todo ingles

las preguntas son gramaticales, muchos sufren de pobreza

fluidez, remontándose a sus géneros automáticos-

ción usando reglas. Algunas traducciones tienen una calificación más alta

en términos de fluidez, principalmente debido al anotador le-

niencia (centrándose en las disfluencias que podrían resultar

de la traducción) y parafraseando lo antinatural

construcciones por el sistema MT (especialmente para

menores complejidades).

5 experimentos

Si bien las arquitecturas especializadas han logrado

resultados de última generación en CFQ (Guo et al., 2020,

2021; Gay y col., 2021), estos enfoques son

Inglés- o específico de Freebase. Por lo tanto, experimentamos-

elemento con secuencia a secuencia (seq2seq) modificación-

los, entre los cuales T5 (Rafael y col., 2020) ha sido

demostrado tener el mejor rendimiento en CFQ (Herzig et al.,

2021). Evaluamos estos modelos para cada LAN.-

calibre por separado (§5.1), y posteriormente evaluar

su generalización compositiva translingüística

(§5.2).

5.1 Experimentos monolingües

Evaluamos el análisis monolingüe de seis modelos.

rendimiento en las tres divisiones de MCD y un aleatorio

división de MCWQ. Como lo hicieron Keysers et al.. (2020),

Las entidades están enmascaradas durante el entrenamiento., excepto aquellos

que son parte de los patrones de preguntas (géneros y

nacionalidades).

Experimentamos con dos arquitecturas seq2seq.

en MCWQ para cada idioma, con la misma hy-

parámetros ajustados por Keysers et al.. (2020) en

la división aleatoria del CFQ: LSTM (Hochreiter y

Schmidhuber, 1997) con mecanismo de atención

(Bahdanau et al., 2015) y trans evolucionada-

anterior (Entonces et al., 2019), ambos implementados usando

Tensor2Tensor (Vaswani et al., 2018). Separado

Los modelos se entrenan y evalúan por idioma.,

con inicializado aleatoriamente (no preentrenado) en-

codificadores. Entrenamos un modelo para cada uno de los tres.

Divisiones MCD más una división aleatoria para cada idioma.

También experimentamos con lenguaje previamente entrenado.

modelos (PLM), para evaluar si son multilingües

PLM, mBERTO (Devlin et al., 2019) y mT5

943

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

mi

d

tu

/

t

a

C

yo

/

yo

a

r

t

i

C

mi

–

pag

d

F

/

d

oh

i

/

.

1

0

1

1

6

2

/

t

yo

a

C

_

a

_

0

0

4

9

9

2

0

4

2

5

8

8

/

/

t

yo

a

C

_

a

_

0

0

4

9

9

pag

d

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

7

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

MCD1

MCD2

MCD3

MCDmedia

Aleatorio

Coincidencia exacta (%)

En

Él

kn

Z h

En

Él

kn

Z h

En

Él

kn

Z h

En

Él

kn

Z h

En

Él

kn

Z h

LSTM+Atención

mi. Transformador

mBERTO

base T5+RIR

mT5-pequeño+RIR

mT5-base+RIR

38.2

53.3

49.5

57.4

77.6

55.5

29.3

35

38.7

–

57.8

59.5

27.1

30.7

34.4

–

55

49.1

26.1

31

35.6

–

52.8

30.2

6.3

16.5

13.4

14.6

13

27.7

5.6

8.7

11.4

–

12.6

16.6

9.9

11.9

12.3

–

8.2

16.6

7.5

10.2

15.1

–

21.1

23

13.6

18.2

17

12.3

24.3

18.2

11.5

13

18

–

17.5

23.4

15.7

18.1

18.1

–

31.4

30.5

15.1

15.5

19.4

–

34.9

35.6

19.4

29.3

26.6

28.1

38.3

33.8

15.5

18.9

22.7

–

29.3

33.2

17.6

20.2

21.6

–

31.5

32.1

16.2

18.9

23.4

–

36.3

29.6

96.6

99

98.7

98.5

98.6

99.1

80.8

90.4

91

–

90

90.6

88.7

93.7

95.1

–

93.8

94.2

86.8

92.2

93.3

–

91.8

92.2

Mesa 4: Evaluación monolingüe: Precisiones de coincidencia exacta en MCWQ. MCDmean es la media acumulada-

picante de las tres divisiones de MCD. Aleatorio representa una división aleatoria de MCWQ. Este es un límite superior

sobre el rendimiento mostrado sólo para comparación. Como las puntuaciones SPARQL BLEU están altamente correlacionadas con

precisiones en este experimento, aquí solo mostramos este último.

(Xue et al., 2020), son tan efectivos para monolin-

generalización compositiva gual como inglés-

sólo PLM que utiliza la biblioteca Transformers (Lobo

et al., 2020).

Para mBERT, afinamos un multicased

Codificador L-12 H-768 A-12 y un codificador aleatorio.

decodificador inicializado de la misma arquitectura. Nosotros

entrenar para 100 épocas con paciencia de 25, lote

tamaño de 128, y tasa de aprendizaje de 5 × 10−5 con un

decaimiento lineal.

Para T5, ajustamos la base T5 en MCWQ

Inglés, y mT5-small y mT5-base en

cada idioma por separado. Usamos el hy predeterminado-

configuración de parámetros excepto probar dos aprendizaje

tarifas, 5e-4 y 3e-5 (ver resultados a continuación). SPARQL

Las consultas se procesan previamente mediante interconexión reversible.-

mediar representaciones (RIR), mostrado anteriormente

(Herzig et al., 2021) para facilitar la composición

generalización para T5. Ajustamos todos los modelos para

50k pasos.

Usamos seis GPU Titan RTX para entrenar, con

tamaño de lote de 36 para base T5, 24 para mT5-

pequeño, y 12 para base mT5. Usamos dos

semillas aleatorias para base T5. Se necesita 384 horas

para finalizar una ronda de pequeños experimentos mT5,

120 horas para T5-base, y 592 horas para

base mT5.

Además de la precisión de coincidencia exacta, nosotros reportamos

las puntuaciones BLEU de las predicciones calculadas

con SacreBLEU, como una gran parte de la generación-

consultas borradas es parcialmente (pero no completamente) correcto.

Resultados Los resultados se muestran en la tabla. 4. Mientras

Los modelos se generalizan casi perfectamente en el azar.

dividido para los cuatro idiomas, las divisiones de MCD son

mucho más duro, con las precisiones medias más altas

de 38.3%, 33.2%, 32.1%, y 36.3% para ingles,

hebreo, canarés, y chino, respectivamente. Para

comparación, en CFQ, T5-base+RIR tiene una ac-

curaduría de 60.8% en MCDmedia (Herzig et al.,

2021). Una de las razones de esta disminución en el rendimiento

son los datos de entrenamiento más pequeños: El conjunto de datos MCWQ

tiene 52.5% el tamaño del CFQ. Además, MCWQ

tiene menos redundancia que CFQ en términos de dupli-

cate preguntas y patrones SPARQL, representación

La estrategia potencial de los modelos de simplemente memorizar

patrones menos efectivos.

Contrariamente a lo esperado, La base mT5 no

supera al mT5-pequeño. Durante el entrenamiento, nosotros

Se descubrió que la base mT5 alcanzó la pérdida mínima temprano

(después de 1k pasos). Al cambiar la tasa de aprendizaje de

el valor predeterminado 3e-5 a 5e-4, parece que hemos terminado-

ven el minimo local. Entrenamiento mT5-pequeño

con una tasa de aprendizaje de 5e−4 también se obtiene mejor por-

rendimiento. Además, el tamaño de lote que utilizamos para

La base mT5 puede no ser óptima, pero podríamos

No experimente con lotes de mayor tamaño debido a

limitaciones de recursos.

Comparación del rendimiento entre idiomas,

mT5-base funciona mejor en hebreo y kan-

nada on average, mientras que mT5-small tiene lo mejor

Rendimiento en inglés y chino.. debido a re-

limitaciones de fuente, no pudimos mirar más profundamente

en el efecto de los hiperparámetros o evaluar

modelos más grandes. Sin embargo, nuestros experimentos muestran

que si bien la composición multilingüe generaliza-

ción es un desafío para los analizadores semánticos seq2seq,

La generalización dentro del lenguaje es comparable-

entre idiomas. Sin embargo, El inglés siempre es

Lo más fácil (al menos marginalmente). Una causa potencial

es que la mayoría de los lenguajes de consulta semánticos eran iniciales-

Diseñado inicialmente para representar y recuperar datos almacenados.

en bases de datos en ingles, y por lo tanto tener un sesgo hacia

Inglés. Como consecuencia, La sintaxis SPARQL está más cerca

al inglés que al hebreo, canarés, y chino.

Si bien los errores de traducción pueden tener un efecto como

Bueno, Hemos visto en §4.3 que la calidad de la traducción

es alto.

Para investigar más, trazamos la complejidad

distribución de predicciones verdaderas (exactamente coincidente

944

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

mi

d

tu

/

t

a

C

yo

/

yo

a

r

t

i

C

mi

–

pag

d

F

/

d

oh

i

/

.

1

0

1

1

6

2

/

t

yo

a

C

_

a

_

0

0

4

9

9

2

0

4

2

5

8

8

/

/

t

yo

a

C

_

a

_

0

0

4

9

9

pag

d

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

7

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

MCDmedia

Aleatorio

AZUL ESPECIAL

En

Él

kn

Z h

En

Él

kn

Z h

mT5-pequeño+RIR

mT5-base+RIR

87.5

86.4

53.8

46.4

53.2

46

59

52.7

99.9

99.9

60.4

63.2

59.9

63.5

63.8

70.6

Coincidencia exacta (%)

mT5-pequeño+RIR

mT5-base+RIR

38.3

33.8

0.2

0.4

0.3

0.7

0.2

1.5

98.6

99.1

0.5

1.1

0.4

0.9

1.1

7.2

Mesa 5: Puntuaciones BLEU medias y ac de coincidencia exacta-

curaciones en las tres divisiones de MCD y en un azar

dividido en una experiencia de transferencia interlingüística sin disparos-

comentarios sobre MCWQ. El texto gris representa el

Desempeño monolingüe de los modelos en inglés.,

dado como referencia (las precisiones de coincidencia exacta

se copian de la tabla 4). El texto negro indica

las actuaciones de transferencia interlingüística zero-shot

en hebreo, canarés, y chino de un modelo

entrenado en ingles. Mientras que las puntuaciones para individ-

Las divisiones duales de MCD se omiten por brevedad., en los tres

MCD se divide, las precisiones están a continuación 1% (excepto

en MCD2 Chino, ser 4%).

et al., 2020; Sherborne y Lapata, 2022). Ser-

Causa traducción de conjuntos de datos y entrenamiento KBQA.

los sistemas son caros, es beneficioso aprovechar

PLM multilingües, ajustado a los datos en inglés,

para generar consultas SPARQL a través de Wikidata

se le dieron preguntas en lenguaje natural en diferentes idiomas-

calibres. Si bien la generalización compositiva es

difícil incluso en un entorno monolingüe, es entre-

Estamos intentando investigar si los PLM multilingües

se puede transferir en SP multilingüe a través de Wikidata.

Los modelos simples seq2seq T5/mT5 realizan el motivo-

hábilmente bien (> 30% exactitud) en SP monolingüe

en algunas divisiones (ver §5.1). Investigamos si

las representaciones multilingües aprendidas de tales

Los modelos permiten la generalización compositiva incluso

sin formación en el idioma de destino. Usamos mT5-

pequeño+RIR y mT5-base+RIR, los dos mejores

modelos entrenados y evaluados en inglés desde

experimentos previos,

predecir por el otro

idiomas.

Resultados Los resultados se muestran en la tabla. 5. Ambos

BLEU y precisión de coincidencia exacta de lo previsto

Las consultas SPARQL caen drásticamente cuando el modelo

se evalúa en hebreo, canarés, y chino.

mT5-small+RIR logra 38.3% precisión en

MCDmedio Inglés, pero menos que 0.3% en tiro cero

análisis de tres idiomas distintos del inglés.

Incluso dejando de lado la evaluación de la composicionalidad,

como se ve en la división aleatoria, la coincidencia exacta ac-

La curaduría en el entorno translingüístico de tiro cero es

Cifra 4: Número de pre correctos de dos modelos mT5-

los tres MCD se dividen en

dicciones resumiendo

experimentos monolingües, trazado por nivel de complejidad.

Cada línea representa un idioma.. Mientras que mT5-pequeño

generaliza mejor en general, La base mT5 es mejor en

menores complejidades (que requieren menos composición

generalización).

el oro SPARQL) por idioma por los dos mejores

sistemas en la figura 4. Somos testigos de una situación casi lineal

deterioro del rendimiento desde el nivel de complejidad 19. Nosotros

descubre que mT5-base es mejor que mT5-small

en menor complejidad a pesar de la super-

rendimiento general anterior. Curiosamente, traducido

Las preguntas parecen hacer que los analizadores generalicen.

mejor a mayor complejidad, como se muestra en el

cifra. Para mT5-pequeño, los tres no ingleses

Los modelos analizan con éxito más preguntas dentro

la complejidad oscila entre 46 y 50 que la del inglés, para

base mT5 44–50. Como se analiza en §4.3,

Las preguntas traducidas automáticamente tienden a tener mayor

fluidez que las preguntas en inglés; nosotros conjeturamos

que tal método de suavizado ayuda al analizador

comprender y aprender de una mayor complejidad

preguntas.

5.2 Análisis multilingüe de disparo cero

SP multilingüe Zero-shot ha sido testigo de nuevas

avanza con el desarrollo de PLM (shao

945

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

mi

d

tu

/

t

a

C

yo

/

yo

a

r

t

i

C

mi

–

pag

d

F

/

d

oh

i

/

.

1

0

1

1

6

2

/

t

yo

a

C

_

a

_

0

0

4

9

9

2

0

4

2

5

8

8

/

/

t

yo

a

C

_

a

_

0

0

4

9

9

pag

d

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

7

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

permanece bajo. Las puntuaciones BLEU relativamente altas pueden

atribuirse al reducido vocabulario general

utilizado en consultas SPARQL. Curiosamente, mientras

mT5-base+RIR en MCDmean English no

supera a mT5-pequeño+RIR,

rinde mejor

rendimiento en la configuración de disparo cero. Para el-

elaborar cerveza, canarés, y chino, las precisiones son

0.2%, 0.4%, y 1.3% más alto, respectivamente. Para

base mT5, El chino es un poco más fácil que el Kan.-

nada y hebreo para analizar en la configuración de disparo cero,

superando 1.1% y 0.8%.

Para concluir, transferencia interlingüística zero-shot

del ingles al hebreo, canarés, y chino

no puede generar consultas válidas en MCWQ. Y noche-

La causa potencial de dicha transferencia fallida es que

los cuatro idiomas en MCWQ pertenecen a diferentes

familias lingüísticas y tienen baja simulación lingüística-

ilaridades. Queda por investigar si

dicha transferencia entre idiomas será más efectiva

en idiomas relacionados, como del inglés al

Alemán (Lin et al., 2019).

6 Análisis

6.1 Evaluación con Gold Translation

La mayoría de los datos de generalización compositiva existentes.-

se centra en SP (Lago y Baroni, 2018; kim

y lentejas, 2020; Keysers et al., 2020). Estos

Los conjuntos de datos se componen de LAN artificial.-

idioma o en inglés usando reglas gramaticales. Con

prueba-intersección-oro propuesta en §4.2, nosotros en-

Investigar si los modelos pueden generalizarse a partir de

un conjunto de datos sintético traducido automáticamente a un

conjunto de datos traducido manualmente.

Utilizamos los modelos monolingües entrenados en

tres divisiones de MCD para analizar test-intersection-gold.

En mesa 6, presentamos las puntuaciones medias de BLEU y

precisión de coincidencia exacta del SPARQL previsto

consultas. No hay ninguna diferencia sustancial-

entre las actuaciones en la intersección de dos

conjuntos, excepto kannada, que tiene un 4% acumular-

caída picante en promedio. Estos resultados atestiguan que

MCWQ tiene una calidad de traducción suficientemente alta.-

idad y que los modelos entrenados con tales sintéticos

Los datos se pueden utilizar para generalizar a alta calidad.

preguntas traducidas manualmente.

6.2 Errores de categorización

En un análisis empírico, categorizamos lo típico

errores de predicción en prueba-intersección-oro y

prueba-intersección-MT en seis tipos: accesorio faltante-

erty, propiedad extra, propiedad equivocada (donde el

AZUL ESPECIAL

En

Él

kn

Z h

En

Él

kn

Z h

prueba-intersección-MT

prueba-intersección-oro

mT5-pequeño+RIR

mT5-base+RIR

86.1

85.5

82.5

83.7

78.9

81.8

85.1

83.2

Coincidencia exacta (%)

mT5-pequeño+RIR

mT5-base+RIR

45.6

40.4

35.7

41.9

32.7

40.2

38.5

38.7

–

–

–

–

81.8

83.8

77.7

80.9

86

83.8

35.9

41.1

28.2

34

39.8

38.9

Mesa 6: Puntuaciones BLEU medias y precisiones de

modelos monolingües (§5.1) en la intersección de prueba-

MT y prueba-intersección-oro. Los números son

promediado sobre la exactitud de las predicciones

de los modelos monolingües entrenados en tres

MCD se divide. En general, no hay diferencia sustancial-

diferencia entre las actuaciones de los dos

conjuntos de intersecciones, demostrando la confiabilidad de

evaluación de datos traducidos automáticamente en este caso.

Cifra 5: Número de errores por categoría en diferentes-

predicciones SPARQL ent test-intersection-MT y

prueba-intersección-oro, promediado en monolingües

Modelos mT5-small+RIR entrenados en los tres MCD

se divide. El número total de elementos en cada conjunto de prueba es 155.

dos conjuntos de propiedades tienen el mismo número de propiedades-

erties, pero los elementos no coinciden), desaparecido

entidad, entidad extra y entidad incorrecta (de nuevo, mismo

número de entidades pero diferentes conjuntos de entidades). Nosotros

trazar el número medio de errores por categoría, como

así como el número de predicciones con múltiples

errores, En figura 5 para monolingüe mT5-pequeño

modelos. En general, Las predicciones del modelo tienden a tener

Más propiedades y entidades faltantes que extra.

unos. Idiomas diferentes, sin embargo, variar en er-

tipos de errores. Por ejemplo, en hebreo, modelos hacen

más errores de propiedad/entidad faltantes que otros

idiomas; pero en kannada hacen más ex-

errores de propiedad/entidad que los demás. Acerca de

70 fuera de 155 los ejemplos contienen múltiples

errores para todos los idiomas, con Kannada teniendo

un poco más.

946

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

mi

d

tu

/

t

a

C

yo

/

yo

a

r

t

i

C

mi

–

pag

d

F

/

d

oh

i

/

.

1

0

1

1

6

2

/

t

yo

a

C

_

a

_

0

0

4

9

9

2

0

4

2

5

8

8

/

/

t

yo

a

C

_

a

_

0

0

4

9

9

pag

d

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

7

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

Cifra 7: Ejemplo de un error que refleja incorrecto

estructura del argumento predicado. wdt:P57 es director

y wdt:P58 es guionista. Los triples incorrectos son

se muestra en rojo y los triples fallidos en azul.

marcadores de posición. En el ejemplo mostrado en la Figura 7,

vemos que el modelo genera M1 wdt:P57

M2 en lugar de M0 wdt:P57M2, En cual-

indica una estructura predicado-argumento incorrecta

interpretación.

7 Trabajo relacionado

Generalización compositiva Composicional

La generalización ha sido testigo de grandes avances.

en años recientes. ESCANEAR (Lago y Baroni, 2018),

un conjunto de datos sintéticos que consta de lenguaje natural

y pares de comandos, es un conjunto de datos temprano diseñado

evaluar sistemáticamente el gen de las redes neuronales-

capacidad de eralización. CFQ y COGS son dos más

puntos de referencia realistas después de SCAN. Hay

varios enfoques desarrollados para mejorar la com-

generalización posicional, Por ejemplo, mediante el uso

decodificación poset jerárquica (Guo et al., 2020),

combinando consultas relevantes (Das et al., 2021)

usando representación de intervalo (Herzig y Berant,

2021), y codificación de gráficos (Gay y col., 2021).

Además del lenguaje puro, la evaluación de

La generalización compositiva se ha ampliado.

a los subtítulos de imágenes y al lenguaje situado en-

de pie (Nikolaus et al., 2019; Ruis et al., 2020).

Gen compositivo multilingüe y translingüe-

La digitalización es un campo importante y desafiante.

a lo que nuestro artículo pretende acercar a los investigadores

atención.

lectura

a máquina

Base de conocimientos Respuesta a preguntas Com-

mondadura

comprensión

(Rajpurkar et al., 2016; Joshi et al., 2017; shao

et al., 2018; Dua et al., 2019; d'Hoffschmidt

et al., 2020), KBQA es menos diversa en términos de

conjuntos de datos. Conjuntos de datos como WebQuestions (tarde

et al., 2013), Preguntas simples (Bordes et al., 2015),

Preguntas web complejas (Talmor y Berant, 2018),

FreebaseQA (Jiang et al., 2019), GrialQA (Gu

et al., 2021), CFQ y *CFQ (Tsárkov et al., 2021)

fueron propuestos en Freebase, un ahora descontinuado

KB. PreguntasSimples2Wikidata (Diefenbach et al.,

Cifra 6: Número de errores por categoría en diferentes-

predicciones SPARQL multilingües de tiro cero en

prueba-intersección-MT, promediado en mT5-small+

Modelos RIR entrenados en las tres divisiones de MCD en En-

inglés. Además, el error medio cuenta en inglés

Los conjuntos se dan para comparar.. El numero total de

elementos en cada conjunto de prueba es 155.

Comparación de errores en prueba-intersección-oro y

prueba-intersección-MT, encontramos propiedades faltantes

son más comunes en oro para todos los idiomas. Para

Hebreo y kannada, propiedades extra y enti-

Las corbatas también son más comunes en oro.. Sin embargo, para

Chino, estas y las entidades faltantes son menos com-

mon en oro en comparación con MT.

En figura 6 trazamos las estadísticas de error para cero-

transferencia usando mT5-small

disparo multilingüe

modelos. Podemos ver que hay drásticamente más

ocurrencias de errores. Tanto para lo que falta como para lo que sobra

propiedad/entidad,

los números son aproximadamente el doble

los de experimentos monolingües. El número

de errores de propiedad/entidad incorrecta siguen siendo similares,

debido a la dificultad de incluso predecir un conjunto de

el tamaño correcto en esta configuración. Para los tres objetivos

idiomas, casi todas las predicciones contienen múltiples-

errores simples. Las estadísticas indican la variedad y

omnipresencia de errores.

6.3 Otras observaciones

También encontramos que, relativamente, los analizadores realizan

bien en preguntas cortas en los cuatro idiomas.

Esto es de esperarse ya que la composicionalidad de estos

preguntas es inherentemente bajo. En otros idiomas

que ingles, Los modelos funcionan bien cuando

traducciones son fieles. En ocasiones cuando ellos

son menos fieles o fluidos pero aun así generan cor-

consultas correctas, Nuestra hipótesis es que la traducción actúa.

como regularizadores de datos, especialmente en mayor com-

plejidades, como se demuestra en la figura 4.

Entre errores de entidad incorrecta, los más comunes

La causa entre idiomas es la mezcla de entidades.

947

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

mi

d

tu

/

t

a

C

yo

/

yo

a

r

t

i

C

mi

–

pag

d

F

/

d

oh

i

/

.

1

0

1

1

6

2

/

t

yo

a

C

_

a

_

0

0

4

9

9

2

0

4

2

5

8

8

/

/

t

yo

a

C

_

a

_

0

0

4

9

9

pag

d

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

7

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

2017) y preguntas secuenciales complejas (saha

et al., 2018) están basados en Wikidata, pero, me gusta más

otros, son conjuntos de datos monolingües en inglés.

Relacionado con nuestro trabajo está RuBQ (Corablinov y

Braslavski, 2020; Rybin et al., 2021), Un inglés-

Conjunto de datos ruso para KBQA a través de Wikidata. Mientras

el conjunto de datos es bilingüe, utiliza preguntas colaborativas-

ciones y no está diseñado para la composicionalidad

análisis. Recientemente, Thorne y otros. (2021) propuesto

WIKINLDB, un KBQA en inglés basado en Wikidata

conjunto de datos, centrándose en la escalabilidad en lugar de la composición-

sicionalidad. Otros conjuntos de datos relacionados incluyen QALM

(Kaffee y cols., 2019), un conjunto de datos para multilingüe

respuesta a preguntas sobre un conjunto de diferentes populares

gráficos de conocimiento, destinado a ayudar a determinar la

multilingüismo de esos gráficos de conocimiento. simí-

mucho, QALD-9 (Ngomo, 2018) y QALD-9-plus

(Perevalov et al., 2022a) apoyar el desarrollo-

mento de sistemas multilingües de respuesta a preguntas,

vinculado a DBpedia y Wikidata, respectivamente. El

El objetivo de ambos conjuntos de datos es ampliar los sistemas de control de calidad para

más idiomas en lugar de mejorar la composición-

nacionalidad. KQA Pro (Cao et al., 2022), un concurrente

trabaja para nosotros, es un conjunto de datos KBQA en inglés sobre

Wikidata con un enfoque en el razonamiento compositivo.

Wikidata se ha aprovechado en muchos programas de PNL.

Tareas como la resolución de correferencia. (en diciembre

et al., 2019), análisis semántico de marcos (Sas et al.,

2020), vinculación de entidades (Según Ravi et al., 2021),

y reconocimiento de entidad nombrada (Nie et al., 2021).

En cuanto a KBQA, todo el potencial de Wikidata es

aún por explorar.

Plurilingüe

y modelado multilingüe

Puntos de referencia como XGLUE (Liang et al., 2020)

y EXTREMO (Hu et al., 2020) centrarse en múltiples-

Tareas de clasificación y generación lingüística.. Cruz-

El aprendizaje lingüístico se ha estudiado en múltiples

campos, como el análisis de sentimientos (Abdalla y

primero, 2017), clasificación de documentos (dong y

de Melo, 2019), Etiquetado de punto de venta (Kim y cols., 2017),

y análisis sintáctico (Rasooli y Collins, 2017).

En años recientes, Los PLM multilingües han sido un

herramienta principal para extender las aplicaciones de PNL a

idiomas de bajos recursos, como estos modelos amelio-

Calificar la necesidad de entrenar modelos individuales para cada uno.

idioma, para los cuales puede haber menos datos disponibles.

Varios estudios han intentado explorar la

limitaciones de tales modelos en términos prácticos.

usabilidad para lenguajes de bajos recursos (Wu y

Dragar, 2020), y también los elementos subyacentes

que hacen viable el aprendizaje por transferencia translingüe

(Fragancias y Schütze, 2020). Más allá de estos PLM,

Otros trabajos se centran en mejorar el interlingüismo.

aprender haciendo cambios particulares en el

arquitectura codificador-decodificador, como agregar

Adaptadores para sintonizar con información específica. (casa de arte

et al., 2020b; Pfeiffer et al., 2020).

Para SP multilingüe, Sherborne y Lapata

(2022) exploró SP de disparo cero alineando latentes

representaciones. SP multilingüe Zero-shot tiene

También se ha estudiado en el modelado de diálogo. (Nicosia

et al., 2021). Yang y otros. (2021) presente aumenta-

Métodos de interpretación para la teoría de la representación del discurso.

(Liu et al., 2021b). Oepen et al. (2020) explorar

SP entre marcos y entre idiomas para la media-

representaciones. A lo mejor de nuestro conocimiento,

nuestro trabajo es el primero en estudiar idiomas cruzados

transferir aprendizaje en KBQA.

8 Limitaciones

MCWQ se basa en CFQ, una base de reglas generada

conjunto de datos, y por eso tiene la propiedad antinatural heredada.-

ness en pares pregunta-consulta de alta complejidad.

En segundo lugar, utilizamos la traducción automática para hacer

MCWQ multilingüe. Aunque este es el domi-

Enfoque nant para generar conjuntos de datos multilingües.

(Ruder et al., 2021) y hemos proporcionado ev-

Identidades de que MCWQ tiene una traducción razonable.

precisión y fluidez con la evaluación humana y

experimentos comparativos en §4.3 y §5.1, mamá-

Sin embargo, la traducción china crearía sub-

artefactos de traducción estándar (Artetxe et al.,

2020a). Una alternativa es escribir reglas para los tiempos.-

traducción de placa. La cantidad de trabajo posiblemente

reducirse haciendo referencia a un trabajo reciente (Goodwin

et al., 2021) en el que se proporcionan reglas en inglés

para el análisis de dependencia sintáctica en las preguntas de CFQ-

campos de ción.

Además, la suposición de que una base de conocimiento en inglés

es una conceptualización “canónica” no está justificada,

como los hablantes de otras lenguas pueden saber y preocuparse

sobre otras entidades y relaciones (Liu et al.,

2021a; Hershcovich et al., 2022a). Por lo tanto,

El trabajo futuro debe crear conjuntos de datos SP multilingües.

obteniendo preguntas de hablantes nativos en lugar de

que traducirlos.

9 Conclusión

El campo de KBQA se ha saturado con

trabajar en ingles, debido tanto al desafío inherente-

Las distancias a la hora de traducir conjuntos de datos y la dependencia de

Bases de datos solo en inglés. En este trabajo, presentamos un

948

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

mi

d

tu

/

t

a

C

yo

/

yo

a

r

t

i

C

mi

–

pag

d

F

/

d

oh

i

/

.

1

0

1

1

6

2

/

t

yo

a

C

_

a

_

0

0

4

9

9

2

0

4

2

5

8

8

/

/

t

yo

a

C

_

a

_

0

0

4

9

9

pag

d

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

7

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

MCWQ mT5-base+RIR

Referencias

Información

Unidad

1. Modelo disponible públicamente?

2. Es hora de entrenar el modelo final.

3. Tiempo para todos los experimentos.

4. Consumo de energía

5. Ubicación para cálculos

6. Mezcla energética en la ubicación

7. CO2eq para el modelo final

8. CO2eq para todos los experimentos

Sí

592 horas

1315 horas

2209.2 kWh

Dinamarca

191 gCO2eq/ kWh

189.96 kg

421.96 kg

Mesa 7: Tarjeta modelo de desempeño climático para

mT5-base+RIR ajustado en todas las divisiones y

idiomas.

método para migrar el conjunto de datos CFQ existente

a Wikidata y creó un desafiante multilin-

conjunto de datos gual, MCWQ,

orientación composicional

generalización en multilingüe y translingüe

SP. En nuestros experimentos, observamos que pre-

Los modelos lingüísticos multilingües entrenados luchan por

transferir y generalizar composicionalmente a lo largo

idiomas. Nuestro conjunto de datos facilitará la construcción

analizadores semánticos multilingües robustos al servir

como punto de referencia para la evaluación del interlingüismo

generalización compositiva.

10 Impacto medioambiental

Siguiendo la práctica consciente del clima propuesta

por Hershcovich et al.. (2022b), presentamos un cli-

tarjeta de modelo de rendimiento mate en la tabla 7. ''Tiempo

para entrenar el modelo final '' es la suma de las divisiones y

Idiomas para mT5-base+RIR, mientras que "Es hora de

todos los experimentos'' también incluye los experimentos

con el T5-base+RIR solo en inglés en todos

se divide. Aunque la obra no tiene pos directo-

impacto ambiental activo, mejor entendimiento

de generalización compositiva, resultante de

nuestro trabajo, facilitará un modelado más eficiente

y por tanto reducir las emisiones a largo plazo.

Expresiones de gratitud

Los autores agradecen a Anders Søgaard y Miryam.

de Lhoneux por sus comentarios y sugerencias.,

así como los editores de TACL y varias rondas de

revisores por su evaluación constructiva. Este

El proyecto ha recibido financiación de la Unión Europea.

El horizonte de la Unión 2020 investigación e innovación

programa de Marie Skłodowska-Curie

acuerdo de subvención No. 801199 (Brezo Cuaresma).

Mohamed Abdalla y Graeme Hirst. 2017.

Análisis de sentimiento multilingüe sin (bien)

traducción. En Actas del Octavo En-

Conferencia Conjunta Internacional sobre Lan Natural-

Procesamiento de calibre (Volumen 1: Artículos largos),

páginas 506–515, Taipéi, Taiwán. Federación Asiática-

ción del procesamiento del lenguaje natural.

Rahul Aralikate, Brezo Cuaresma, Ana Valeria

González, Daniel Herschcovich, Chen Qiu,

Anders Sandholm, Michael Ringaard, y

Anders Sogaard. 2019. Correferencia gratificante

resolutores por ser consistentes con el conocimiento mundial-

borde. En Actas de la 2019 Conferencia

sobre métodos empíricos en lenguaje natural

Procesamiento y IX Conjunción Internacional

Conferencia sobre procesamiento del lenguaje natural

(EMNLP-IJCNLP), páginas 1229–1235, Hong Kong,

Porcelana. Asociación de Lin Computacional-

guísticos. https://doi.org/10.18653/v1

/D19-1118

Mikel Artetxe, Gorka Lavaka,

y eneko

aguirre. 2020a. Artefactos de traducción en cruz.-

transferir aprendizaje. En procedimientos de

lingual

el 2020 Conferencia sobre métodos empíricos

en procesamiento del lenguaje natural (EMNLP),

páginas 7674–7684, En línea. Asociación para Com-

Lingüística putacional. https://doi.org/10

.18653/v1/2020.emnlp-main.618

Mikel Artetxe, Sebastián Ruder, y dani

Yogatama. 2020b. Sobre la translingüística-

ferabilidad de representaciones monolingües. En

Actas de la 58ª Reunión Anual de

la Asociación de Lingüística Computacional,

páginas 4623–4637, En línea. Asociación para Com-

Lingüística putacional. https://doi.org

/10.18653/v1/2020.acl-main.421

Dzmitry Bahdanau, Kyung Hyun Cho, y yoshua

bengio. 2015. Traducción automática neuronal por

aprender juntos a alinear y traducir. en 3ro

Conferencia Internacional sobre Aprendizaje Repre-

sentaciones, ICLR 2015.

Jonathan Berant, Andrés Chou, Roy Frosty, y

Percy Liang. 2013. Análisis semántico gratuito-

base de pares de preguntas y respuestas. En curso-

cosas de

el 2013 Conferencia sobre Empirismo

Métodos en el procesamiento del lenguaje natural,

páginas 1533–1544, seattle, Washington, EE.UU.

Asociación de Lingüística Computacional.

949

yo

D

oh

w

norte

oh

a

d

mi

d

F

r