Soluciones emergentes para alta dimensión

Aprendizaje por refuerzo multitarea

Esteban Kelly

Departamento de Ciencias de la Computación, Universidad de Dalhousie, 6050 Avenida Universidad,

halifax, NS, B3H 4R2, Canada

skelly@cs.dal.ca

malcolm yo. heywood

Departamento de Ciencias de la Computación, Universidad de Dalhousie, 6050 Avenida Universidad,

halifax, NS, B3H 4R2, Canada

mheywood@cs.dal.ca

doi:10.1162/EVCO_a_00232

Abstracto

Algoritmos que aprenden a través de la interacción ambiental y recompensas retrasadas, o volver-

aprendizaje por refuerzo (rl), enfrentan cada vez más el desafío de escalar a la dinámica, alto-

dimensional, y entornos parcialmente observables. Se está prestando mucha atención

a marcos de aprendizaje profundo, que escalan a datos de alta dimensión mediante descomposiciones-

Realizar la tarea a través de redes neuronales multicapa.. Si bien es efectivo, la representación

es complejo y computacionalmente exigente. En este trabajo, proponemos un marco

basado en una programación genética que complejiza adaptativamente las políticas a través de-

acción con la tarea. Hacemos una comparación directa con varios refuerzos profundos.

marcos de aprendizaje en el desafiante entorno de videojuegos Atari, así como más

Marcos tradicionales de aprendizaje por refuerzo basados en características diseñadas a priori..

Los resultados indican que el enfoque propuesto coincide con la calidad del aprendizaje profundo mientras

siendo un mínimo de tres órdenes de magnitud más simple con respecto al modelo com-

plejidad. Esto da como resultado la operación en tiempo real del agente campeón de RL sin recursos.

al soporte de hardware especializado. Además, el enfoque es capaz de desarrollar soluciones-

ciones a múltiples títulos de juegos simultáneamente sin costo computacional adicional. En

este caso, comportamientos de los agentes para un juego individual, así como agentes individuales capaces de

jugar todos los juegos surgen de la misma carrera evolutiva.

Palabras clave

Modularidad emergente, coevolución cooperativa, programación genética, reforzamiento

aprendiendo, aprendizaje multitarea.

1

Introducción

Aprendizaje reforzado (rl) Es un área del aprendizaje automático en la que un agente desarrolla una

Política de toma de decisiones a través de la interacción directa con un entorno de tareas.. Específicamente,

El agente observa el entorno y sugiere una acción basada en la observación.,

repetir el proceso hasta que se encuentre un estado final de tarea. El estado final proporciona una

señal de recompensa que caracteriza la calidad de la póliza, o el grado de éxito/fracaso.

Por lo tanto, el objetivo de la política es seleccionar acciones que maximicen esta recompensa a largo plazo..

En aplicaciones del mundo real de RL, Es probable que el agente observe el entorno.

a través de una interfaz sensorial de alta dimensión (p.ej., una cámara de vídeo). Esto potencialmente

implica que: (1) Los agentes de RL deben poder evaluar grandes cantidades de información de “bajo nivel”.-

formación; (2) A menudo no se dispone de información completa sobre el medio ambiente.

Manuscrito recibido: 11 Julio 2017; revisado: 22 Puede 2018 y 1 Junio 2018; aceptado: 6 Junio 2018.

© 2018 Instituto de Tecnología de Massachusetts.

Publicado bajo Creative Commons

Atribución 4.0 no portado (CC POR 4.0) licencia.

Computación evolutiva 26(3): 347–380

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

/

mi

d

tu

mi

v

C

oh

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

2

6

3

3

4

7

1

5

5

2

3

7

5

mi

v

C

oh

_

a

_

0

0

2

3

2

pag

d

.

/

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

S. kelly y m. I. heywood

una sola observación; y (3) Las interacciones prolongadas y las recompensas escasas son comunes.,

Requerir que el agente tome miles de decisiones antes de recibir suficiente retroalimentación.

evaluar la calidad de la política. dicho eso, Las aplicaciones potenciales para RL son enormes.

y diverso, de la robótica autónoma (Kober y Peters, 2012) a los videojuegos (Tamiz,

2012), motivando así la investigación sobre marcos de RL que sean lo suficientemente generales como para ser aplicables.-

Se aplica a una variedad de entornos sin el uso de características específicas de la aplicación..

Abordar la dinámica, de alta dimensión, y las tareas parcialmente observables en RL tienen

Recientemente ha recibido mucha atención debido a: (1) la disponibilidad de un conveniente

Emulador de videojuegos que admite cientos de títulos., como Arcade Learning Envi-

ambiente (PERO) (Bellamare, Naddaf et al., 2012); y, (2) resultados humanos competitivos de

aprendizaje profundo (p.ej., Mnih et al., 2015). ALE define el estado, (cid:2)s(t ), en términos de pantalla directa

captura, mientras que las acciones se limitan a las de la consola Atari original. De este modo, aprender-

Los agentes interactivos interactúan con los juegos a través de la misma interfaz que experimentan los jugadores humanos..

En muestreo 49 títulos de juegos, cada uno diseñado para ser interesante y desafiante para los humanos

jugadores, Se identifican entornos de tareas con una amplia gama de propiedades.. Tal como, cada

El título del juego requiere una política de RL distinta que sea capaz de maximizar la puntuación a lo largo del tiempo.

curso del juego.

En este trabajo, Introducimos una programación genética. (médico de cabecera) marco que especifica-

aborda fácilmente los desafíos en la ampliación de RL a tareas del mundo real manteniendo un mínimo

complejidad del modelo. El algoritmo utiliza modularidad emergente. (Nolfi, 1997) a adaptativamente

Complejizar las políticas a través de la interacción con el entorno de la tarea.. Un equipo de programas

representa el módulo de comportamiento básico (Lichodzijewski y Heywood, 2008b), o un

mapeo de la observación del estado a una acción. En tareas secuenciales de toma de decisiones, cada

El programa dentro de un equipo define un comportamiento de oferta único. (Sección 3.2), tal que pro-

Los gramos seleccionan cooperativamente una acción del equipo en relación con el estado actual del observador.-

variación en cada paso de tiempo.

La evolución comienza con una población de equipos simples., Figura 1a, que luego son pieles-

luego desarrollado agregando, eliminando, y modificar programas individuales. este trabajo

extiende versiones anteriores de una versión anterior (simbiótico) enfoque para el equipo de GP (Lichodz-

ijewski y heywood, 2011; Doucette y cols., 2012; Kelly y col., 2012; kelly y oye-

madera, 2014b, 2014a) para permitir una modularidad conductual emergente a partir de un único ciclo de

evolución mediante la recombinación adaptativa de múltiples equipos en equipos dirigidos de forma variable y profunda.

estructuras graficas, o gráficos de programas enredados (TPG)1 (Figura 1b). El comportamiento de cada uno.

programa, complemento de programas por equipo, complemento de equipos por gráfico, y el

La conectividad dentro de cada gráfico son propiedades emergentes de una evolución abierta.-

proceso ario. Los beneficios de este enfoque son dobles.:

1. Un único gráfico de equipos, o gráfico de políticas, eventualmente puede evolucionar para incluir hun-

cientos de equipos, donde cada uno representa un simple, comportamiento especializado (Cifra

1b). Sin embargo, mapear una observación de estado a una acción requiere atravesar solo

un camino a través del gráfico desde la raíz (equipo) hojear (acción). De este modo, el representante-

La presentación es capaz de compartimentar muchos comportamientos y recordar sólo

aquellos relevantes para las condiciones ambientales actuales. Esto permite que TPG escale

a complejo, entornos de tareas de alta dimensión manteniendo un nivel relativamente

Bajo coste computacional por decisión..

2. Los programas de cada equipo indexarán colectivamente una pequeña, subconjunto único de la

espacio de estados. A medida que surgen gráficos de políticas de varios equipos, sólo regiones específicas del estado

1El código fuente está disponible en https://web.cs.dal.ca/∼mheywood/Code/index.html

348

Volumen de cálculo evolutivo 26, Número 3

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

/

mi

d

tu

mi

v

C

oh

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

2

6

3

3

4

7

1

5

5

2

3

7

5

mi

v

C

oh

_

a

_

0

0

2

3

2

pag

d

/

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

Aprendizaje por refuerzo emergente multitarea de alta dimensión

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

/

mi

d

tu

mi

v

C

oh

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

2

6

3

3

4

7

1

5

5

2

3

7

5

mi

v

C

oh

_

a

_

0

0

2

3

2

pag

d

/

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

Cifra 1: Políticas de GTP. Toma de decisiones en cada paso del tiempo. (marco) comienza en la raíz

equipo (nodo negro) y sigue la ventaja con la oferta del programa ganador (producción) hasta un

acción atómica (Posición del joystick Atari) se alcanza. La población inicial contiene sólo

políticas de un solo equipo (a). Los gráficos multiequipo surgen a medida que avanza la evolución. (b).

Los espacios que son importantes para la toma de decisiones serán indexados por el gráfico como un

entero. De este modo, La modularidad emergente permite que la política se descomponga simultáneamente.-

Plantear la tarea espacial y conductualmente., detectando regiones importantes del estado

espacio y optimizar las decisiones tomadas en diferentes regiones. Esto minimiza

el requisito de características específicas de la tarea de elaboración a priori, y deja que TGP realice

tanto la construcción de características como el descubrimiento de políticas simultáneamente.

A diferencia del aprendizaje profundo, El marco TPG propuesto adopta una perspectiva explícitamente emergente.,

enfoque de desarrollo para la identificación de políticas. Nuestro interés es si podemos con-

estructurar topologías de gráficos de políticas “de abajo hacia arriba” que coincidan con la calidad del aprendizaje profundo para que-

luciones sin la correspondiente complejidad. Específicamente, El aprendizaje profundo supone que

La arquitectura neuronal está diseñada a priori., con la misma arquitectura empleada para

cada título de juego. De este modo, El aprendizaje profundo siempre realiza millones de cálculos por deci.-

sión. TPG, por otro lado, tiene el potencial de ajustar la complejidad de las políticas a cada tarea

Volumen de cálculo evolutivo 26, Número 3

349

S. kelly y m. I. heywood

ambiente, o título del juego, requiriendo solo ≈ 1000 cálculos por decisión en la mayoría

caso complejo, y ≈ 100 cálculos en los casos más simples.

En breve, El objetivo de este trabajo es demostrar que soluciones mucho más simples pueden

ser descubierto a la dinámica, de alta dimensión, y ambientes parcialmente observables en

RL sin tomar decisiones previas sobre la complejidad del modelo.. Como consecuencia,

los costos computacionales típicamente asociados con el aprendizaje profundo se evitan sin im-

Pactar sobre la calidad de las políticas resultantes., eso es, El costo de la capacitación y el despliegue.

una solución ahora es mucho menor. Las soluciones funcionan en tiempo real sin recurrir a

plataformas de hardware multinúcleo o GPU, simplificando así potencialmente el desarrollo-

gastos generales de cuenta/despliegue al plantear soluciones a tareas desafiantes de RL.

En relación con nuestro trabajo anterior, nosotros: (1) ampliar la comparación de título único de 20 títulos

con dos algoritmos comparadores (kelly y heywood, 2017a) para incluir todos 49 Atari

títulos de juegos y ocho algoritmos comparadores (Sección 5); y (2) demostrar que mul-

El rendimiento de la tarea se puede ampliar desde 3 al menos 5 títulos de juegos por política y, a diferencia de

el trabajo anterior, no requiere una formulación objetiva de Pareto (kelly y oye-

madera, 2017a), solo elitismo (Sección 7).

2 Fondo

2.1

Entorno de tareas

El entorno de aprendizaje arcade (PERO) (Bellamare, Naddaf et al., 2012) es un atari

2600 Emulador de videojuegos diseñado específicamente para comparar algoritmos RL. El ALE

permite a los agentes de RL interactuar con cientos de videojuegos clásicos usando los mismos en-

Interfaz experimentada por jugadores humanos.. Eso es, un agente de RL se limita a interactuar

con el juego usando el estado, (cid:2)s(t ), como lo define la pantalla del juego, y 18 discreto (atómico)

comportamiento, eso es, el conjunto de instrucciones de paletas de la consola Atari que incluyen "sin acción," en com-

combinación con/sin botón de disparo. Cada pantalla de juego está definida por un 210 × 160 píxel

matriz con 128 colores potenciales por píxel, actualizado a una velocidad de fotogramas de 60 Hz. en la práctica-

tice, Los marcos de pantalla sin procesar se preprocesan antes de ser presentados a un agente de RL.

(mira la sección 2.2 para un resumen de los enfoques adoptados hasta la fecha, y Sección 4.1 para el

enfoque específico asumido en este trabajo).

Curiosamente, Las entidades importantes del juego a menudo aparecen de forma intermitente en secuencias.

marcos, creando un parpadeo visible en la pantalla. Esta es una técnica común que utilizan los diseñadores de juegos.

para solucionar las limitaciones de memoria en el hardware original de Atari. Sin embargo, se presenta

un desafío para RL porque implica que los entornos de juego de Atari son parcialmente observados.-

capaz. Es decir, un solo cuadro rara vez representa el estado completo del juego.

Además, los agentes se saltan estocásticamente los fotogramas de la pantalla con una probabilidad p = 0.25, con

la acción anterior se repite en fotogramas omitidos (Bellamare, Naddaf et al., 2012;

Hausknecht y la piedra, 2015). Esta es una configuración predeterminada en ALE, y tiene como objetivo limitar

agentes a aproximadamente el mismo tiempo de reacción que un jugador humano, además de introducir un

fuente adicional de estocasticidad. Un solo episodio de juego dura un máximo de 18,000

marcos, sin incluir fotogramas omitidos.

2.2 RL bajo Tareas ALE

Históricamente, Los enfoques de RL se han basado en representantes estatales específicos de tareas diseñadas a priori.-

resentaciones (atributos). Esto cambió con la introducción de Deep Q-Network.

(DQN) (Mnih et al., 2015). DQN emplea un archivo de red neuronal convolucional profunda-

Tecnología para codificar una representación directamente desde la captura de pantalla. (por lo tanto, un representante de tarea específica-

resentimiento). A partir de esta representación se entrena simultáneamente un perceptrón multicapa.

350

Volumen de cálculo evolutivo 26, Número 3

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

/

mi

d

tu

mi

v

C

oh

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

2

6

3

3

4

7

1

5

5

2

3

7

5

mi

v

C

oh

_

a

_

0

0

2

3

2

pag

d

/

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

Aprendizaje por refuerzo emergente multitarea de alta dimensión

estimar una función de valor (el selector de acciones) a través del Q-learning. Preproceso de imagen-

Todavía era necesario y tomó la forma de muestreo descendente del original. 210 × 160 RGB

datos del marco a 84 × 84 y extrayendo el canal de luminancia. Además, un deslizamiento temporal-

Se asumió una ventana de configuración en la que la entrada a la primera capa de convolución era en realidad

una secuencia de los cuatro fotogramas que aparecen más recientemente. Esto redujo la observación parcial-

capacidad de la tarea, ya que todo el estado del juego ahora debería ser visible.

Al asumir Q-learning, DQN es un método fuera de política, por cual uno de los más

Los elementos críticos son el soporte para la memoria de repetición.. Tal como, el rendimiento podría verse afectado-

sitivo al contenido específico de esta memoria (los “recuerdos” que se reproducen son aleatorios

muestreado). La arquitectura general del aprendizaje por refuerzo (Gorila) extendió la aplicación-

Enfoque de DQN con una infraestructura distribuida masivamente paralela. (100s de GPU) a

Apoyar el desarrollo simultáneo de múltiples estudiantes de DQN. (Nair et al., 2015).

Las contribuciones de los estudiantes distribuidos actualizan periódicamente un “parámetro” central.-

ter server” que en última instancia representa la solución. Gorila tuvo un mejor desempeño que DQN

en la mayoría de los títulos de juegos, pero no en todos los casos, lo que indica que posiblemente todavía haya sensibilidad-

idades para reproducir el contenido de la memoria.

También se sabe que el Q-learning puede dar como resultado valores de acción que son excesivamente

alto. Recientemente se demostró que tales “sobreestimaciones” estaban asociadas con imprecisiones en

los valores de acción, donde es probable que esto sea la norma durante las etapas iniciales de la formación

(van Hasselt et al., 2016). La solución propuesta por van Hasselt et al.. (2016) para dirección-

Para solucionar este problema se introdujeron dos conjuntos de pesos., uno para la selección de acciones y otro para

evaluación de políticas. Esto fue diseñado en la arquitectura DQN asociando el

dos roles con la red en línea de DQN y la red de destino respectivamente.2 El resultado

El marco de doble DQN mejoró los resultados de DQN originales durante más de la mitad de los casos.

el 49 títulos de juegos de la tarea ALE.

Más recientemente, métodos de política (p.ej., vendaje) han aparecido en los que múltiples en-

Las políticas dependientes se entrenan en paralelo. (Mnih et al., 2016). La experiencia de cada agente de

el entorno es totalmente independiente (No se hace ningún intento de hacer cumplir la centralización.-

ción de memoria/experiencia). Esto significa que el conjunto de agentes de RL experimenta colectivamente-

ence una gama más amplia de estados. La evaluación resultante bajo la tarea Atari demostró

reducciones significativas de los requisitos computacionales3 y mejores estrategias de agentes. Eso

dicho, en todos los casos, La arquitectura de aprendizaje profundo se especifica a priori y está sujeta a controles previos.

ajuste de parámetros en un subconjunto de títulos de juegos.

La neuroevolución representa una de las técnicas más investigadas dentro

El contexto del descubrimiento de agentes para juegos.. Hausknecht y otros. (2014) realizó una com-

comparación de diferentes marcos neuroevolutivos bajo dos representaciones estatales:

Objetos específicos del título del juego versus captura de pantalla.. El preprocesamiento para la captura de pantalla tomó

la forma de muestreo del original 210 × 160 Datos de cuadro RGB para producir ocho

“sustratos” de dimensión 16 × 21 = 336; cada sustrato correspondiente a uno de los

ocho colores presentes en una representación SECAM (proporcionada por la ALE). si el color

está presente en los datos del marco original, aparece en un nodo de sustrato correspondiente.

Hausknecht y otros. (2014) comparado Hyper-NEAT, LIMPIO, y dos esquemas más simples para

Redes neuronales en evolución bajo el conjunto de títulos de juegos de Atari.. Hyper-NEAT proporciona

un enfoque de desarrollo para describir grandes arquitecturas de redes neuronales de manera eficiente,

mientras que NEAT proporciona un esquema para descubrir topologías neuronales arbitrarias, así como

2La red “en línea” en DQN mantiene la copia maestra del MLP, mientras que la red objetivo

se actualiza durante la “repetición de la experiencia” (Mnih et al., 2015).

3Una CPU de 16 núcleos en lugar de una GPU.

Volumen de cálculo evolutivo 26, Número 3

351

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

/

mi

d

tu

mi

v

C

oh

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

2

6

3

3

4

7

1

5

5

2

3

7

5

mi

v

C

oh

_

a

_

0

0

2

3

2

pag

d

/

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

S. kelly y m. I. heywood

valores de peso, comenzando con una sola neurona completamente conectada. NEAT fue más efectivo-

fectivo bajo la representación de objetos de baja dimensión, mientras que Hyper-NEAT era

preferible para la representación del sustrato.

Finalmente, Liang et al.. (2016) revisar el diseño de información de estado específica de la tarea utilizando

una hipótesis sobre la acción de la neurona convolucional en el aprendizaje profundo. Esta re-

resultado en un espacio de estados en el orden de 110 millones de atributos cuando se aplican a la pantalla de Atari

captura, pero toma de decisiones simplificada a un modelo lineal. De este modo, un agente de RL podría ser

identificado utilizando el método de Diferencia Temporal sobre póliza de Sarsa. En comparación con

aprendizaje profundo, Los requisitos computacionales para el entrenamiento y el despliegue están limitados.-

considerablemente más bajo, pero los modelos producidos son tan buenos como la capacidad de diseñar

atributos apropiados.

2.3 RL multitarea bajo ALE

Los enfoques revisados en la Sección 2.2 se asumió que se entrenó una sola política de RL

en cada título de juego. En cambio, RL multitarea (MTL) intenta llevar esto más lejos y

Desarrollar un único agente de RL que pueda jugar múltiples títulos de juegos.. Tal como, MTRL es un

paso hacia la “inteligencia general artificial”,” y representa una tarea mucho más difícil

por al menos dos razones: (1) Los agentes de RL no deben “olvidar” ninguna de sus políticas para jugar un

juego anterior mientras aprende una política para jugar un juego nuevo, y (2) durante la prueba, un

El agente de RL debe poder distinguir entre títulos de juegos sin recurrir a información adicional.

información del estado.

Hasta la fecha, Se han propuesto dos enfoques de aprendizaje profundo para esta tarea.. parisotto

et al. (2015) Primero aprende cada título de juego de forma independiente y luego úsalo para entrenar a un solo jugador.

arquitectura para jugar múltiples títulos. Más recientemente Kirkpatrick et al.. (2016) propuesto

una modificación de Double DQN en la que subconjuntos de pesos (particularmente en el MLP)

están asociados con diferentes tareas y sujetos a tasas de aprendizaje más bajas que las ponderaciones no

ya asociado con tareas previamente aprendidas. Pudieron aprender a jugar.

a 6 títulos de juegos a un nivel comparable con el DQN original (capacitado en cada título en-

dependiente), aunque cuando los títulos de los juegos se seleccionan del conjunto de juegos para los cuales

Se sabía que DQN tenía un buen desempeño en.

3 Gráficos de programas enredados

La descomposición modular de tareas a través de la formación de equipos ha sido un tema recurrente en ge.-

programación magnética. Estudios anteriores examinaron métodos para combinar la contribución.-

ción de miembros individuales del equipo (Brameier y Banzhaf, 2001), isla haciendo cumplir

models (Imamura et al., 2003), o intercambiar selecciones de equipo versus individuales-

ción (Thomason y Soule, 2007). Una limitación común de tales planes era la exigencia-

ment para preespecificar el número de programas que aparecen dentro de un equipo. Además, incluso

cuando el complemento del equipo evoluciona de forma abierta, anteriormente ha sido necesario-

Es necesario definir el fitness tanto a nivel del programa individual como del equipo. (p.ej., Wu y

Banzhaf, 2011). Es necesario abordar estas limitaciones para facilitar por completo

Enfoques abiertos a la evolución..

3.1

Equipos de programas en evolución

Permitir la evolución del número y complemento de programas por equipo en un

La manera abierta se abordó anteriormente en parte mediante el uso de una metáfora de licitación.

(Lichodzijewski y Heywood, 2008a), en cuyo caso los programas representan acción, a, y

contexto, pag, independientemente. Eso es, cada programa define el contexto para un solo discreto

acción, o un ∈ {A} donde A denota el conjunto de acciones atómicas específicas de la tarea. Las acciones son

352

Volumen de cálculo evolutivo 26, Número 3

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

/

mi

d

tu

mi

v

C

oh

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

2

6

3

3

4

7

1

5

5

2

3

7

5

mi

v

C

oh

_

a

_

0

0

2

3

2

pag

d

/

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

Aprendizaje por refuerzo emergente multitarea de alta dimensión

asignado al programa en la inicialización y potencialmente modificado por variación oper-

Agentes durante la evolución.. Se supone una representación lineal del programa4 en la que un reg-

El lenguaje de transferencia de nivel superior admite la 4 operadores aritméticos, coseno, logarítmico,

la operación exponencial, y una declaración condicional (ver algoritmo 1). el lineal

la representación facilita omitir el código "intrón", donde esto puede potencialmente representar

60–70% de las instrucciones del programa (Brameier y Banzhaf, 2007). Naturalmente, determinando

cuáles de las variables de estado disponibles se utilizan realmente en el programa, así como el

Número de instrucciones y sus operaciones., son ambas propiedades emergentes de la evolución-

proceso cionario. Después de la ejecución, registrar R[0] representa la “oferta” o “confianza” por

la acción del programa, a, en relación con el estado observado actualmente, (cid:2)s(t ). Un equipo mapea cada

observación del estado, (cid:2)s(t ), a una sola acción ejecutando a todos los miembros del equipo (programas) rel-

activo a (cid:2)s(t ), y luego elegir la acción del mejor postor. Si los programas no fueran

organizado en equipos, en cuyo caso todos los programas dentro de la misma población

competir por el derecho a sugerir su acción, es muy probable que ese individuo degenerado-

como (programas que ofrecen altas ofertas para cada estado), interrumpiría la licitación que de otro modo sería efectiva

estrategias.

La creación adaptativa de equipos de programas se aborda aquí mediante el uso de un

Relación simbiótica entre una población de equipo y una población de programa.; lo sucesivo

“EquipoGP” (Lichodzijewski y Heywood, 2008b). Cada individuo de la población del equipo.-

La ción representa un índice para algún subconjunto de la población del programa. (ver Figura 2a). Equipo

Por lo tanto, los individuos asumen una representación de longitud variable en la que cada individuo

se inicializa estocásticamente con [2, . . . , Vaya] punteros a programas desde el pop del programa-

ulación. La única restricción es que debe haber al menos dos acciones diferentes indexadas.

por el complemento de programas dentro de un mismo equipo. Puede aparecer el mismo programa

en varios equipos, pero debe aparecer en al menos un equipo para sobrevivir entre partidos consecutivos.

generaciones.

Actuación (es decir., aptitud física) se expresa sólo a nivel de equipos, y toma la forma

del objetivo dependiente de la tarea(s). Después de evaluar el desempeño de todos los equipos., el

Los peores equipos de Rgap se eliminan de la población de equipos.. Después de la eliminación del equipo, cualquier profesional-

El programa que no puede ser indexado por ningún equipo debe haber estado asociado con el peor

equipos de actuación, por lo tanto también se elimina. Esto evita la necesidad de tomar decisiones arbitrarias.-

Sesiones con respecto a la definición de condición física a nivel de equipo versus nivel de programa. (que genero-

aliado tomar la forma de heurísticas específicas de la tarea, limitando así la aplicabilidad del modelo

4Se podría emplear cualquier representación de médico de cabecera.; La innovación importante es que el contexto y la acción son

representado independientemente.

Volumen de cálculo evolutivo 26, Número 3

353

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

/

mi

d

tu

mi

v

C

oh

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

2

6

3

3

4

7

1

5

5

2

3

7

5

mi

v

C

oh

_

a

_

0

0

2

3

2

pag

d

.

/

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

S. kelly y m. I. heywood

Cifra 2: Subtrama (a) Ilustración de la relación simbiótica entre equipo y programa.

poblaciones. La aptitud para la tarea sólo se expresa a nivel de equipo.. Cada equipo define

un conjunto único de indicadores para algún subconjunto de individuos de la población del programa.

Varios programas pueden tener la misma acción., ya que el contexto asociado para la acción es

definido por el programa. Los equipos legales deben probar al menos dos acciones diferentes.. Subtrama

(b) La acción atómica mutó en un índice para un equipo.. Ahora hay un equipo raíz menos en

la población del equipo.

a dominios de aplicación específicos). Tras la eliminación de los peores equipos, nuevos equipos

se introducen por muestreo, clonación, y modificando los equipos supervivientes de Rgap. Naturalmente, si

Hay un beneficio de rendimiento en equipos más pequeños o más grandes y/o en diferentes programas.-

complementos, Esto se reflejará en los complementos del programa del equipo superviviente. (Lichodzi-

jewski y heywood, 2010), eso es, La complejidad del programa de equipo es un rasgo del desarrollo..

3.2

Gráficos en evolución de equipos

La evolución comienza con una población de programas en la que las acciones del programa se limitan a

tarea específica (atómico) comportamiento (Figuras 1a y 2a). Para prever la evolución

de código organizado jerárquicamente bajo un proceso de evolución completamente abierto

(es decir., modularidad conductual emergente), Los operadores de variación del programa pueden

introducir acciones que indexen a otros equipos dentro de la población del equipo. para hacerlo, cuando un

Se modifica la acción del programa., tiene una probabilidad (patomico) de hacer referencia a un diferente

acción atómica u otro equipo. De este modo, Los operadores de variación tienen la capacidad de aumentar

construir gráficos de políticas de varios equipos (Figuras 1b y 2b).

Cada vértice del gráfico es un equipo., mientras cada miembro del equipo, o programa, representar-

envía una ventaja saliente que conduce a otro equipo o a una acción atómica. Decisión-

La elaboración de un gráfico de políticas comienza en el equipo raíz., donde cada programa en el equipo

producir una oferta relativa al estado actual, (cid:2)s(t ). El recorrido del gráfico luego sigue el pro-

gramo/borde con la oferta más grande, repetir el proceso de licitación por el mismo (cid:2)s(t ) en cada

equipo/vértice a lo largo del camino hasta que se encuentre una acción atómica. De este modo, dado algunos

estado del medio ambiente en el paso de tiempo t, el gráfico de políticas calcula una ruta desde la raíz hasta

acción atómica, donde solo un subconjunto de programas en el gráfico (es decir., aquellos en equipos a lo largo

el camino) requerir ejecución. Algoritmo 2 detalla el proceso de evaluación del TPG indi-

individuales, que se repite en cada fotograma, (cid:2)s(t ), hasta que se encuentre un estado de fin de juego

y se puede determinar la idoneidad para el gráfico de políticas.

A medida que surgen gráficos de políticas de varios equipos, una red de conectividad cada vez más enredada

se desarrolla entre el equipo y las poblaciones del programa.. El número de soluciones únicas.,

o gráficos de políticas, en cualquier generación dada es igual al número de nodos raíz (es decir., equipos

354

Volumen de cálculo evolutivo 26, Número 3

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

/

mi

d

tu

mi

v

C

oh

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

2

6

3

3

4

7

1

5

5

2

3

7

5

mi

v

C

oh

_

a

_

0

0

2

3

2

pag

d

/

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

Aprendizaje por refuerzo emergente multitarea de alta dimensión

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

/

mi

d

tu

mi

v

C

oh

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

2

6

3

3

4

7

1

5

5

2

3

7

5

mi

v

C

oh

_

a

_

0

0

2

3

2

pag

d

/

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

que no están referenciados como acción de ningún programa) en la población del equipo. Sólo estas raíces

Los equipos son candidatos para que se evalúe su condición física., y están sujetos a modificación por

los operadores de variación.

En cada generación, La brecha de los equipos raíz se elimina y se reemplaza por la descendencia de

las raíces sobrevivientes. El proceso para generar descendencia en equipo toma muestras y

clona un equipo raíz, luego aplica operadores de variación basados en mutaciones al equipo clonado

que eliminar, agregar, y mutar algunos de sus programas.

El proceso de generación del equipo introduce nuevos nodos raíz hasta que el número de raíces

en la población alcanza Rsize. El número total de pasos de muestreo para generar-

la primavera fluctúa, como equipos raíz (junto con el gráfico de política inferior) a veces son “sub-

asumido” por un nuevo equipo. En cambio, Los gráficos se pueden separar., Por ejemplo, a través de

mutación de acción del programa, dando como resultado nuevos nodos/políticas raíz. Esto implica que después

inicialización, El tamaño de la población tanto del equipo como del programa varía. Además, mientras que la

El número de equipos raíz permanece fijo., el número de equipos que se “archivan” como

nodos internos (es decir., una biblioteca de código reutilizable) fluctúa.

Evaluación limitante, selección, y la variación a equipos raíz solo tiene dos beneficios críticos-

beneficios: (1) El costo de la evaluación y el tamaño del espacio de búsqueda siguen siendo bajos porque sólo

una fracción de la población del equipo (equipos raíz) representan políticas únicas para ser evaluadas

y modificado en cada generación y (2) ya que solo se eliminan los equipos raíz, introducido,

o modificado, Los gráficos de políticas se desarrollan incrementalmente desde abajo hacia arriba.. Tal como,

Las estructuras complejas de nivel inferior dentro de un gráfico de políticas están protegidas siempre que concuerden.-

homenaje a una política global fuerte.

En resumen, el marco de trabajo en equipo de GP de Lichodzijewski y Heywood (2010) es

Ampliado para permitir que surjan gráficos de políticas., definir la interrelación entre equipos.

Como los programas que componen un equipo suelen indexar diferentes subconjuntos del espacio de estados (es decir.,

Volumen de cálculo evolutivo 26, Número 3

355

S. kelly y m. I. heywood

la pantalla en el caso de ALE), el gráfico de políticas resultante se adaptará progresivamente, en-

definir más o menos el espacio estatal y definir los tipos de decisiones tomadas en diferentes-

regiones entrantes. Finalmente, Kelly y otros. (2018) proporcionar un resumen pictórico adicional de la

algoritmo TPG.

3.2.1 Prueba de neutralidad

Cuando los operadores de variación introducen cambios en un programa, no hay garantía de que

el cambio será: (1) resultar en un cambio de comportamiento, y (2) incluso si un cambio de comportamiento

resultados, Será único en relación con el conjunto actual de programas.. Punto 1 sigue siendo útil como

da como resultado la posibilidad de que se realicen múltiples cambios de código de forma incremental antes

ellos aparecen, o redes neutrales (Brameier y Banzhaf, 2007). Sin embargo, esto también puede

resultan en ciclos de evaluación desperdiciados porque no hay diferencia funcional en relación con

el padre. Dado que la evaluación de la condición física es costosa, Por lo tanto, probamos el comportamiento.

unicidad. Específicamente, 50 de las observaciones estatales más recientes se conservan en un formato global

archivo, o (cid:2)s(t ) ∈ {último − 49, . . . , último }. Cuando se modifica un programa o se crea un programa nuevo

creado, su oferta para cada estado en el archivo se compara con la oferta de cada programa

en la población actual. Mientras todos 50 Los valores de oferta del nuevo programa no son

dentro de τ de todas las ofertas de cualquier otro programa en la población actual, el nuevo programa

es aceptado. Si el nuevo programa no pasa la prueba, luego se muta otra instrucción y el

prueba repetida. Observamos que tal proceso tiene similitudes con la motivación de la novedad.

buscar (Lehman y Stanley, 2011), eso es, una prueba para diferentes resultados. Sin embargo, como esto

El proceso aparece en un programa., no hay garantía de que esto resulte en una novela

Comportamiento cuando aparece en un equipo y sigue siendo apto a nivel de equipo/agentes.

eso determina la supervivencia.

4

Metodología experimental

Para fines comparativos, La evaluación de TPG asumirá el mismo enfoque general.

según lo establecido en la evaluación DQN original (Mnih et al., 2015). De este modo, asumimos el

mismo subconjunto de 49 Títulos de juegos de Atari y, post entrenamiento, prueba el agente campeón de TPG

bajo 30 episodios de prueba inicializados con un número seleccionado estocásticamente de no operativos iniciales

comportamiento (descrito en la Sección 5.1). Esto nos proporcionará la más amplia gama de anteriores.

resultados con fines comparativos.5 Se realizan cinco carreras de TPG independientes por juego

título, donde esto parece reflejar la práctica más reciente para obtener resultados de aprendizaje profundo.6

Se utilizó la misma parametrización para TPG para todos los juegos. (Sección 4.2). El único

La información proporcionada a los agentes fue el número de acciones atómicas disponibles para cada uno.

juego, el marco de pantalla preprocesado durante el juego (Sección 4.1), y el resultado final del juego.

Cada gráfico de políticas fue evaluado en 5 episodios de juegos por generación, hasta un máximo

de 10 episodios de juego por vida. La aptitud para cada gráfico de políticas es simplemente el promedio

puntuación del juego en todos los episodios. Se identificó una política de campeón único para cada juego como

el que tiene la mayor recompensa de entrenamiento al final de la evolución.

4.1

Captura de pantalla del espacio de estado

Basado en la observación de que la entrada visual tiene mucha información redundante (es decir.,

El contenido visual del juego está diseñado para maximizar el valor del entretenimiento., en contraposición a un

5También ha aparecido un escenario de prueba alternativo en el que el agente RL asume el control del estado del juego.

identificado por un jugador humano en un intento de introducir mayor diversidad en el estado de inicio del agente RL

selección (Nair et al., 2015; Mnih et al., 2016).

6Los resultados originales de DQN solo reflejaron una ejecución por título. (Mnih et al., 2015).

356

Volumen de cálculo evolutivo 26, Número 3

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

/

mi

d

tu

mi

v

C

oh

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

2

6

3

3

4

7

1

5

5

2

3

7

5

mi

v

C

oh

_

a

_

0

0

2

3

2

pag

d

/

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

Aprendizaje por refuerzo emergente multitarea de alta dimensión

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

/

mi

d

tu

mi

v

C

oh

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

2

6

3

3

4

7

1

5

5

2

3

7

5

mi

v

C

oh

_

a

_

0

0

2

3

2

pag

d

.

/

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

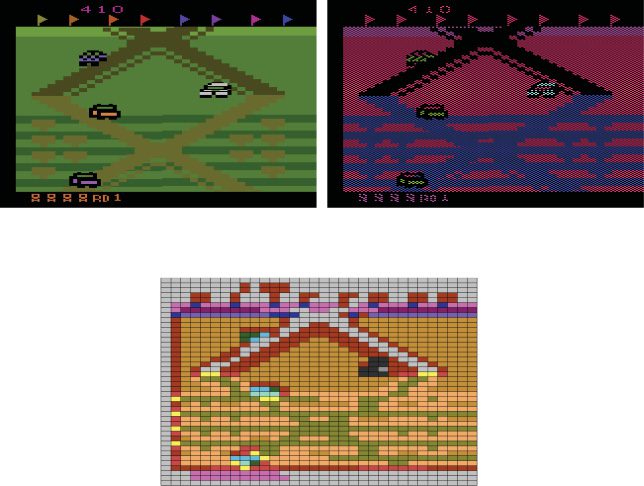

Cifra 3: Pasos de cuantificación de pantalla, reduciendo la matriz de píxeles de Atari sin procesar (a) a 1344 dic-

variables de estado imales (C) utilizando un esquema de submuestreo cuadriculado (b).

Necesidad de transmitir contenido con una cantidad mínima de información.), adoptamos una cuantificación

enfoque para el preprocesamiento. El siguiente procedimiento de dos pasos se aplica a cada juego.

marco:

1. Se utiliza una máscara de patrón a cuadros para muestrear 50% de los píxeles del juego raw

pantalla (ver Figura 3b). Cada píxel restante asume el SECAM de 8 colores.-

codificación. ALE proporciona la codificación SECAM como alternativa a la codificación de-

fallo Formato NTSC de 128 colores. saltando uniformemente 50% de los píxeles de la pantalla sin procesar

mejora la velocidad de recuperación de funciones y tiene un efecto mínimo en la fi-

representación final, ya que las entidades importantes del juego suelen ser más grandes que una sola

píxel.

2. El marco se subdivide en un 42 × 32 grid.7 Cada mosaico de la cuadrícula se describe mediante un pecado-

byte gle, en el que cada bit codifica la presencia de uno de los ocho colores SECAM

dentro de ese azulejo. La representación de pantalla cuantificada final incluye cada byte de mosaico.

como valor decimal, definiendo así un espacio de estados estatales (cid:2)s(t ) de 42 × 32 = 1,344 decimal

características en el rango de 0 a 255, visualizado en la Figura 3c para el juego Up 'N Down

en el paso del tiempo (marco) t.

Esta representación del estado está inspirada en el método básico definido en Bellemare., Limpiar

et al. (2012). Nota, sin embargo, que este método no utiliza detección de fondo a priori

o combinaciones de características por pares.

7Implica que el original 210 × 160 La pantalla está dividida por 5.

Volumen de cálculo evolutivo 26, Número 3

357

S. kelly y m. I. heywood

En comparación con el enfoque DQN (Mnih et al., 2015; Nair et al., 2015), ningún intento

está hecho para diseñar las propiedades parcialmente observables del contenido del juego. (ver discusión

de Sección 2.2). Además, Las tres capas de convolución de la arquitectura de aprendizaje profundo.

Los filtros reducen el muestreo. 84 × 84 = 7,056 espacio de píxeles a una dimensión de 3,136

antes de aplicar un perceptrón multicapa completamente conectado (MLP).8 es la combinacion

de capa convolucional y MLP que representa el costo computacional del aprendizaje profundo.

Naturalmente, esto imparte un costo computacional fijo de aprendizaje ya que todo el archivo DQN-

La tecnología se especifica a priori. (Sección 6.3).

A diferencia de, TPG desarrolla un agente de toma de decisiones desde un 1,344 espacio dimensional.

En común con el enfoque DQN, no se realiza ninguna extracción de características como parte del

paso de preprocesamiento, sólo una cuantificación de los datos del cuadro original. Implícito en esto hay una

Suposición de que el espacio de estados es altamente redundante.. Por lo tanto, TPG percibe el estado

espacio, (cid:2)s(t ) (Figura 3c), como memoria de solo lectura. Cada programa TPG define entonces un po-

subconjunto potencialmente único de entradas de (cid:2)s(t ) para incorporarlos en su toma de decisiones

proceso. Luego se requieren las propiedades emergentes de TPG para desarrollar la complejidad de

una solución, o gráfico de políticas, con programas organizados en equipos y equipos en gráficos.

De este modo, en lugar de asumir que todo el contenido de la pantalla contribuye a la toma de decisiones, el

El enfoque adoptado por TPG es submuestrear de forma adaptativa desde el espacio de imagen cuantificado..

El subconjunto específico de variables de estado muestreadas dentro de cada política de agente es una

propiedad, Se descubre únicamente a través de la interacción con el entorno de la tarea.. lo implícito-

cationes de asumir un enfoque tan explícitamente emergente sobre el costo computacional

ser revisado en la Sección 6.3.

4.2

Parametrización de TPG

La implementación de algoritmos basados en la población puede resultar costosa debido a la cantidad de

Parámetros e interrelación entre diferentes parámetros.. En este trabajo, ningún intento

Se ha realizado para optimizar la parametrización. (ver tabla 1); en lugar de eso, trasladamos un

parametrización básica a partir de la experiencia con equipos individuales en evolución bajo una supervisión

tarea de aprendizaje (Lichodzijewski y Heywood, 2010).

Se enumeran tres categorías básicas de parámetros.: Prueba de neutralidad (Sección 3.2.1), Equipo

población, y población del programa (Cifra 2). En el caso de la población del Equipo, el

Las decisiones sobre parámetros más importantes son el tamaño de la población. (cuantos equipos al mismo tiempo

apoyo), y cuántas soluciones candidatas reemplazar en cada generación (Rgap). El

parámetros que controlan la aplicación de los operadores de variación comunes a los anteriores en-

posturas del TeamGP (pmd , pma, pmm, pmn) asumir también los valores utilizados bajo supervisión

tareas de aprendizaje (Lichodzijewski y Heywood, 2010). En cambio, patomico representa un

parámetro específico de TPG, donde esto define la probabilidad relativa de mutar una acción

a una acción atómica versus un puntero a un equipo (Sección 3.2).

Asimismo, los parámetros que controlan las propiedades de la población del programa como-

Sume los valores utilizados para TeamGP aplicados a las tareas de aprendizaje supervisadas para todos excepto

maxP rogTamaño. En esencia, esto se ha incrementado hasta el punto en que es poco probable que sea

encontrado durante la evolución. El título del algoritmo 1 resume la instrucción

conjunto y representación adoptados para los programas.

El límite computacional para TPG se define en términos de un recurso computacional

restricción de tiempo. De este modo, Los experimentos se ejecutaron en un clúster compartido con un tiempo de ejecución máximo.

de 2 semanas por título de juego. The nature of some games allowed for >800 generations,

8Para ver un tutorial sobre cómo estimar el tamaño de los filtros en arquitecturas de aprendizaje profundo, consulte http://cs231n

.github.io/convolutional-networks/

358

Volumen de cálculo evolutivo 26, Número 3

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

/

mi

d

tu

mi

v

C

oh

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

2

6

3

3

4

7

1

5

5

2

3

7

5

mi

v

C

oh

_

a

_

0

0

2

3

2

pag

d

.

/

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

Aprendizaje por refuerzo emergente multitarea de alta dimensión

Mesa 1: Parametrización de TPG.

Prueba de neutralidad (Sección 3.2.1)

Número de muestras históricas en prueba de diversidad.

Umbral para la unicidad de la oferta (t )

Población del equipo

Número de (raíz) equipos en la población inicial (tamaño R)

Número de nodos raíz que se pueden reemplazar por generación (Rgap)

Probabilidad de eliminar o agregar un programa (pmd , pma)

máx.. tamaño inicial del equipo (Vaya)

problema. de crear un nuevo programa (pmm)

problema. de cambiar una acción del programa (pmn)

problema. de definir una acción como un equipo o acción atómica (patomico)

Población del programa

Número total de registros por programa (numRegistros)

máx.. Número de instrucciones que puede tomar un programa. (maxProgSize)

problema. de eliminar o agregar una instrucción dentro de un programa (borrar, paddock )

problema. de mutar una instrucción dentro de un programa (pmutado)

problema. de intercambiar un par de instrucciones dentro de un programa (pswap)

50

10−4

360

50%

0.7

5

0.2

0.1

0.5

8

96

0.5

1.0

1.0

mientras que otros limitaron la evolución a unos pocos cientos. No se hizo ningún intento de paralelizar

ejecución dentro de cada ejecución (es decir., la base del código TPG se ejecuta como un solo hilo), el clus-

ter simplemente permitió que cada ejecución se hiciera simultáneamente. De paso, los resultados de DQN

se requieren entre 12 y 14 días por título de juego en una plataforma informática GPU (Nair et al., 2015).

5

Aprendizaje de una sola tarea

Esta sección documenta la capacidad del TPG para construir políticas de toma de decisiones en el ALE desde

la perspectiva de la IA independiente del dominio, eso es, descubrir políticas para una variedad de

Entornos de juego ALE sin ajuste de parámetros específicos de tareas. Antes de presentar de-

resultados de cola, Proporcionamos una descripción general del rendimiento del entrenamiento para TPG en el conjunto de

49 Títulos ALE comunes a la mayoría de los estudios de evaluación comparativa. (Sección 2.2). Cifra 4 ilustra

rendimiento medio del entrenamiento TPG (a través del 5 carreras por título de juego) como relación normalizada-

Ativo al puntaje de la prueba DQN. (100%) y juego aleatorio (0%) (Mnih et al., 2015). el azar

El agente simplemente selecciona acciones con probabilidad uniforme en cada marco del juego.9 Bajo prueba

condiciones, TPG supera puntuación de DQN en 27 juegos (Figura 4a), mientras que DQN mantiene el

puntuación más alta en 21 juegos (Figura 4b). De este modo, TPG y DQN son ampliamente comparables desde

una perspectiva de rendimiento, cada uno igualando/venciendo al otro en un subconjunto del entorno del juego-

ambientes. En efecto, no hay diferencia estadística entre los puntajes de las pruebas TPG y DQN

en general 49 juegos (Sección 5.1). Sin embargo, TPG produce soluciones mucho más simples en todos

casos, en gran parte debido a su representación modular emergente, que escala automáticamente

a través de la interacción con el entorno de la tarea. Es decir, simultáneamente con el aprendizaje de

9La puntuación normalizada se calcula como 100 × (Puntuación TPG: puntuación de juego aleatorio)/(Puntuación DQN: aleatoria

jugar puntuación). La normalización de puntuaciones permite trazar el progreso de TPG en relación con múltiples juegos.

juntos independientemente del esquema de puntuación en diferentes juegos, y facilita hacer una comparación directa

con DQN.

Volumen de cálculo evolutivo 26, Número 3

359

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

/

mi

d

tu

mi

v

C

oh

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

2

6

3

3

4

7

1

5

5

2

3

7

5

mi

v

C

oh

_

a

_

0

0

2

3

2

pag

d

.

/

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

S. kelly y m. I. heywood

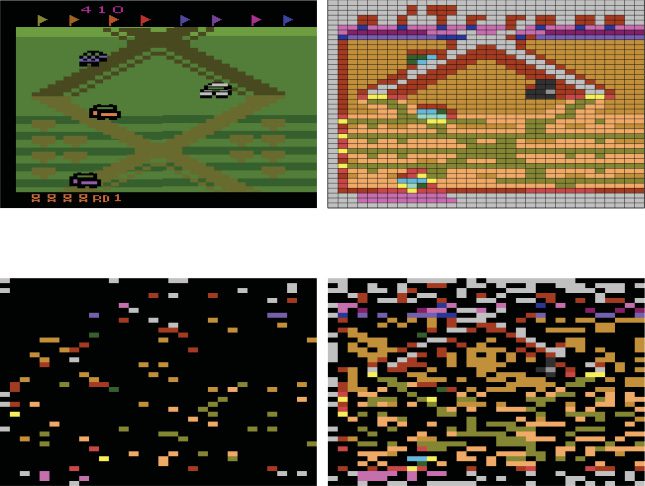

Cifra 4: Curvas de entrenamiento TPG, cada uno normalizado en relación con la puntuación de DQN en el mismo

juego (100%) y juego aleatorio (0%): (a) muestra curvas para el 27 juegos en los que TPG

finalmente superó el nivel de DQN en condiciones de prueba y (b) muestra curvas para el

21 juegos en los que TPG no alcanzó el nivel DQN durante la prueba. Tenga en cuenta que en varios juegos

TPG comenzó con políticas aleatorias (generación 1) que superó el nivel de DQN. Nota

que estos son puntajes de entrenamiento promediados durante 5 episodios en el título del juego dado, y son

por lo tanto, no es tan sólido como el puntaje de la prueba DQN utilizado para la normalización.. También, estas políticas fueron

a menudo degenerado. Por ejemplo, en ciempiés, es posible obtener una puntuación de 12,890 por

seleccionar la acción "disparar hacia arriba" en cada fotograma. Aunque es completamente poco interesante, this

La estrategia supera la puntuación de la prueba informada para DQN. (8,390) y la puntuación de la prueba reportada para

un probador de videojuegos profesional humano (11,963) (Mnih et al., 2015). Independientemente de su

punto de partida, Las políticas de TPG mejoran a lo largo de la evolución para volverse más receptivas

e interesante. Tenga en cuenta también que en Video Pinball, TPG superó la puntuación de DQN durante

entrenando pero no bajo prueba. La curva de La venganza de Moctezuma no aparece en la foto., un juego

en el que ninguno de los algoritmos obtiene puntos.

estrategia para el juego, TPG responde explícitamente a la pregunta de: (1) qué indexar del

representación estatal para cada juego; y (2) ¿Qué componentes de otras políticas candidatas

potencialmente incorporar dentro de una política más amplia. En cambio, DQN asume una partícula-

gran arquitectura, basado en una combinación específica de aprendizaje profundo y MLP, en el que todos los estados

la información siempre contribuye.

5.1 Competencia en el entorno de aprendizaje de Atari

La calidad de las políticas TPG se mide bajo las mismas condiciones de prueba que se utilizan para DQN.,

o la puntuación media sobre 30 episodios por título de juego con diferentes condiciones iniciales

y un máximo de 18,000 fotogramas por juego (Mnih et al., 2015; Nair et al., 2015). Diverso

Las condiciones iniciales se logran obligando al agente a seleccionar "ninguna acción" para la primera vez.-

fotogramas operativos de cada juego de prueba, donde no-op ∈ [0, 30], seleccionado con probabilidad uniforme en

360

Volumen de cálculo evolutivo 26, Número 3

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

/

mi

d

tu

mi

v

C

oh

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

2

6

3

3

4

7

1

5

5

2

3

7

5

mi

v

C

oh

_

a

_

0

0

2

3

2

pag

d

.

/

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

Aprendizaje por refuerzo emergente multitarea de alta dimensión

el comienzo de cada juego.10 Dado que algunos títulos de juegos derivan su semilla aleatoria de la inicial

acciones del jugador, el no-op estocástico asegura una semilla diferente para cada juego de prueba. estocástico

salto de fotograma, discutido en la Sección 2.1, implica variación en las semillas aleatorias y una

entorno estocástico durante el juego. Se aplican tanto el salto de fotograma como la no operación.

en este trabajo para garantizar un entorno estocástico y una comparación justa con DQN. Asimismo,

También se supone que se conocen las acciones disponibles por juego.11

Se consideran dos conjuntos de algoritmos comparadores.:

• Estado de captura de pantalla: construir modelos a partir del estado del juego, (cid:2)s(t ), definido en términos

de alguna forma de entrada de captura de pantalla.12 Estos incluyen el DQN profundo original

resultados de aprendizaje (Mnih et al., 2015), DQN implementado a través de un despliegue masivo-

búsqueda homenajeada (Nair et al., 2015), doble DQN (van Hasselt et al., 2016), y

hiper-ordenado (Hausknecht et al., 2014). Si bien el informe original de DQN enfatiza-

comparación de tamaño con un probador de juegos profesional humano (Mnih et al., 2015),

Aquí evitamos tal comparación principalmente porque los resultados en humanos no son

reproducible.

• Funciones de ingeniería: definir el estado del juego, (cid:2)s(t ), en términos de características diseñadas

a priori; thus, simplificando significativamente la tarea de encontrar políticas efectivas

para jugar, pero potencialmente introduciendo sesgos no deseados. Específicamente, el

Los resultados Hyper-NEAT y NEAT utilizan características de "Objeto" diseñadas a mano y específicas para

cada título de juego en el que diferentes “sustratos” denotan la presencia y ubicación-

ción de diferentes clases de objetos (véase Hausknecht et al., 2014 y la discusión

de Sección 2.2). Los resultados de Blob-PROST asumen características diseñadas a partir de un at-

Tentar a aplicar ingeniería inversa al proceso realizado por DQN. (Liang et al., 2016).

El espacio de estados resultante es un vector de ≈110 × 106 atributos de los cuales un lin-

Se construye el agente RL del oído. (vendaje). Finalmente, el agente Sarsa RL con mejor desempeño

(Conti-Sarsa) está incluido en el estudio DQN (Mnih et al., 2015) donde esto como-

asume la disponibilidad de funciones de “conciencia de contingencia” (Bellamare, Venecia

et al., 2012b).

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

/

mi

d

tu

mi

v

C

oh

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

2

6

3

3

4

7

1

5

5

2

3

7

5

mi

v

C

oh

_

a

_

0

0

2

3

2

pag

d

.

/

En cada caso, el TPG basado en la captura de pantalla se comparará con el conjunto de comparador.

modelos en un conjunto común de 49 Títulos de juegos de Atari. La significancia estadística será como-

evaluado mediante la prueba de Friedman, donde esta es una forma no paramétrica de ANOVA (Demšar,

2006; Japkowicz y Shah, 2011). Específicamente, Las pruebas de hipótesis paramétricas asumen com.-

mensurabilidad de las medidas de desempeño. Esto implicaría que promediar los resultados entre

múltiples títulos de juegos tienen sentido. Sin embargo, dado que el tamaño del paso de puntuación y los tipos de

Las propiedades medidas en cada título suelen ser diferentes., luego promediando el rendimiento de la prueba nula-

La rentabilidad entre varios títulos ya no es conmensurable.. En cambio, la prueba de Friedman

Establece si hay o no un patrón en las filas.. Rechazando la hipótesis nula

implica que hay un patrón, y la prueba post hoc de Nemenyi se puede aplicar para evaluar

el significado (Demšar, 2006; Japkowicz y Shah, 2011).

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

10Algunos títulos de juegos se verán más afectados que otros. Por ejemplo, títulos como Sra.. juego pac-man

una canción para los primeros ≈70 fotogramas del juego mientras se ignoran las acciones del agente (por lo tanto, la operación no operativa no tiene ningún efecto),

mientras que en otros títulos el agente toma el control inmediatamente.

11El estudio de Liang et al.. (2016) cuestiona esta suposición, pero descubre que un mejor rendimiento se refiere-

Resultó cuando los agentes RL se construyeron con el espacio de acción completo..

12Revisado en la sección 2.2 para algoritmos comparadores y se detalla en la Sección 4.1 para TPG.

Volumen de cálculo evolutivo 26, Número 3

361

S. kelly y m. I. heywood

En el caso de agentes RL derivados de información de estado de captura de pantalla (Mesa 7,

= 21.41 que para los efectos de la

Apéndice A), la prueba de Friedman arroja una χ 2

F

La hipótesis nula tiene un valor equivalente de la distribución F de FF = 5.89 (Demšar,

2006). El valor crítico correspondiente F (un = 0.01, 4, 192) es 3.48, de ahí el nulo hy-

la potesis es rechazada. Aplicando la prueba post hoc de Nemenyi (un = 0.05) proporciona una crítica

diferencia de 0.871. De este modo, en relación con el algoritmo mejor clasificado (Gorila), solo hiper-

NEAT se identifica explícitamente como fuera del conjunto de algoritmos de rendimiento equivalente

(o 2.63 + 0.871 < 3.87). This conclusion is also borne out by the number of game ti-

tles for which each RL agent provides best case performance; Hyper-NEAT provides 4

best case game titles, whereas TPG, Double DQN and Gorila return at least 11 best title

scores each (Table 7, Appendix A).

Repeating the process for the comparison of TPG13 to RL agents trained under

= 80.59 and an equiv-

hand crafted features (Table 8), the Friedman test returns a χ 2

F

alent value from the F-distribution of FF = 33.52. The critical value is unchanged as the

number of models compared and game titles is unchanged, hence the Null hypothesis

is rejected. Likewise the critical difference from the post hoc Nemenyi test (α = 0.05) is

also unchanged, 0.871. This time only the performance of the Conti-Sarsa algorithm is

identified as significantly worse (or 2.16 + 0.871 < 4.76).

In summary, these results mean that despite TPG having to develop all the architec-

tural properties of a solution, TPG is still able to provide an RL agent that performs as

well as current state of the art. Conversely, DQN assumes a common prespecified deep

learning topology consisting of millions of weights. Likewise, Hyper-NEAT assumes a

pre-specified model complexity of ≈900,000 weights, irrespective of game title. As will

become apparent in the next section, TPG is capable of evolving policy complexities

that reflect the difficulty of the task.

6

Simplicity through Emergent Modularity

The simplest decision making entity in TPG is a single team of programs (Figure 1a),

representing a standalone behaviour which maps quantized pixel state to output (ac-

tion). Policies are initialized in their simplest form: as a single team with between 2 and

ω programs. Each initial team will subsample a typically unique portion of the available

(input) state space. Throughout evolution, search operators will develop team/program

complement and may incrementally combine teams to form policy graphs. However,

policies will complexify only when/if simpler solutions are outperformed. Thus, solu-

tion complexity is an evolved property driven by interaction with the task environment.

By compartmentalizing decision making over multiple independent modules (teams),

and incrementally combining modules into policy graphs, TPG is able to simultane-

ously learn which regions of the input space are important for decision making and

discover an appropriate decision-making policy.

6.1

Behavioural Modularity

Emergent behavioural modularity in the development of TPG solutions can be visual-

ized by plotting the number of teams incorporated into the champion policy graph as

a function of generation (see Figure 5a). Development is nonmonotonic, and the speci-

ficity of team compliment as a function of game environment is readily apparent. For

example, a game such as Asteroids may see very little in the way of increases to team

complement as generations increase. Conversely, Ms. Pac-Man, which is known to be

13TPG still assumes screen capture state.

362

Evolutionary Computation Volume 26, Number 3

l

D

o

w

n

o

a

d

e

d

f

r

o

m

h

t

t

p

:

/

/

d

i

r

e

c

t

.

m

i

t

.

/

/

e

d

u

e

v

c

o

a

r

t

i

c

e

-

p

d

l

f

/

/

/

/

2

6

3

3

4

7

1

5

5

2

3

7

5

e

v

c

o

_

a

_

0

0

2

3

2

p

d

/

.

f

b

y

g

u

e

s

t

t

o

n

0

8

S

e

p

e

m

b

e

r

2

0

2

3

Emergent High-Dimensional Multitask Reinforcement Learning

l

D

o

w

n

o

a

d

e

d

f

r

o

m

h

t

t

p

:

/

/

d

i

r

e

c

t

.

m

i

t

.

/

/

e

d

u

e

v

c

o

a

r

t

i

c

e

-

p

d

l

f

/

/

/

/

2

6

3

3

4

7

1

5

5

2

3

7

5

e

v

c

o

_

a

_

0

0

2

3

2

p

d

/

.

f

b

y

g

u

e

s

t

t

o

n

0

8

S

e

p

e

m

b

e

r

2

0

2

3

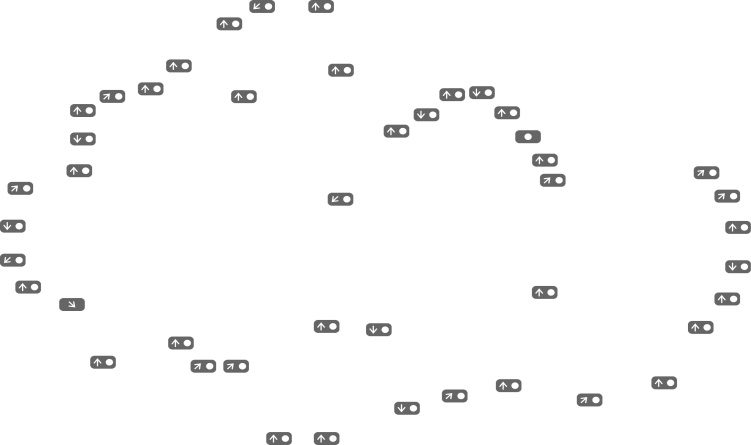

Figure 5: Emergent modularity. (a) Development of the number of teams per champion

policy graph as a function of generation and game title. The run labeled “Rand” reflects

the number of teams per policy when selection pressure is removed, confirming that

module emergence is driven by selective pressure rather than drift or other potential

biases. Black circles indicate the total number of teams in each champion policy, while

× symbols indicate the average number of teams visited to make each single decision

during testing. (b) Development of the proportion of input space indexed by champion

policies. Black circles indicate the total proportion indexed by each champion policy,

while × symbols indicate the average proportion observed to make each single decision

during testing. For clarity, only the 27 game titles with TPG agent performance ≥DQN

are depicted.

a complex task (Pepels and Winands, 2012; Schrum and Miikkulainen, 2016), saw the

development of a policy graph incorporating ≈200 teams. Importantly, making a deci-

sion in any single time step requires following one path from the root team to atomic

action. Thus, the cost in mapping a single game frame to an atomic action is not linearly

correlated to the graph size. For example, while the number of teams in the Alien policy

was ≈60, on average only 4 teams were visited per graph traversal during testing (see ×

symbols in Figure 5a). Indeed, while the total number of teams in champion TPG policy

graphs ranges from 7 (Asteroids) to 300 (Bowling), the average number of teams visited

per decision is typically less than 5 (Figure 5a).

6.2

Evolving Adapted Visual Fields

Each Atari game represents a unique graphical environment, with important events

occurring in different areas of the screen, at different resolutions, and from different

perspectives (e.g., global maze view versus first-person shooter). Part of the challenge

with high-dimensional visual input data is determining what information is relevant to

the task. Naturally, as TPG policy graphs develop, they will incrementally index more

of the state space. This is likely one reason why they grow more in certain environments.

Evolutionary Computation Volume 26, Number 3

363