¿PUEDE LA TECNOLOGÍA DEL VIDEO MEJORAR AL DOCENTE?

EVALUACIONES? UN ESTUDIO EXPERIMENTAL

Abstracto

La reforma de la evaluación docente ha estado entre las más controvertidas-

reformas educativas siales en los últimos años. También es uno de los costli-

est en términos del tiempo que los maestros y directores deben dedicar a

observaciones en el aula. Realizamos un ensayo de campo aleatorio en

cuatro sitios para evaluar si sustituir videos recopilados por maestros

para observaciones en persona podría mejorar el valor del maestro

observaciones para profesores, administradores, o estudiantes. Relativo

a los profesores del grupo de control que participaron en el estándar

observaciones en persona, docentes en el tratamiento video-basado

El grupo informó que las reuniones posteriores a la observación eran más “de apoyo”.-

portivo” y fueron más capaces de identificar una práctica específica

cambiaron después. Los directores del tratamiento pudieron cambiar

su trabajo de observación a tiempos no lectivos. El programa

también aumentó sustancialmente la retención de docentes. Sin embargo, el

La intervención no mejoró el rendimiento académico de los estudiantes ni

experiencias de aula autoinformadas, ya sea en el año del en-

intervención o para el próximo grupo de estudiantes. Siguiendo desde el

Literatura sobre ciclos de observación y retroalimentación en escenarios de bajo riesgo.-

tings, Nuestra hipótesis es que para mejorar los resultados de los estudiantes las escuelas

Es posible que deba combinar comentarios en video con soportes más específicos para

cambios deseados en la práctica.

https://doi.org/10.1162/edfp_a_00289

© 2019 Asociación para la política y las finanzas educativas

Tomas J.. kane

Escuela de Graduados de Harvard de

Educación

Cambridge, MAMÁ 02138

tom_kane@gse.harvard.edu

David Blázar

(Autor correspondiente)

Universidad de educación

Universidad de Maryland

parque universitario, Maryland 20742

dblazar@umd.edu

cazador gehlbach

Escuela de Educación

Universidad Johns Hopkins

2800 norte. Carlos San.

baltimore, Maryland 21218

gehlbach@jhu.edu

Miriam Greenberg

Centro de política educativa

Investigación

Escuela de Graduados de Harvard de

Educación

Cambridge, MAMÁ 02138

miriam_greenberg@gse

.harvard.edu

David M.. quinn

Escuela de Educación Rossier

Universidad del Sur

California

Los Angeles, California 90089

quinnd@usc.edu

Daniel Thal

Matemáticas

Cambridge, MAMÁ 02139

dthal@mathematica-mpr.com

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

F

/

mi

d

tu

mi

d

pag

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

1

5

3

3

9

7

1

8

9

3

7

3

1

mi

d

pag

_

a

_

0

0

2

8

9

pag

d

.

F

/

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

397

¿Puede el vídeo mejorar las evaluaciones de los profesores??

INTRODUCCIÓN

1 .

Citando evidencia de grandes diferencias en el rendimiento estudiantil entre individuos

aulas de profesores (Hanushek y Rivkin 2010), la administración Obama indignada-

Estados tivizados para rediseñar sus sistemas de evaluación docente a través de la Carrera hacia la Cima.

programa en 2009 y a través de su aprobación de planes estatales bajo el programa No Child Left

Detrás de la ley. Todavía, la evidencia del éxito de esos esfuerzos ha sido mixta. En lavado-

DC, chicago, y Newark, Las evaluaciones docentes de alto riesgo parecieron reducir la

tasas de retención de docentes de bajo rendimiento y aumentar la retención de docentes más efectivos.

profesores (Dee y Wyckoff 2015; Fulbeck y col.. 2016; Sartain y Steinberg 2016), ambos

resultados deseables. En Chicago y Cincinnati, la retroalimentación pareció mejorar la

práctica de los profesores existentes (taylor y tyler 2012; Steinberg y Sartain 2015). Cómo-

alguna vez, en otros estados, Muchos han considerado que tales beneficios son insuficientes para justificar el costo en

términos de controversia política, tiempo de maestro y director, y la capacidad de reclutar nuevos

y profesores de alta calidad (Jiang, En deportes, y luppescu 2015; Kraft y otros. 2019; Grabador

et al. 2019). Aunque las leyes permanecen en los libros, algunas agencias estatales han de-

Enfatizó la evaluación docente tras la aprobación del documento Every Student Succeeds.

actuar en 2015 (Sawchuk 2016).

Las evaluaciones de los docentes suelen incluir dos componentes principales: medidas basadas en pruebas

del crecimiento del rendimiento estudiantil y observaciones en el aula por parte de un administrador escolar.

Aunque las medidas basadas en pruebas tienden a generar la mayor controversia política

(Ballou y Springer 2015; Jiang, En deportes, y luppescu 2015), el componente más costoso,

en términos de tiempo del director y del maestro, es la observación en el aula. Según Dy-

Narciso (2016) y nuestras propias encuestas, los supervisores dedican entre diez y treinta horas

para cada profesor que realiza observaciones, escribiendo sus comentarios, y discutiendo el

resultados con los profesores. Cuando se multiplica por 3.1 millones de maestros de escuelas públicas, en el

salario promedio del director de aproximadamente $45 por hora (USDOE 2012; Dinarski 2016), el costo de las observaciones en persona estaría entre $1.4 y $4.2 mil millones por año. Estas grandes estimaciones tampoco tienen en cuenta los costos sociales adicionales., incluido el estrés tanto para los directores como para los profesores (Grissom, Loeb, y maestro 2013). Dado el tiempo dedicado a las observaciones en el aula., Nuestro objetivo era probar si la sustitución de la observación en persona por vídeos recopilados por los profesores podría mejorar el valor del proceso de evaluación para los profesores., administradores, y estudiantes. Nuestra hipótesis es que el vídeo digital ofrecería varias ventajas sobre la observación en persona.- vaciones: El vídeo proporciona una información más detallada., registro de terceros para profesores y directores- amigos para discutir; Ver vídeos de su propia instrucción puede ser más revelador para los profesores que las notas escritas de un observador.; dando a los profesores el control de la cámara- La era eleva el papel de los docentes en sus propias evaluaciones.; El vídeo permite a los directores cambiar el tiempo de sus tareas de observación a momentos más tranquilos del día o de la semana.; y el vídeo hace posible incorporar la perspectiva de observadores externos y expertos en contenidos.. Si se demuestra eficaz, La compra de tecnología basada en vídeo sería una forma relativamente económica de aumentar el valor de las observaciones de los profesores.. Estimamos que el costo del programa que evaluamos será aproximadamente $2,500 por profesor, que incluye: (1) el costo

de tabletas y soportes (que van desde $500 a $1,000 por unidad); (2) hardware de la computadora,

software, almacenamiento, y soporte de TI (apenas $1,500 por profesor); y (3) retroalimentación de 398 l D o w n o a d e desde h t t p : / / directo . mi t . / / partícula alimentada – pdlf / / / / 1 5 3 3 9 7 1 8 9 3 7 3 1 e d p _ a _ 0 0 2 8 9 pd / F . f por invitado 0 8 septiembre 2 0 2 3 Tomas J.. kane, David Blázar, cazador gehlbach, Miriam Greenberg, David M.. quinn, y Daniel Thal expertos en contenido externos (apenas $250 por profesor).1 Los costos probablemente serían sustancialmente

menor en años futuros, dadas economías de escala para este tipo de tecnología: Vídeos y

Las tabletas se pueden compartir entre profesores., y reutilizado a lo largo de los años escolares; y el marginal

El costo por el uso continuo o por agregar un maestro adicional es mucho menor que el de referencia.

costos de otro hardware y software.

Sin embargo, Ver vídeos de uno mismo puede ser desagradable y producir ansiedad. (Rayo-

lunes, Dorwick, y kleinke 1993). De este modo, expandirse más allá de los adoptantes voluntarios, enseñar-

Los usuarios necesitarán una razón y un incentivo para hacerlo.. Las escuelas de nuestro estudio ofrecieron a los profesores una

comercio: A cambio de la disposición de los profesores a utilizar vídeos para observaciones en el aula, enseñar-

Los estudiantes controlarían la cámara y elegirían qué videos de lecciones enviar para su sesión formal.

observaciones. Una plataforma de software segura permitió a los observadores, incluyendo tanto la evaluación formal-

uadores y expertos en contenidos, para ver los videos y proporcionar comentarios con marca de tiempo

alineados con momentos específicos en los videos. Estos vídeos y comentarios se utilizaron en

Discusiones individuales entre profesores, directores y expertos en contenido externos..

Para probar la eficacia de dicho sistema, Realizamos un ensayo de campo aleatorio que incluyó

433 profesores y 134 administradores escolares en cuatro sitios diferentes en Delaware, Georgia,

Colorado, y california.

Descubrimos que combinar las cámaras y la capacidad de sustituir el vídeo en-

Las observaciones personales cambiaron la forma en que se llevaron a cabo las evaluaciones de los docentes.. en el primero

año del estudio, la maestra promedio recopiló trece videos de su práctica, bastante

que las tres observaciones en persona generalmente requeridas para el proceso de evaluación formal-

duro. Siguiendo sus observaciones, los maestros en el grupo de tratamiento tenían más probabilidades

que aquellos en el grupo de control para informar que sus conversaciones posteriores a la observación con

los supervisores fueron “solidarios” y sus observaciones fueron “justas” (el lenguaje viene-

directamente de la encuesta de profesores). Los profesores del grupo de tratamiento también tenían más probabilidades de

identificar prácticas específicas que cambiaron después de ser observados y reunirse con sus

principal. Si bien las observaciones en video no ahorraron tiempo a los directores del grupo-

puerta, Los directores dedicaron menos tiempo al papeleo y más tiempo a observar e interactuar.

directamente con los profesores.

También encontramos que los profesores de tratamiento tenían sustancialmente más probabilidades de permanecer

en su escuela en el año siguiente a la intervención. Diferencias en las tasas de retención

alrededor 10 Los puntos porcentuales son mayores que muchas otras intervenciones educativas.. Nuestro

El diseño aleatorio no nos permite probar directamente los mecanismos que impulsan estos

efectos de retención. Sin embargo, Se ha proporcionado evidencia adicional sobre el papel del maestro-director.

relaciones en las salidas de profesores (Boyd et al. 2011; kraft, marinell, y si 2016), nosotros

Consideramos que los grandes efectos de retención son consistentes con los impactos que observamos en los docentes.

percepciones sobre el apoyo y la equidad de los supervisores.

Por último, aunque, la intervención no produjo diferencias mensurables en los estudios-

percepciones de mejora de la instrucción en el aula o mejor desempeño de los estudiantes en el estado

pruebas de matematicas y lectura. Se encontraron efectos nulos tanto al final del año de intervención

1. Para estimar los costos por maestro, Calculamos los costos totales pagados por este programa y los dividimos por el número.

de participantes en el tratamiento. Costos totales de computadora, incluido el hardware, software, almacenamiento, y el soporte de TI fueron

apenas $1.3 millones por aproximadamente 215 profesores; Los costos totales para los expertos en contenido externos fueron aproximadamente $215,000 para

el mismo número de profesores.

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

F

/

/

mi

d

tu

mi

d

pag

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

1

5

3

3

9

7

1

8

9

3

7

3

1

mi

d

pag

_

a

_

0

0

2

8

9

pag

d

.

F

/

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

399

¿Puede el vídeo mejorar las evaluaciones de los profesores??

y, para la primera cohorte de docentes, para los estudiantes a los que enseñaron en el año siguiente

la intervención. Dada la literatura más favorable sobre los impactos del coaching docente

(kraft, Blázar, y hogan 2018)—que también se basa en la observación de la práctica docente

pero en un entorno de bajo riesgo, planteamos la hipótesis de que el uso de videos para la evaluación de docentes-

Es posible que sea necesario combinar la información con retroalimentación directa sobre, y práctica relacionada con, específico

conductas instruccionales para generar cambios en los resultados de los estudiantes.

2 . REVISIÓN DE LITERATURA

Aunque la teoría de la acción que vincula las observaciones en el aula con la mejora del rendimiento de los estudiantes-

viene a menudo no se dice, se supone que (1) Las rúbricas de observación pueden identificar instrucciones.-

Comportamientos funcionales que están relacionados con los resultados de los estudiantes.; y (2) tales rúbricas proporcionan una

Vocabulario común que los profesores y supervisores pueden compartir para discutir aspectos clave de-

estructura; de modo que (3) Comentarios escritos y orales de un observador durante la post-observación.

La conferencia llevará al maestro a reconocer aspectos de su persona que antes no había reconocido.

su comportamiento que no cumple con los estándares, (4) la conversación entre el princi-

Un amigo y un maestro guiarán al maestro a identificar los cambios de instrucción que debe realizar.

hacer para mejorar los estándares, y (5) A pesar de la evidencia sobre la dificultad de

cambio de comportamiento adulto, la docente podrá incorporar las nuevas conductas en su

instrucción; y ultimamente (6) El rendimiento estudiantil aumentará como resultado de la mejora

comportamientos docentes.

Hay evidencia que respalda varias de estas proposiciones.. Por ejemplo, observación

Se ha demostrado que las puntuaciones en varias de las principales rúbricas de observación están correlacionadas.

con ganancias de rendimiento estudiantil (Kane y otros. 2013; Araujo et al. 2014; Blázar 2015a).

Además, Varios estudios han confirmado que cuando los observadores están entrenados en un

de las principales rúbricas de observación, pueden aplicarlos de manera confiable, aunque logran

un coeficiente de confiabilidad mayor que 0.7 requiere promediar entre varios observadores adultos

y varias lecciones (Bell et al. 2012; Colina, Charalambous, y kraft 2012; kane y

Staiger 2012). Mientras que la mayoría de las investigaciones anteriores se han basado en evaluadores capacitados para calificar las lecciones

por profesores que no saben, Se ha demostrado que los directores pueden calificar su propia enseñanza.-

Los videos de los estudiantes son tan confiables como los de los directores de otras escuelas., aunque con un movimiento ascendente en

puntuaciones medias (Ho y Kane 2013).

Un creciente conjunto de evidencia experimental sobre la formación docente indica que-

protocolos de observación para proporcionar a los maestros retroalimentación sobre su instrucción en un

Un entorno no evaluativo puede ayudarles a mejorar su desempeño en el aula., así como

Logro estudiantil. Un metaanálisis reciente de la evidencia causal sobre la efectividad

de coaching docente encontró efectos de tratamiento promedio de 0.49 desviaciones estandar (Dakota del Sur)

sobre la práctica docente observada y 0.18 SD sobre rendimiento estudiantil (kraft, Blázar, y

Hogan 2018). Aunque las prácticas de coaching pueden resultar en un mejor desempeño a través de

varios caminos posibles (p.ej., oportunidades para recibir comentarios directos, practicar enseñar-

habilidades de trabajo, observar modelos de enseñanza exitosa), Un mecanismo probable es la oportunidad.-

oportunidad de notar y reflexionar sobre la propia práctica. En efecto, El entrenador puede servir como

espejo con el que ver la propia práctica, un papel que el vídeo digital también podría desempeñar

en un entorno de evaluación de mayor importancia. Los estudios descriptivos han encontrado una asociación entre-

entre observaciones de videos por parte del docente y cambios en la práctica (Brunvand y Fishman

2006; Rosaen et al. 2008; Santagata y Angelici 2010; Kleinknecht y Schneider

2013).

400

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

/

F

mi

d

tu

mi

d

pag

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

1

5

3

3

9

7

1

8

9

3

7

3

1

mi

d

pag

_

a

_

0

0

2

8

9

pag

d

F

.

/

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

Tomas J.. kane, David Blázar, cazador gehlbach, Miriam Greenberg, David M.. quinn, y Daniel Thal

Algunos investigadores y profesionales han expresado su preocupación por la combinación de entrenadores-

intervenciones, que son deliberadamente de bajo riesgo y no evaluativos, con oficial

evaluación docente, lo que podría tener consecuencias para el empleo de los docentes, ganar-

ings, o relaciones laborales diarias (Kraft y Gilmour 2016). Por un lado, la ausencia de

Las consecuencias formales de las intervenciones de coaching pueden reducir la ansiedad de los profesores y hacer que

Son más receptivos a la retroalimentación.. Por otro lado, el incentivo para cambiar realmente

la práctica puede ser más débil cuando no hay nada en juego.

Nuestra revisión de un puñado de estudios de evaluación docente sugiere que, en determinadas

condiciones, Ambos tipos de intervenciones basadas en la observación pueden influir en el comportamiento de los docentes.-

resultados superiores y de los estudiantes. Por ejemplo, evidencia del programa IMPACT en Wash-

ington, corriente continua, indica que combinar evaluaciones docentes con incentivos financieros y

amenazas de despido (Dee y Wyckoff 2015) condujo a tasas de salida más altas para los de bajo rendimiento

profesores y algunas mejoras en la práctica docente de secundaria- y de alto rendimiento

profesores. Además, taylor y tyler (2012) estudió el impacto de la implementación de un-

mal, Observación en el aula basada en rúbricas para profesores experimentados en Cincinnati. (Ohio)

Escuelas públicas entre 2005 y 2010. Los profesores experimentados fueron evaluados cada cinco

años, basado en su fecha de contratación. Durante su año de evaluación, los maestros fueron observados

cuatro veces (tres veces por un observador capacitado externo a su escuela y una vez por

su supervisor o director). Después de cada observación en el aula., los observadores proporcionaron

comentarios escritos al maestro y se reunieron al menos una vez en persona. Controlando por

puntuaciones de referencia y características de los estudiantes, Los autores encontraron que el rendimiento de los estudiantes.

rosa 0.07 SD durante el año de evaluación y permaneció 0.11 SD más alta en el año siguiente

evaluación. Similarmente, Los profesores en un programa piloto en Chicago fueron evaluados múltiples

veces al año usando el Marco de Danielson para la Enseñanza (Danielson 2011) observar-

instrumento de ción. Los docentes que participaron en el sistema piloto de evaluación tuvieron mayores

rendimiento estudiantil en lectura de 0.10 Dakota del Sur (Steinberg y Sartain 2015).

3 . HIPÓTESIS

Nuestra hipótesis es que la introducción del vídeo mejoraría el proceso de evaluación.

de cinco maneras. Primero, la observación tradicional en persona tal como se practica en EE. UU.. escuelas—en

que un supervisor observa, tomar notas, y presenta comentarios escritos a los maestros—

puede aumentar innecesariamente las áreas de conflicto entre un maestro y un supervisor (Colina

y grossman 2013; Jiang, En deportes, y luppescu 2015; Kraft y Gilmour 2016). Alabama-

aunque las relaciones supervisor-empleado implican inherentemente cierta tensión, el des-

La designación del supervisor como tomador de notas invita innecesariamente a disputas sobre los hechos..

Los supervisores controlan el registro oficial de las conductas del profesor y de los estudiantes.

durante la observación (en forma de sus notas), así como la interpretación de

esos hechos. Hay un número casi infinito de datos generados en medio de

las interacciones entre un profesor y los estudiantes a lo largo de una lección. Un profesor

es notar y recordar solo un subconjunto; y el observador está notando otro—

subconjunto potencialmente no superpuesto. Aunque puede haber disputas sobre la interpretación-

información de lo que ocurrió en la lección, la grabación del vídeo esencialmente elimina

Posibles disputas sobre los hechos de lo que sucedió durante una lección..

Un segundo beneficio potencial del vídeo es brindar a los profesores oportunidades para apoyar-

complementar su propio recuerdo de una lección viéndola nuevamente desde otra perspectiva

punto. Al ver el video, pueden notar comportamientos que no habían notado en

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

/

F

mi

d

tu

mi

d

pag

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

1

5

3

3

9

7

1

8

9

3

7

3

1

mi

d

pag

_

a

_

0

0

2

8

9

pag

d

/

.

F

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

401

¿Puede el vídeo mejorar las evaluaciones de los profesores??

tiempo real, dados los límites de la memoria de trabajo y la visión periférica. También pueden

notar comportamientos que el observador tampoco registró en sus notas. Además, en esos

casos en los que las notas de un observador registran con precisión conductas que el maestro no

aviso en tiempo real, El video puede garantizar un mayor nivel de veracidad que la supervisión.-

notas de sor. De este modo, con un conjunto de datos más completo y preciso sobre los hechos de un

lección, un maestro tendría más oportunidades de reconocer los comportamientos que quiere

cambiar. Relacionado, Una tercera forma en que el vídeo puede cambiar el proceso de observación es, una vez

El maestro ha identificado un comportamiento que quiere cambiar., ella puede ser más capaz de practicar

conductas alternativas y, de este modo, verificar su éxito grabando y viendo las siguientes

lecciones.

Un cuarto beneficio potencial es que la capacidad de compartir videos electrónicamente reduce la

costo de involucrar a observadores, especialmente aquellos fuera de la escuela, con experiencia en un

área de contenido del profesor. (Ver, Por ejemplo, Una literatura cada vez mayor sobre el uso del vídeo para profesores.

Entrenamiento para aprovechar la experiencia externa.; Allen et al. 2011.) La evaluación requiere

identificar expertos en contenido y nivel de grado (Hill y Grossman 2013), que puede ser un

Desafío en la práctica desde la perspectiva de docentes y directores. (Kraft y Gilmour 2016).

Una quinta forma en la que planteamos la hipótesis de que nuestro tratamiento mejoraría la evaluación pro-

El proceso fue la capacidad de los profesores para seleccionar lecciones ex post.. Las escuelas de nuestra muestra

Normalmente se requería que los observadores dieran a los profesores 24 aviso de horas antes de un observador en persona-

vación, permitiendo así al profesor preparar mejor la lección que se va a observar. un maestro puede

prepararse ex ante, pero todavía está sujeta al riesgo de que la lección no salga como

planificado. En nuestra intervención, Los profesores podrían reducir su exposición al riesgo de sufrir en clase.

sorpresas al elegir enviar sólo aquellas lecciones que percibieron que habían ido bien. De

curso, Este proceso podría generar tanto beneficios como costos.. La reducción de docentes

La ansiedad resultante de la selección de lecciones ex post podría mejorar las relaciones en el lugar de trabajo..

Sin embargo, También podría hacer que las observaciones en el aula sean menos informativas para los supervisores.,

si oscureciera las malas prácticas docentes. Todavía, cuando otros profesores tienen lo mismo

oportunidad de elegir lecciones, La selección de lecciones por parte del profesor no tiene por qué impedir la supervisión.-

Sors de identificar a sus maestros más débiles.. Las mejores lecciones de los mejores profesores.

podría seguir siendo superior a las mejores lecciones de los profesores más débiles. (En el siguiente,

presentamos evidencia de que la selección de lecciones por parte de los maestros preservó en gran medida las clasificaciones en

puntuaciones de observación del profesor.)

La observación basada en video también podría estar desplazando la preparación de clases no relacionadas y

actividades de instrucción. El tiempo dedicado a planificar las lecciones que se grabarán o verán.-

Continuar las lecciones después podría disminuir el tiempo que dedican los profesores a prepararse para la ONU.-

lecciones grabadas.

4 . MÉTODOS

Evaluar los beneficios de la evaluación docente basada en vídeos., en la primavera de 2013, el estudio

El equipo reclutó directores en cuatro sitios.: pequeños distritos en todo el estado de Delaware, a

distrito mediano en Georgia, una colección de distritos más pequeños en Colorado, y un grande

distrito en california. El personal del proyecto reclutó por primera vez a escuelas para participar en una prueba de vídeo.-

evaluaciones basadas, y luego trabajó con líderes escolares para reclutar maestros. para una escuela

Ser elegible, un mínimo de tres profesores de una escuela deben haber aceptado participar

en el estudio. En sesiones de reclutamiento, Todos los profesores de los grados pertinentes fueron invitados a participar.-

anticipar. Después de las sesiones iniciales de reclutamiento, El personal del proyecto envió materiales a los directores.

402

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

F

/

/

mi

d

tu

mi

d

pag

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

1

5

3

3

9

7

1

8

9

3

7

3

1

mi

d

pag

_

a

_

0

0

2

8

9

pag

d

F

.

/

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

Tomas J.. kane, David Blázar, cazador gehlbach, Miriam Greenberg, David M.. quinn, y Daniel Thal

quien luego los envió a los maestros. Todos los materiales enmarcaron la participación como un “voluntario

oportunidad” para asegurar que los maestros no percibieran que los directores los estaban obligando a

participar.

En octubre 2013, escuelas elegibles (y los docentes de cada uno que aceptaron participar)

fueron asignados aleatoriamente al grupo de tratamiento o control. Este proceso se repitió

otra vez en 2014, cuando se reclutó una segunda cohorte de escuelas de la gran California-

distrito escolar de nia. La muestra aleatoria total estuvo compuesta por 134 administradores escolares

y 433 profesores. La asignación aleatoria se produjo a nivel de escuela dentro de cada uno de los

cuatro sitios de estudio, con 52 escuelas asignadas aleatoriamente al tratamiento y 55 las escuelas corrieron-

asignado normalmente al control. Había 85 escuelas en cohorte 1 (norte = 345 profesores y 107

administradores) y 22 en cohorte 2 (norte = 88 profesores y 27 administradores).2 Del

docentes participantes, 54 por ciento estaban en los grados superiores de primaria (es decir., calificación 4 o 5),

y 46 por ciento estaban en la escuela secundaria (es decir., Los grados 6 a través de 8).

Mientras que los profesores del grupo de control continuaron con su tradicional observación en persona.-

proceso de vación, Los profesores del grupo de tratamiento participaron en una intervención multifacética.-

ción diseñada para probar el valor de la observación y evaluación basada en videos.. Primero, profesores

recibieron una cámara de vídeo para grabar sus propias lecciones. Un contratista privado,

tablero de floración, proporcionó almacenamiento de vídeo y una plataforma de software para que los profesores recopilaran

Biblioteca de lecciones grabadas en video y artefactos de observación. (como planes de lecciones y mano-

salidas). Trabajar con un proveedor de hardware, allí ahora, el equipo de estudio distribuyó la cámara

kits a todos los docentes de tratamiento. Las cámaras incorporaron dos transmisiones de video. (uno para el

profesor y uno para estudiantes) y tres canales de audio (uno para el maestro y dos

para audio general en el aula). Al final de cada lección, el dispositivo portátil fusionó el

secuencias de vídeo y audio en un único archivo de vídeo. Cuando el dispositivo estaba conectado a un

Puerto Ethernet, el archivo fue canalizado de forma segura a la cuenta individual en línea de un maestro. Cada

el profesor tenía un inicio de sesión único, y solo ella podía ver y compartir videos en su cuenta.

Los docentes que se sumaron al proyecto en el segundo año utilizaron el dispositivo de grabación de video Swivl.

y dos micrófonos, ambos conectados a un iPad mini. En ambos años, profesores

eligieron cuál de estos videos subieron a Bloomboard desde su dispositivo.3 Los profesores

Se les pidió que grabaran dos lecciones por mes y cargaran todas las lecciones en el servidor seguro..

Los docentes eligieron tres videos para enviarlos a su evaluación formal, y dos vídeos para

visualización mediante comentarios no evaluativos de expertos en contenido fuera de la escuela.

Después de que un maestro compartiera un video con un observador, el observador inició sesión, etiquetado spe-

momentos cificos del video, y comentó sobre momentos específicos de la lección.. El

El software se personalizó para que las etiquetas correspondieran a las observaciones de cada distrito.-

rúbrica de ción. Las rúbricas variaron según el distrito o el estado., pero incluye muchos componentes similares

2. Una escuela participó en ambas cohortes., como escuela de control en cohorte 1 y una escuela de tratamiento en cohorte 2.

3.

En la primavera anterior al inicio del año escolar en el que tuvo lugar la intervención, participantes en el tratamiento-

El grupo de trabajo fue capacitado para utilizar la plataforma y las cámaras de video para sus observaciones.. La formación consistió

de tres a cuatro horas de actividades prácticas tipo taller. El equipo visitó cada sitio para la distribución de cámaras.

y entrenamiento, y recibió capacitación continua y soporte tecnológico. La capacitación incluyó orientación para el administrador.-

istradores sobre métodos para dar retroalimentación usando evidencia en video. La formación se centró en minimizar el profesorado.-

vulnerabilidad percibida, centrándose en los momentos de mayor influencia en el vídeo y utilizando estrategias de preguntas para

cambiar el análisis de la práctica del administrador al docente.

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

F

/

mi

d

tu

mi

d

pag

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

1

5

3

3

9

7

1

8

9

3

7

3

1

mi

d

pag

_

a

_

0

0

2

8

9

pag

d

/

F

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

403

¿Puede el vídeo mejorar las evaluaciones de los profesores??

(p.ej., planificación y preparación para la instrucción, entrega de instrucción, ambiente del aula-

ambiente, responsabilidades profesionales) que se alinean estrechamente con instrumentos ampliamente utilizados,

como el Marco Danielson (Danielson 2011). Durante la reproducción, el observador

Los comentarios aparecerían en el punto específico del video cuando el observador ingresaba.

a ellos. Luego, el observador compartió la evidencia en video y el comentario con el maestro.

antes de reunirse en persona para discutir los comentarios del video y determinar una puntuación final.4

La mayoría de los profesores de tratamiento también recibieron comentarios no evaluativos de los entrenadores profesionales.-

proporcionado por un contratista sin fines de lucro, TNTP (anteriormente el proyecto The New Teacher). TNTP como-

maestros firmados un entrenador basado en el área de contenido (es decir., educación elemental, matemáticas, o En-

artes del lenguaje inglés [ELLA]). Les pedimos a los maestros que compartieran dos videos con sus alumnos asignados.

entrenador: el primero en el otoño (octubre y noviembre) y el segundo en invierno (Enero

y febrero) de cada año escolar. Los entrenadores vieron los videos en la plataforma BloomBoard.-

formulario y comentarios escritos agregados dentro de una semana de la carga. Alentamos a los profesores

informar a su entrenador por teléfono después de cada observación, aunque no tenemos

un registro del número o contenido de las conversaciones telefónicas. Consistente con el programa

pautas, 76 Porcentaje de profesores completaron ambas sesiones de coaching virtual., y 96

por ciento completó uno de los dos. No somos capaces de desenredar la comunicación de coaching.-

componente de la intervención desde la evaluación basada en directores. Sin embargo, la intensidad

del coaching en esta intervención fue menor (dos sesiones) que muchos otros intervienen-

ciones centradas únicamente en el coaching, que a menudo incluyen varias observaciones de una semana

y ciclos de retroalimentación (kraft, Blázar, y hogan 2018).

Recopilación de datos

Durante toda la intervención, El equipo de investigación recopiló una variedad de fuentes de datos.

en los participantes tanto en el grupo de tratamiento como en el de control. Maestros y directores com-

completaron una encuesta de referencia preguntando sobre su experiencia docente y experiencias previas

con observaciones en el aula. En el primer año del estudio, Preguntamos a los profesores y al director.-

amigos para completar una encuesta posterior a la observación en la que reflexionaron sobre sus experiencias

con este proceso. También encuestamos a los directores semanalmente de noviembre a mayo.

del año de intervención respecto al tiempo dedicado a actividades de observación docente. (El

los datos de la encuesta semanal no se recopilaron en la cohorte 2.) En ambas cohortes, también encuestamos

maestros y directores al final del año escolar sobre su experiencia general con

el proceso de evaluación y observación. En los análisis que se presentan a continuación, nosotros llevamos a cabo

análisis de elementos individuales de la encuesta y, de este modo, no presentan índices de confiabilidad para

estas medidas.

El equipo del proyecto también administró una encuesta a los estudiantes al final de cada escuela.

año. Artículos de la encuesta (norte = 24) evaluó el grado en que los estudiantes experimentaron la

El ambiente del aula es atractivo., demandante, y apoyo a sus intelectuales.

crecimiento.5 Los análisis factoriales exploratorios indicaron dos factores con un valor propio superior 1.0

(kline 1994); El análisis de diagrama de pantalla también admite esta solución de dos factores. (Hayton, allen,

4. Muchos profesores también recibieron comentarios sobre el desarrollo. (que no contribuyó a su evaluación formal) en

dos de sus lecciones grabadas de un entrenador virtual proporcionado por TNTP. Este componente de la intervención fue

voluntario.

5. El instrumento de encuesta fue desarrollado por Hunter Gehlbach., informado por las construcciones de Tripod más altamente

correlacionado con el rendimiento estudiantil (Kane y Cantrell 2010).

404

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

F

/

/

mi

d

tu

mi

d

pag

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

1

5

3

3

9

7

1

8

9

3

7

3

1

mi

d

pag

_

a

_

0

0

2

8

9

pag

d

/

F

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

Tomas J.. kane, David Blázar, cazador gehlbach, Miriam Greenberg, David M.. quinn, y Daniel Thal

y Scarpello 2004). El primer factor está formado por todos los elementos. (alfa = 0.89) y que nosotros

considerar para medir las experiencias generales de los estudiantes en el aula. El segundo factor consiste

de siete artículos (alfa = 0.77) centrado en el comportamiento de los estudiantes en el aula y de los profesores.

capacidad de gestionar (mal)comportamiento en clase. Estos datos estaban disponibles para ambas cohortes en

el final del año de tratamiento, y para un subconjunto de cohortes 1 profesores al final del

año de seguimiento.

Finalmente, reunimos datos administrativos sobre las características de los estudiantes y logramos-

ment de los distritos participantes. Estos datos incluían información demográfica.

en estudiantes (es decir., género, raza/etnicidad, almuerzo gratis o a precio reducido [FRPL] elegibilidad,

aquellos que necesitan un plan educativo individualizado [PEI], y dominio limitado del inglés

[LEP] estado), así como actual- y puntajes de exámenes del año anterior en matemáticas y ELA en el estado

evaluaciones. Estandarizamos los puntajes de las pruebas dentro de los distritos por grado., sujeto, y año

utilizando toda la población de estudiantes. Después de que la intervención hubiera reclutado escuelas,

El estado de California anunció una pausa en todo el estado en las pruebas para la primavera de 2014,

mientras pusieron a prueba una nueva evaluación alineada con los Estándares Comunes, entonces el proyecto no tenía

Datos de rendimiento estudiantil para las escuelas de California durante el primer año.. En el primer año de

el estudio, Los registros administrativos también incluían puntuaciones de evaluación formal para los docentes..

Más, Utilizamos registros administrativos de los distritos para examinar

rotación de profesores. Como los datos administrativos sólo se recogieron a través de 2015, nuestra re-

Los análisis de atención se centran en la primera cohorte., a quién pudimos observar en el año de seguimiento.

Medimos la retención de tres maneras: si los profesores mantuvieron su enseñanza como-

firma en el año siguiente a la intervención, en la misma escuela y grado; si

Los maestros permanecieron en la misma escuela pero enseñaron un nuevo nivel de grado.;6 y si enseñar-

Los estudiantes permanecieron en su distrito pero se mudaron a una escuela diferente.. Los profesores restantes

no se observaron en los registros administrativos en el año de seguimiento. Inferimos que estos

los maestros abandonaron el distrito o enseñaron por completo.7

Validez externa

Nuestro objetivo era informar el diseño e implementación de sistemas de evaluación docente.

en todo Estados Unidos. Aunque nuestra muestra está formada por voluntarios, los participantes miran

similares a otros en sus respectivas escuelas y distritos en términos de estudiantes y maestros.

observables. Como se informa en la tabla 1, Los estudiantes y profesores participantes fueron similares a

no participantes. En columna 2, Comparamos a los profesores participantes y sus estudiantes con

Maestros y estudiantes no participantes dentro de la misma escuela. (es decir., incluyendo la escuela

efectos fijos), dado que la escuela tenía el nivel de aleatorización. Los participantes

Las aulas tenían un porcentaje ligeramente mayor de estudiantes elegibles para FRPL y un porcentaje ligeramente mayor de estudiantes elegibles para FRPL.

menor porcentaje de estudiantes con IEP. En columna 3, hacemos comparaciones entre

escuelas que participan en el experimento y otras escuelas de los distritos. No había

7.

6. Diferenciamos entre retenidos en la escuela y grado versus retenidos en la escuela, dada la investigación que indica que

cambiar de grado de un año a otro se asocia negativamente con mejoras en el rendimiento académico de los estudiantes

(Este 2014; Blázar 2015b; Atteberry, Loeb, y Wyckoff 2017).

Es posible que algunos de los docentes que no fueron observados en los registros administrativos en el año siguiente a la

La intervención movió las tareas de enseñanza de una manera que las hizo no observables en estos datos.. Por ejemplo,

en tres distritos solo teníamos estos registros para las escuelas primarias y secundarias. Por lo tanto, es posible que

Los profesores pueden haber pasado a enseñar en la escuela secundaria.. Creemos que ambos tipos de medidas tienen importancia

interés.

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

F

/

/

mi

d

tu

mi

d

pag

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

1

5

3

3

9

7

1

8

9

3

7

3

1

mi

d

pag

_

a

_

0

0

2

8

9

pag

d

.

/

F

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

405

¿Puede el vídeo mejorar las evaluaciones de los profesores??

Mesa 1. Validez externa: Participantes del estudio versus no participantes

Escuelas participantes

Participantes del estudio

Clases participantes -

Clases no participantes

Diferencia (SE)

Escuelas participantes —

Escuelas no participantes

Diferencia (SE)

Características de los estudiantes

Proporción masculina

Proporción elegible para FRPL

Proporción con IEP

Proporción designada LEP

Puntuación media anterior: Matemáticas

Puntuación media anterior: ELLA

Proporción afroamericano

Proporción asiática

Proporción de hispanos

Proporción de nativos americanos

Proporción de isleños del Pacífico

proporción blanca

Proporción de raza múltiple/otra

norte (Estudiantes)

Características del docente

Proporción masculina

0.511

0.577

0.102

0.264

0.077

0.057

0.186

0.063

0.385

0.007

0.001

0.339

0.019

22,950

0.291

Años promedio de experiencia docente.

10.330

Proporción afroamericano

Proporción de hispanos

proporción blanca

norte (Maestros)

0.087

0.180

0.669

426

−0,003

(0.005)

0.031**

(0.014)

−0,036***

(0.013)

−0,007

(0.004)

0.044

(0.041)

0.052

(0.035)

0.000

(0.004)

−0,003

(0.003)

−0,006

(0.005)

0.000

(0.000)

0.000

(0.000)

0.009

(0.005)

−0,000

(0.001)

−0,026

(0.041)

−0,107

(0.502)

−0,022

(0.018)

0.000

(0.025)

0.021

(0.030)

−0,001

(0.003)

−0,011

(0.043)

0.008

(0.005)

0.007

(0.034)

0.009

(0.060)

0.004

(0.065)

−0,008

(0.016)

0.006

(0.014)

−0,008

(0.040)

0.000

(0.001)

−0,000

(0.001)

0.009

(0.029)

0.001

(0.001)

−0,025

(0.022)

0.148

(0.176)

−0,002

(0.020)

0.013

(0.038)

−0,006

(0.036)

Notas: La muestra de estudiantes excluye las clases de educación especial. (definido como clases donde 75 por ciento o más de los estudiantes

tener un plan educativo individualizado, o PEI) Impartido por profesores que no pertenecen al proyecto.. La muestra también excluye a los estudiantes en tratamiento.

Clases de profesores que no tenían datos administrativos. (norte = 87; ver tabla 3 para la descripción de los datos faltantes). Las puntuaciones anteriores son

reportado en unidades de desviación estándar, después de estandarizar puntajes por estado, calificación, y sujeto. La diferencia entre el tratamiento

Profesores y profesores que no pertenecen a la muestra en las escuelas participantes. (columna 2) se estimó controlando los efectos fijos de la escuela. El

diferencia entre estudiantes y profesores en escuelas participantes y no participantes (columna 3) fue estimado después

controlando por efectos fijos de distrito. En todos los casos, errores estándar (SE) se informan entre paréntesis, y permitir la agrupación

dentro de una escuela. No se proporcionaron género y raza de los docentes para los docentes o escuelas que no pertenecen a la muestra en el distrito de Georgia y uno

de los distritos de Colorado, entonces esos sitios están excluidos de esas filas. Todos los sitios proporcionaron experiencia para todos los profesores.. FRPL =

almuerzo gratis o a precio reducido; LEP = dominio limitado del inglés; ELA = artes del lenguaje inglés.

**Significativo en el 95% nivel; ***significativo en el 99% nivel.

406

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

F

/

mi

d

tu

mi

d

pag

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

1

5

3

3

9

7

1

8

9

3

7

3

1

mi

d

pag

_

a

_

0

0

2

8

9

pag

d

/

F

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

Tomas J.. kane, David Blázar, cazador gehlbach, Miriam Greenberg, David M.. quinn, y Daniel Thal

diferencias para cualquiera de las características que observamos. Finalmente, en el cuadro A.1 del apéndice, nosotros

comparar los distritos participantes en Colorado y Delaware con los distritos no participantes,

encontrar sólo una diferencia por estado. No realizamos estos análisis para los sitios en

California o Georgia, donde teníamos solo un distrito por estado en nuestra muestra.

Validez interna

Mesa 2 Resume las diferencias en las características iniciales entre los estudiantes.

con profesores asignados aleatoriamente al grupo de tratamiento o de control. Con una excepcion,

ninguna de las diferencias en los rasgos observados de los administradores, profesores, o estudiantes fue

estadísticamente distinguible de cero al inicio del estudio. Una excepción es el porcentaje de

estudiantes asiáticos. Sin embargo, cuando las diferencias para todas las características se prueban conjuntamente utilizando

una prueba de Fisher-Pearson-Wald (Joven 2018), No encontramos diferencias entre los dos grupos.

(pag = 0.305).

Otra amenaza a la validez interna es el desgaste diferencial y la falta de datos entre

administradores participantes, profesores, y estudiantes, lo que podría resultar en un desequilibrio

grupos. Al inicio del experimento, 433 Los profesores aceptaron participar.. entre eso

hora y final del experimento, varios profesores abandonaron el estudio por uno de

tres razones: ya no quisieron participar en la intervención (norte = 10, incluir-

En g 6 en el grupo de tratamiento y 4 en el grupo de control); no pudieron participar

porque dejaron su escuela, el distrito, o la profesión docente (norte = 10, con

división equitativa entre tratamiento y control); o participaron en la intervención pero

no completaron/no hicieron que sus estudiantes completaran las encuestas de fin de año (norte = 18

para encuestas de profesores, con 4 del grupo de tratamiento y 14 del grupo de control;

norte = 23 para encuestas de estudiantes, con 9 del grupo de tratamiento y 14 desde el control

grupo). Del 134 administradores que originalmente aceptaron participar, cuatro dejaron su

escuela (división equitativa entre tratamiento y control), dos salieron del estudio (tanto de la

grupo de tratamiento), y once no completaron encuestas (uno del grupo de tratamiento y

diez del grupo de control). Para los resultados de las puntuaciones de las pruebas, pudimos capturar datos sobre la mayoría

profesores incluso si dejaron de participar en actividades de estudio. Sin embargo, nos faltan

datos de las puntuaciones de las pruebas de los estudiantes de los setenta y ocho profesores de California en el primer año de

el estudio, dada la pausa en las pruebas estatales ese año (que fue anunciado después del

inicio de nuestro estudio). Como resultado, Excluimos a los maestros de California del estudio basado en pruebas.

Resultados al final del primer año de implementación.; pudimos ver sus

Resultados de los estudiantes en el año siguiente.. De los profesores restantes, dieciocho fueron

no vinculado a los estudiantes en los datos administrativos (con siete del grupo de tratamiento

y once del grupo de control).

En mesa 3, Examinamos las diferencias en el porcentaje de participantes en el tratamiento.

y grupos de control con cada tipo de datos. Para la mayoría de los administradores- y nivel docente

resultados de la encuesta, No encontramos diferencias en las tasas de respuesta entre el tratamiento y el control.

grupos. Una excepción es que los administradores de las escuelas de tratamiento tenían más probabilidades de

para completar la encuesta de fin de año. Para resultados a nivel de estudiante, examinamos si

Hubo diferencias entre el tratamiento y el control en la proporción de docentes que

Cualquier estudiante que haya contribuido a los análisis. (puntuaciones de encuestas o exámenes), así como el

porcentaje de estudiantes de estos maestros que tenían datos de resultados. Aunque no encontramos

diferencias al final del año de intervención, encontramos diferencias en lo siguiente-

año en la proporción de docentes con estudiantes que contribuyeron a la encuesta o prueba

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

F

/

/

mi

d

tu

mi

d

pag

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

1

5

3

3

9

7

1

8

9

3

7

3

1

mi

d

pag

_

a

_

0

0

2

8

9

pag

d

.

/

F

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

407

¿Puede el vídeo mejorar las evaluaciones de los profesores??

Mesa 2.

Validez interna: Diferencia entre los grupos de tratamiento y control al inicio del estudio

Media de control

Tratamiento: diferencia de control (SE)

Características del administrador

Proporción masculina

Años como administrador

Proporción afroamericano

Proporción de hispanos

proporción blanca

norte (Administradores)

Prueba de Fisher Pearson-Wald

Características del docente

Proporción masculina

Años como profesor

Proporción afroamericano

Proporción de hispanos

proporción blanca

norte (Maestros)

Prueba de Fisher Pearson-Wald

Características de los estudiantes

Proporción masculina

Proporción elegible para FRPL

Proporción con IEP

Proporción designada LEP

Puntuación media anterior: Matemáticas

Puntuación media anterior: ELLA

Proporción afroamericano

Proporción asiática

Proporción de hispanos

Proporción de nativos americanos

Proporción de isleños del Pacífico

proporción blanca

0.397

10.302

0.283

0.200

0.483

0.234

11.709

0.175

0.144

0.593

0.509

0.590

0.110

0.280

0.086

0.079

0.164

0.049

0.401

0.007

0.001

0.358

Proporción Múltiple/Otra raza

0.020

norte (Estudiantes)

Prueba de Fisher Pearson-Wald

12,759

0.113

(0.083)

−1.076

(1.248)

−0,056

(0.067)

−0,007

(0.056)

0.079

(0.072)

129

pag = 0.826

−0,023

(0.039)

0.450

(0.697)

0.066

(0.044)

−0,013

(0.034)

−0,023

(0.046)

426

pag = 0.697

−0,007

(0.010)

0.035

(0.034)

0.006

(0.016)

0.027

(0.021)

−0,016

(0.073)

0.013

(0.063)

0.005

(0.027)

−0,030**

(0.013)

0.016

(0.023)

−0,001

(0.003)

−0,000

(0.001)

0.008

(0.028)

0.003

(0.003)

22,950

pag = 0.305

408

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

F

/

mi

d

tu

mi

d

pag

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

1

5

3

3

9

7

1

8

9

3

7

3

1

mi

d

pag

_

a

_

0

0

2

8

9

pag

d

.

F

/

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

Tomas J.. kane, David Blázar, cazador gehlbach, Miriam Greenberg, David M.. quinn, y Daniel Thal

Mesa 2. Continuado.

Notas: La diferencia ajustada entre control y tratamiento es el resultado de una regresión de la dependencia.-

variable determinante frente a efectos fijos para estratos de aleatorización y un indicador de tratamiento. Errores estándar

(SE) se informan entre paréntesis, y en los modelos de docente y administrador permiten la agrupación

dentro de una escuela. Las características de la escuela son del año escolar 2012-13., como eran los mas recientes

datos disponibles en el momento de la aleatorización. FRPL = almuerzo gratis o a precio reducido; PEI = individualizado

plan educativo; LEP = dominio limitado del inglés; ELA = artes del lenguaje inglés.

**Significativo en el 95% nivel.

Mesa 3. Desgaste y datos faltantes

Año agrupado 1

Grupo 1 Año de seguimiento

Media de control

Tratamiento - Control

Diferencia (SE)

Media de control

Tratamiento - Control

Diferencia (SE)

Resultados del administrador

Encuesta de fin de año

Encuesta posterior a la conferencia

Encuesta de uso del tiempo

Resultados docentes

Encuesta de fin de año

Encuesta posterior a la conferencia

Puntuación de observación oficial

Resultados de los estudiantes

0.815

0.849

0.962

0.888

0.877

0.788

Encuesta de fin de año: El profesor tiene alumnos con datos.

0.893

Encuesta de fin de año: Proporción de encuestas de estudiantes devueltas

0.755

Resultados de las pruebas: El profesor tiene alumnos con datos.

Resultados de las pruebas: Proporción de estudiantes que están presentes

que están en muestra de análisis

0.936

0.970

0.110**

(0.051)

0.073

(0.053)

0.033

(0.022)

0.040

(0.031)

0.038

(0.038)

0.058

(0.054)

0.021

(0.034)

0.039

(0.043)

0.030

(0.032)

−0,010

(0.006)

0.875

0.758

0.652

0.859

−0,181**

(0.068)

−0,069

(0.069)

0.125**

(0.050)

0.033

(0.036)

Notas: La diferencia ajustada entre control y tratamiento es el resultado de una regresión de la variable dependiente contra efectos fijos para

estratos de aleatorización y un indicador de tratamiento. Errores estándar (SE) se informan entre paréntesis, y permitir la agrupación dentro de la escuela. Para

resultados a nivel de estudiante, Las muestras reflejan estudiantes de profesores para quienes tenemos datos disponibles.. Estudiantes cuyos profesores no impartieron clase.

listas para la encuesta de fin de año o no estaban en los archivos de calificaciones de las pruebas, no fueron incluidos.

**Significativo en el 95% nivel.

análisis de puntuación. Los profesores de tratamiento tenían menos probabilidades de realizar encuestas a los estudiantes en los siguientes casos-

año arriba. Los profesores de tratamiento tenían más probabilidades de tener datos de las puntuaciones de las pruebas de sus alumnos.

Como resultado, Interpretamos estos análisis de seguimiento con cautela..

Análisis de los datos

Analizamos el efecto en nuestros docentes., principal-, y medidas de resultados a nivel de estudiante

utilizando la siguiente especificación, en el que Y representa un resultado de interés dado

medido al final del año de evaluación para docentes, administrador, o estudiante j en

escuela s en el distrito d:

Yjsd = βTratamiento jsd + πd + ε jsd.

(1)

409

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

/

F

mi

d

tu

mi

d

pag

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

1

5

3

3

9

7

1

8

9

3

7

3

1

mi

d

pag

_

a

_

0

0

2

8

9

pag

d

/

F

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

¿Puede el vídeo mejorar las evaluaciones de los profesores??

Incluimos efectos fijos para bloques de aleatorización., πd. Como estos bloques son exclusivos de

distrito y año escolar, No incluimos indicadores adicionales por distritos o años.. Nosotros

agrupar nuestros errores estándar a nivel escolar para tener en cuenta los experimentos agrupados

diseño. el coeficiente, b, en el indicador de si un maestro estaba en una escuela que

fue asignado aleatoriamente al tratamiento es nuestro parámetro de interés.

Diseñamos la intervención para detectar un efecto del tratamiento tan pequeño como 0.05 Dakota del Sur. Cómo-

alguna vez, Es posible que los efectos sean menores., particularmente para resultados menos próximos

a la intervención (p.ej., puntuaciones de las pruebas de los estudiantes). Por lo tanto, para aumentar el poder estadístico

al analizar el efecto de la intervención en los puntajes de las pruebas de los estudiantes, incluimos un rico

conjunto de covariables. (Para análisis de resultados a nivel docente, la única variable del lado derecho-

Las variables incluidas en nuestros modelos son el indicador de tratamiento y los efectos fijos para-

bloque de ización.) Las covariables a nivel de estudiante incluyen un polinomio cúbico en el mismo año anterior.-

puntuación de la prueba de materia, una interacción entre la calificación del estudiante y la prueba de la misma materia del año anterior

puntaje, un término lineal para la puntuación de la prueba de la materia opuesta del año anterior con una variable ficticia para aquellos

faltar la prueba del sujeto opuesto, indicadores de nivel de grado, género, siete categorías para

raza/etnicidad, un indicador de elegibilidad para FRPL, un indicador del estado de educación especial,

y un indicador para estudiantes LEP. Clase- y las covariables de escuela por nivel de grado incluyen

el promedio de toda la clase y de la escuela por grado de todas las covariables a nivel de estudiante, excepto

que la puntuación de la prueba del año anterior en la misma materia solo se incluye linealmente. En algunos de los estudiantes-

modelos de nivel, También incluimos la puntuación de valor agregado de los profesores del año anterior en la misma materia.

como la puntuación de la prueba del estudiante. Si faltaba la puntuación de valor añadido, imputamos a la media

e incluyó un indicador de falta. Todas las covariables interactuaron con el sitio y

con tema. Los impactos en los puntajes de las pruebas de los estudiantes que se muestran a continuación son similares cuando excluimos

estas covariables y solo incluyen efectos fijos para el bloque de aleatorización.

Recopilamos una variedad de medidas de resultado que nos permitieron identificar el impacto de la

tratamiento sobre la mediación de resultados, tales como las percepciones de los docentes y supervisores sobre el

proceso de evaluación, así como los resultados de los estudiantes. Sin embargo, pruebas estadísticas en múltiples

Los resultados podrían llevarnos a observar un falso positivo debido a múltiples pruebas de hipótesis..

Por lo tanto, dentro de categorías de resultados que se centran en constructos subyacentes similares

(es decir., resultados incluidos en la misma tabla), ajustamos los valores p con Bonferroni, Échale un vistazo,

y correcciones de Holm-Bonferroni.

5 . RESULTADOS

Relación entre puntuaciones de vídeos seleccionados y no seleccionados por profesores

Darles a los maestros el control de las cámaras puede haber aumentado su disposición a usar cámaras-

eras, pero permitir a los profesores seleccionar qué vídeos enviar para una evaluación formal podría

han hecho más difícil identificar a los docentes con mala instrucción. En esta sección

Comparamos el desempeño de los docentes en los videos enviados para evaluación formal.

con los otros vídeos (hasta once) grabado pero no compartido con un supervisor (pero pos-

incluir posiblemente los videos enviados a los expertos en contenido externos para fines no evaluativos.

comentario). Un estudio anterior de Ho y Kane (2013) sugirió los rankings de enseñanza

Practique usando los videos que los maestros eligieron compartir con sus supervisores para asuntos de alto riesgo.

Las evaluaciones fueron similares a las clasificaciones en el conjunto completo de videos de un maestro.. En Hillsbor-

condado de ough, Florida, Docentes participantes en el proyecto Medidas de Enseñanza Efectiva.

Se les permitió elegir cuál de sus videos sería musicalizado por sus propios directores..

Sin embargo, cualquiera de sus videos podría ser calificado por otros directores y pares observadores en

410

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

/

F

mi

d

tu

mi

d

pag

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

1

5

3

3

9

7

1

8

9

3

7

3

1

mi

d

pag

_

a

_

0

0

2

8

9

pag

d

F

.

/

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

Tomas J.. kane, David Blázar, cazador gehlbach, Miriam Greenberg, David M.. quinn, y Daniel Thal

Condado de Hillsborough. Si bien la calificación media de observación fue 0.19 SD más alta en el

vídeos seleccionados por el profesor, la correlación desatenuada entre la puntuación de un profesor en la

videos enviados a los supervisores y los videos restantes fueron aproximadamente 1. Mientras

la mayoría de los profesores obtuvieron mejores resultados en los vídeos seleccionados (una señal de que los profesores de-

se mantuvo la rúbrica, ya que pudieron identificar cuál de sus lecciones obtendría una mejor puntuación),

Las clasificaciones fueron en gran medida las mismas en las lecciones seleccionadas por el profesor que en las no seleccionadas.

lecciones.

En el presente estudio, por cada vídeo elegido por una profesora para compartir con su administrador-

istrator para su evaluación formal, Elegimos al azar un vídeo del mismo periodo.

del año escolar, que el profesor subió a nuestro servidor pero decidió no enviar

a su supervisor. Identificamos una muestra de 197 tales vídeos de una muestra de sesenta

Maestros seleccionados aleatoriamente del grupo de tratamiento. (treinta elemental, quince a mediados-

matemáticas de la escuela dle, quince ELA de secundaria). Contratamos a una organización sin fines de lucro.-

zación, piedra de enseñanza, Calificar los videos usando la rúbrica de observación de CLASS. (Martillo,

Planta, y Choomat-Mooney 2009) y evaluado en cuatro dominios de la práctica docente.-

tice: Soporte emocional, Organización del aula, Apoyo educativo, y estudiante

Compromiso. (No le revelamos a Teachstone qué vídeos se habían enviado a un

supervisor del maestro para la evaluación formal.) Teachstone asignó ocho evaluadores para calificar

vídeos de escuela secundaria, y siete evaluadores para calificar videos de primaria. Cada evaluador puntuó

dos vídeos: uno elegido para fines de evaluación de alto riesgo y otro no elegido para

este propósito, de los treinta maestros en su rango de grado. Los evaluadores fueron certificados en el

Rúbrica de CLASS antes del proyecto y requerida para calibrar en cuatro ocasiones distintas

durante el proyecto.

Las puntuaciones medias de los vídeos elegidos para formales, evaluación de alto riesgo fueron ap-

aproximadamente 0.25 SD más alto que los puntajes en otros videos de los profesores. Sin embargo, el dis-

la correlación atenuada entre los dos tipos de vídeos fue moderadamente alta (0.75).8 En

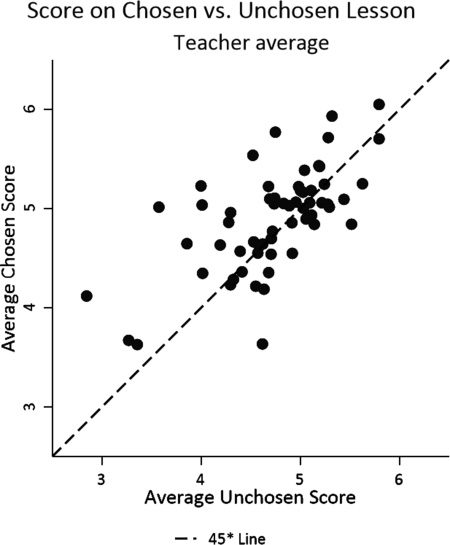

figura 1, Ilustramos estos patrones presentando un diagrama de dispersión de las puntuaciones de las lecciones entre

los dos conjuntos de videos. Calculamos la puntuación media de los vídeos de cada uno de estos dos.

grupos, promediando las puntuaciones de todos los evaluadores. El eje horizontal mide el promedio

puntuación en las lecciones que el maestro no entregó a su administrador, según lo anotado por

los observadores en su grupo de grado; el eje vertical mide la puntuación media en

las lecciones que el mismo profesor decidió presentar para evaluación formal. La línea de puntos

en la figura 1 representa la línea de 45 grados, en qué puntuaciones habrían sido idénticas.

Para dos tercios de los profesores, la puntuación promedio en la lección elegida para la evaluación formal-

La calificación fue mayor que sus otras lecciones.. Sin embargo, como se muestra en la figura 1, los maestros

quienes obtuvieron mejores puntajes en las lecciones utilizadas para la evaluación de alto riesgo también tendieron a obtener puntajes

más alto en las lecciones restantes grabadas en video.9 En otras palabras, aunque los profesores lo hicieron

8. Siguiendo a Ho y Kane (2013), Calculamos la correlación desatenuada de la siguiente manera.:

ρ = Covarianza(Puntuación elegida,i,r ,Puntuación no elegida,i,r

√

relelegido∗relunchose

(cid:2) )

,

donde puntuación elegida,i,r es la puntuación de un vídeo elegido para la evaluación formal por parte del profesor i por el evaluador r, Puntuación no elegida,i,r(cid:2) es

la puntuación de un vídeo no elegido del profesor i por un evaluador diferente r

, y relelegidos y relunchados son la confiabilidad

de partituras de vídeo elegidas y no elegidas, respectivamente.

(cid:2)

9. Las medidas utilizadas en la figura 1 demostrar una correlación de 0.64. La correlación difiere de la desatenuada.

correlación reportada anteriormente porque incluye error de medición, así como otros componentes de variación.

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

/

F

/

mi

d

tu

mi

d

pag

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

1

5

3

3

9

7

1

8

9

3

7

3

1

mi

d

pag

_

a

_

0

0

2

8

9

pag

d

F

/

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

411

¿Puede el vídeo mejorar las evaluaciones de los profesores??

yo

D

oh

w

norte

oh

a

d

mi

d

F

r

oh

metro

h

t

t

pag

:

/

/

d

i

r

mi

C

t

.

metro

i

t

.

F

/

/

mi

d

tu

mi

d

pag

a

r

t

i

C

mi

–

pag

d

yo

F

/

/

/

/

1

5

3

3

9

7

1

8

9

3

7

3

1

mi

d

pag

_

a

_

0

0

2

8

9

pag

d

/

F

.

F

b

y

gramo

tu

mi

s

t

t

oh

norte

0

8

S

mi

pag

mi

metro

b

mi

r

2

0

2

3

Notas: Cada punto es un promedio de siete puntuaciones cada uno en videos elegidos y no elegidos para maestros de primaria.. para la escuela secundaria

profesores, cada punto es un promedio de ocho puntuaciones cada uno en videos elegidos y no elegidos.

Cifra 1. Puntuación de lecciones grabadas en vídeo elegidas para evaluación formal (es decir., vídeo “elegido” en el eje y) frente a otras lecciones grabadas en vídeo no

Compartido con administrador (es decir., vídeo "no elegido" en el eje x).

seleccione sus mejores videos para enviar, la clasificación del desempeño de los docentes fue en gran medida